Содержание

- Часть 1 — Теория и архитектура

- Часть 2 — Практическое знакомство

- Часть 3 — Результаты игровых тестов и выводы

Представляем базовый детальный материал с исследованием Nvidia GeForce GTX 1080 Ti.

Объект исследования: Ускоритель трехмерной графики (видеокарта) Nvidia GeForce GTX 1080 Ti 11 ГБ 352-битной GDDR5X

Сведения о разработчике: Компания Nvidia Corporation (торговая марка Nvidia) основана в 1993 году в США. Штаб-квартира в Санта-Кларе (Калифорния). Разрабатывает графические процессоры, технологии. До 1999 года основной маркой была Riva (Riva 128/TNT/TNT2), с 1999 года и по настоящее время — GeForce. В 2000 году были приобретены активы 3dfx Interactive, после чего торговые марки 3dfx/Voodoo перешли к Nvidia. Своего производства нет. Общая численность сотрудников (включая региональные офисы) около 5000 человек.

Часть 1: Теория и архитектура

В своем обзоре видеокарты Nvidia GeForce GTX 1080 мы писали о том, что она основана не на самом мощном графическом процессоре архитектуры Pascal, и что в будущем планируется выпуск как минимум еще одного более мощного решения, которое будет использовать GPU большего размера и мощности. Со временем так и случилось, когда вышла видеокарта для ультра-энтузиастов Titan X на основе чипа GP102, но она стоит слишком дорого и не входит в линейку GeForce GTX 10. Разница между этими двумя моделями в скорости довольно велика, Titan X предназначен для наиболее обеспеченных энтузиастов из отдельной ниши рынка.

Было понятно, что придет время и для почти столь же мощной видеокарты, но с меньшей ценой и входящей в состав основной игровой линейки. По слухам, Nvidia уже очень давно подготовила такую видеокарту, но в условиях фактически отсутствующей конкуренции в верхнем ценовом сегменте, просто не было смысла выпускать гипотетический GeForce GTX 1080 Ti и терять те деньги, которые можно было заработать, продавая еще какое-то время более дорогой Titan X.

И вот уже практически весной, воспользовавшись формальным поводом в виде конференции для игровых разработчиков GDC 2017, компания Nvidia таки решила выпустить GeForce GTX 1080 Ti в продажу, нацелив новинку в более массовый ценовой диапазон, по сравнению с элитной Titan X, но также предназначенную для самых требовательных применений в любых условиях, включая виртуальную реальность, и предлагающая даже чуть большую производительность. Кстати, по какой-то недоброй иронии судьбы модель Titan X появилась в официальной продаже в нашей стране буквально за несколько дней до этого анонса, что вряд ли положительно повлияет на ее продажи у нас. GeForce GTX 1080 Ti просто обязана продаваться куда более массово!

Не очень понятны причины анонса именно в это время. То ли в Nvidia устали ждать выхода мощного решения от конкурирующей компании AMD, то ли заскучали без обновлений собственной линейки в верхней части рынка, то ли на горизонте уже замаячил выход каких-то решений абсолютно новой архитектуры следующего поколения Volta — этого мы не знаем. Факт лишь в том, что в конце февраля была анонсирована GeForce GTX 1080 Ti, сегодня мы публикуем ее обзор, а уже с завтрашнего дня эта видеокарта начнет продаваться в магазинах.

GeForce GTX 1080 Ti — это модель высшего класса, основанная на топовом графическом процессоре GP102 текущей архитектуры Pascal. Техпроцесс 16 нм FinFET компании TSMC постепенно улучшился за все эти месяцы, наконец-то достигнув той стадии, при которой выпуск таких больших чипов по вменяемой цене стал выгоден для Nvidia, которая обычно не стесняется выставлять достаточно высокие цены — особенно в отсутствие реальной конкуренции. К слову, что-то отдаленно похожее по производительности на уровень GTX 1080 и GTX 1080 Ti у компании AMD ожидается, скорее, во втором квартале этого года, и скорее, к его концу — то есть в мае-июне. До этого времени GeForce GTX 1080 Ti абсолютно точно будет самым производительным игровым решением на рынке.

Напомним, что графические процессоры архитектуры Pascal отличаются от Maxwell не слишком сильно, но применение нового технологического процесса позволило сделать заметно более сложные GPU, имеющие повышенное количество исполнительных блоков и работающие на значительно более высокой частоте. Архитектура Pascal является самой последней разработкой Nvidia на данный момент, и все графические процессоры, основанный на ней, отличаются высокой энергоэффективностью. Увеличенное количество потоковых процессоров и весьма высокая тактовая частота позволит GTX 1080 Ti стать самой мощной, или немного обогнав Titan X, или выступив наравне с ним.

А чтобы обеспечить мощнейший GPU необходимым количеством данных с высокой скоростью, в GeForce GTX 1080 Ti используется еще более быстрая видеопамять нового типа GDDR5X, а также присутствуют некоторые оптимизации по сравнению с Maxwell, хотя в своей основе эти архитектуры весьма похожи друг на друга. Среди оптимизаций производительности можно выделить улучшенное сжатие цветовой информации, а также тайловое кэширование, о котором мы подробно поговорим далее — обе эти техники позволяют экономить пропускную способность памяти.

Так как новая модель видеокарты компании Nvidia основана на графическом процессоре архитектуры Pascal, имеющей много общего с предыдущей архитектурой Maxwell, то перед прочтением данного материала мы советуем ознакомиться с ранними статьями о наиболее заметных видеокартах этой компании:

- [17.05.16] Nvidia GeForce GTX 1080 — новый лидер игровой 3D-графики на ПК

- [01.06.15] Nvidia GeForce GTX 980 Ti — самый производительный однопроцессорный ускоритель игрового класса

- [22.04.15] Nvidia GeForce GTX Titan X — самый мощный однопроцессорный ускоритель

- [19.09.14] Nvidia GeForce GTX 980 — последователь GeForce GTX 680, обгоняющий даже GTX 780 Ti

- [12.03.14] Nvidia GeForce GTX 750 Ti — Maxwell начинает с малого... несмотря на Maxwell

Рассмотрим подробные характеристики видеоплаты GeForce GTX 1080 Ti, основанной на графическом процессоре GP102.

| Графический ускоритель GeForce GTX 1080 Ti | |

|---|---|

| Параметр | Значение |

| Кодовое имя чипа | GP102 |

| Технология производства | 16 нм FinFET |

| Количество транзисторов | 12 млрд. (у GP104 — 7,2 млрд.) |

| Площадь ядра | 471 мм² (у GP104 — 314 мм²) |

| Архитектура | Унифицированная, с массивом общих процессоров для потоковой обработки многочисленных видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12, с поддержкой уровня возможностей Feature Level 12_1 |

| Шина памяти | 352-битная: 11 (из 12 физически имеющихся в GPU) независимых 32-битных контроллеров памяти с поддержкой GDDR5 и GDDR5X памяти |

| Частота графического процессора | 1480 (1582) МГц |

| Вычислительные блоки | 28 потоковых мультипроцессоров, включающих 3584 скалярных ALU для расчетов с плавающей запятой в рамках стандарта IEEE 754-2008; |

| Блоки текстурирования | 224 блока текстурной адресации и фильтрации с поддержкой FP16- и FP32-компонент в текстурах и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растровых операций (ROP) | 11 (из 12 физически имеющихся в GPU) широких блоков ROP (88 пикселей) с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16- или FP32-формате буфера кадра. Блоки состоят из массива конфигурируемых ALU и отвечают за генерацию и сравнение глубины, мультисэмплинг и блендинг |

| Поддержка мониторов | Интегрированная поддержка до четырех мониторов, подключенных по интерфейсам HDMI 2.0b и DisplayPort 1.2 (1.3/1.4 Ready) |

| Спецификации референсной видеокарты GeForce GTX 1080 Ti | |

|---|---|

| Параметр | Значение |

| Частота ядра | 1480 (1582) МГц |

| Количество универсальных процессоров | 3584 |

| Количество текстурных блоков | 224 |

| Количество блоков блендинга | 88 |

| Эффективная частота памяти | 11010 (2×5505) МГц |

| Тип памяти | GDDR5X |

| Шина памяти | 352-бит |

| Объем памяти | 11 ГБ |

| Пропускная способность памяти | 484 ГБ/с |

| Вычислительная производительность (FP32) | до 11 терафлопс |

| Теоретическая максимальная скорость закраски | 130 гигапикселей/с |

| Теоретическая скорость выборки текстур | 332 гигатекселя/с |

| Шина | PCI Express 3.0 |

| Разъемы | один разъем HDMI и три DisplayPort |

| Энергопотребление | до 250 Вт |

| Дополнительное питание | 8-контактный и 6-контактный разъемы |

| Число слотов, занимаемых в системном корпусе | 2 |

| Рекомендуемая цена | $699 (США), 52 990 (Россия) |

Модель видеокарты GeForce GTX 1080 Ti получила ожидаемое для топового решения новой серий GeForce наименование — она отличается от менее производительной модели приставкой Ti, говорящей о более высоком классе решения (аналогично GTX 1050 Ti и GTX 1050). Новинка не заменяет в текущей линейке компании какие-либо решения, а становится флагманом нынешней серии, несмотря на существующую параллельно модель Titan X на основе этого же GPU. Ниже новинки в линейке Nvidia располагается ранее анонсированная модель GeForce GTX 1080, основанная на менее мощном графическом процессоре GP104.

Рекомендованная цена на новую топовую видеоплату Nvidia составляет $699 в США и 52 990 в России (одинаковая цена для обычных версий и специального издания Founders Edition в этот раз). На фоне Titan X это очень хорошее предложение с учетом того, что GTX 1080 Ti значительно опережает GTX 1080, да и Titan X не уступает. И на день выхода новинка является лучшим по производительности решением на рынке игровых видеокарт без всяких сомнений, при этом она еще и имеет цену ниже установленной изначально для GeForce GTX 1080 — это очень хорошо! О конкуренции на рынке уже сказано выше — ее просто нет. Компания AMD рассчитывает на выпуск более-менее близких по мощности моделей лишь к лету, да и то еще неизвестно, дотянутся ли они до GP102 (GTX 1080 Ti) или будут конкурировать скорее с GP104 (GTX 1080).

Рассматриваемая нами видеокарта основана на слегка урезанном чипе GP102, имеющем 352-битную, а не 384-битную шину памяти, но применение еще больше ускоренной памяти GDDR5X, работающей на весьма высокой эффективной частоте в 11 ГГц, позволило достичь высокой пиковой пропускной способности в 484 ГБ/с — это практически на уровне с ожидаемым от конкурента решением, имеющим абсолютно новый тип памяти HBM2 с предполагаемой ПСП порядка 512 ГБ/с. Объем установленной на видеокарту памяти с такой шиной мог быть равен 5,5 или 11 ГБ, но ставить меньше 8 ГБ на столь мощное решения было бы странно, поэтому GTX 1080 Ti получила нетипичный объем памяти в 11 ГБ, и его хватит для запуска любых 3D-приложений с любыми настройками качества на несколько лет вперед.

Видеокарты модели GeForce GTX 1080 Ti, в том числе Founders Edition, выйдут на рынок уже начиная с 10-го марта, так что ждать долго не придется. Причем GeForce GTX 1080 Ti Founders Edition будет продаваться в том числе на русскоязычном сайте nvidia.ru, нужно лишь подождать. Также предполагается поступление в продажу видеокарт таких партнеров Nvidia, как компании Asus, Gigabyte, Innovision 3D, MSI, Palit и Zotac. Решения с собственным дизайном плат и систем охлаждения должны появиться в продаже уже в апреле.

Референсный дизайн Founders Edition

Мы уже привыкли, что Nvidia выпускает специальные издания своих видеокарт под названием Founders Edition, которые ранее имели более высокую цену по сравнению с видеокартами партнеров компании. Но не в этот раз — для GeForce GTX 1080 Ti рекомендованная цена едина для всех версий. Founders Edition, по сути, является референсной картой с разработанным в Nvidia дизайном карты и системы охлаждения, и производятся они самой компанией. Такие решения, произведенные с применением качественных компонентов, имеют своих поклонников. Тем более, что теперь за референсную карту не придется переплачивать, да и в продаже первыми появятся именно они, скорее всего.

Что касается самой конструкции платы GeForce GTX 1080 Ti, то многое мы уже знаем по той же видеокарте Titan X, от которой игровая новинка больше отличается ценой, чем конструкцией. Сейчас мы говорим именно о Founders Edition, которая спроектирована и выпускается самой компанией Nvidia с использованием лучших материалов и компонентов, по мнению специалистов компании. Корпус GeForce GTX 1080 Ti Founders Edition традиционно выполнен из алюминия и включает низкопрофильную пластину на задней части с удаляемой секцией — для лучшего охлаждения при установке пары видеокарт в SLI-конфигурации в соседние слоты.

Nvidia говорит о новом, более эффективном кулере с медной испарительной камерой, большим двухслотовым алюминиевым радиатором и тихим радиальным вентилятором, выбрасывающим горячий воздух за пределы корпуса через вентиляционные отверстия на задней панели. Для улучшения эффективности кулера, инженеры Nvidia разработали новую заднюю панель, обеспечивающую вдвое большую площадь выдувных отверстий, по сравнению с GeForce GTX 1080. Для этого был также удален традиционный разъем DVI, а его место заняли вентиляционные отверстия.

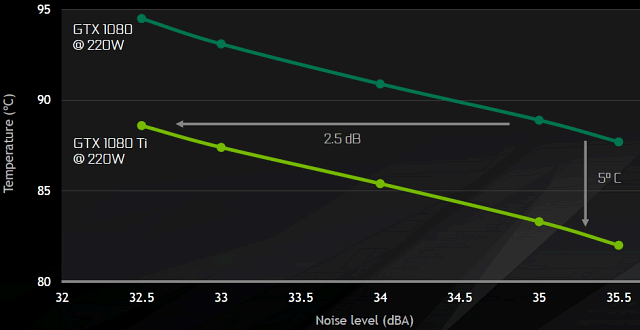

В итоге, референсная плата GeForce GTX 1080 Ti имеет следующий набор разъемов для присоединения устройств вывода изображения: один HDMI и три DisplayPort. По заявлению Nvidia, улучшенный по сравнению с GTX 1080 кулер позволяет получить или на 2,5 дБ меньший уровень шума при одинаковой температуре на GPU, или снизить температуру графического процессора на 5 градусов при сохранении одинакового уровня шума от кулера — неплохой результат.

По сравнению с GeForce GTX 1080 Founders Edition, была серьезно модифицирована и система питания новой модели. Уже предыдущие решения серии GeForce GTX 10 имели dualFET-транзисторы на GPU и памяти, что улучшило энергоэффективность и надежность, а также возможности разгона. Но в случае GeForce GTX 1080 Ti Founders Edition разработчики пошли дальше, установив 7-фазную систему питания с двойными dualFET-транзисторами, способную обеспечить ток в 250 А для GPU.

Применение двойных dualFET (14 штук в целом) позволило увеличить энергоэффективность при высоком потреблении энергии, особенно по сравнению с GTX 980. Это помогает достичь высоких рабочих частот при сохранении приемлемых потребления и тепловыделения, что особенно важно для таких больших и мощных графических процессоров, как GP102. Значение типичного энергопотребления для новинки составляет 250 Вт — это обычное значение для топовых моделей, требующее установки пары разъемов дополнительного питания: 8-контактного и 6-контактного. Длина референсной видеокарты GeForce GTX 1080 Ti равна привычным по мощным видеокартам 27 см.

Неудивительно, что благодаря удачной архитектуре Pascal, весьма энергоэффективной и производительной, а также удачному дизайну печатной платы и обновленному кулеру, GeForce GTX 1080 Ti отлично разгоняется. Так, издание Founders Edition вполне может работать при тактовой частоте GPU порядка 2 ГГц, и это без каких-то аппаратных изменений, с комплектным кулером. Можно предположить, что решения партнеров компании смогут предложить и еще более впечатляющие возможности.

Топовый представитель архитектуры Pascal

Итак, видеокарта GeForce GTX 1080 Ti основана на уже известном нам по модели Titan X графическом процессоре под кодовым именем GP102. Он содержит 12 миллиардов транзисторов, имеет площадь в 471 мм² и является самым сложным и мощным игровым видеочипом Nvidia, да и вообще. Как и все остальные видеокарты семейства Pascal, графический процессор GP102 отличается очень высокой частотой работы и потрясающей энергоэффективностью. Инженеры Nvidia тщательно оптимизировали этот GPU, чтобы устранить или минимизировать те немногие недостатки решений предыдущих поколений. В результате, у компании появился отличный флагман линейки, использующий продвинутый техпроцесс, как и остальные чипы Pascal. Применение FinFET-техпроцесса 16 нм при производстве графических процессоров GP102 позволило повысить сложность чипа при сохранении приемлемой площади и себестоимости.

Как и GPU предыдущего поколения, процессоры архитектуры Pascal имеют разную конфигурацию вычислительных кластеров Graphics Processing Cluster (GPC), потоковых мультипроцессоров Streaming Multiprocessor (SM) и контроллеров памяти, спаренных с блоками растеризации ROP. Мультипроцессор SM — это высокопараллельный мультипроцессор, который управляет исполнением и запускает варпы (группы из нескольких потоков команд) на CUDA-ядрах и других исполнительных блоках мультипроцессора. Подробнее об устройстве всех этих блоков и GPU целиком мы писали в обзорах предыдущих решений компании.

Каждый из мультипроцессоров SM спарен с движком PolyMorph Engine, который обрабатывает текстурные выборки, тесселяцию, трансформацию, установку вершинных атрибутов и коррекцию перспективы. В отличие от предыдущих решений компании, PolyMorph Engine в чипах архитектуры Pascal содержит и новый блок мультипроецирования Simultaneous Multi-Projection, о котором мы очень подробно писали в обзоре GeForce GTX 1080. Комбинация мультипроцессора SM с одним движком Polymorph Engine традиционно для Nvidia называется Texture Processor Cluster.

Графический процессор GP102 содержит шесть кластеров GPC и 28 мультипроцессоров SM, по 128 потоковых CUDA-ядер в каждом, то есть всего в чипе содержится 3584 CUDA-ядер. Каждый кластер GPC имеет выделенный движок растеризации и включает в себя четыре или пять мультипроцессоров SM. Мультипроцессоры состоят из 128 CUDA-ядер, 256 КБ регистрового файла, 96 КБ разделяемой памяти, 48 КБ кэш-памяти первого уровня и восьми текстурных блоков TMU каждый (всего 224 TMU на чип).

С точки зрения подсистемы памяти данная модификация GP102 урезана по возможностям — она содержит 11 активных 32-битных контроллеров памяти из 12 имеющихся физически, что и дает нам необычную 352-битную шину памяти в итоге. Соответственно, на видеокарту можно установить не 12 ГБ, как у Titan X, а лишь 11 ГБ памяти типа GDDR5X. Зато более производительной — новой спецификации, с эффективной частотой работы в 11 ГГц (ох и полюбили в Nvidia эту цифру!), и пропускная способность памяти в результате стала даже чуть выше, чем у Titan X. К каждому из контроллеров памяти привязано по восемь блоков ROP и 256 КБ кэш-памяти второго уровня. То есть всего чип GP102 содержит 88 активных (из 96 физических) блоков ROP и 2816 КБ (из 3072 КБ в чипе) кэш-памяти второго уровня.

Базовая частота графического процессора GeForce GTX 1080 Ti составляет 1480 МГц, а турбо-частота доходит до 1582 МГц (и даже выше — все же помнят, что это лишь средняя частота, на которой GPU Nvidia будут работать в играх, в реальности зачастую бывает и больше), что почти на 50% выше частоты GeForce GTX 980 Ti из предыдущего поколения. Естественно, что с увеличенным количеством исполнительных блоков, GeForce GTX 1080 Ti по всем показателям превосходит GTX 980 Ti. В частности, скорость текстурных выборок для новинки составляет до 354,4 гигатекселей в секунду на турбо-частоте, что более чем на 85% выше, чем у аналогичного решения предыдущего поколения.

Архитектура памяти Pascal

Несмотря на то, что ширина шины памяти у GP102 и так достаточно велика, для улучшения производительности в Nvidia решили поставить на GeForce GTX 1080 Ti самую быструю GDDR5X-память, какая только доступна. Такое решение далось не так уж легко, инженерам компании пришлось работать с партнерами, производящими микросхемы памяти, для дальнейшего совершенствования GDDR5X. Если старые микросхемы памяти, известные по GTX 1080, заставить работать на эффективной частоте 11 ГГц, то качество сигналов будет очень низким, поэтому потребовались технологические улучшения: оптимизация каналов, минимизация шумов и джиттера и т. д.

В результате у улучшенной GDDR5X-памяти получился намного более чистый и производительный интерфейс памяти, способный к работе на столь высокой частоте. И в сочетании с 352-битной шиной памяти у GeForce GTX 1080 Ti ее пиковая пропускная способность составила 484 ГБ/с, что даже чуть выше, чем было у Titan X с 384-битной шиной, за счет более скоростных микросхем памяти.

Кроме этого, во всех графических процессорах Nvidia, начиная с Maxwell, применяется тайловое кэширование (Tiled Caching). Это не совсем тот тайловый рендеринг, который известен нам по многим мобильным GPU, но в графических процессорах компании используется схожий подход для экономии пропускной способности памяти, когда рендеринг осуществляется небольшими участками экранного буфера (тайлами).

Среди преимуществ традиционной архитектуры отметим то, что она считывает геометрические данные лишь однократно, а в недостатках — низкая эффективность при высоком значении перекрытия (overdraw), когда множество треугольников покрывают один и тот же пиксель, что увеличивает нагрузку на память. Тайловый рендеринг разделяет экран на несколько участков, и рендеринг проводится в два прохода. Первый обрабатывает и сортирует геометрию, определяя, в какие тайлы входят треугольники, и записывает эту информацию в память. Во втором проходе происходит отрисовка тайлов по очереди с учетом данных из списка геометрии.

Основная выгода метода тайлового рендеринга состоит в том, что тайлы имеют небольшой размер и вся информация, необходимая при обработке, помещается в начиповый буфер, а во внешнюю память пишется только окончательное значение цвета, и это сильно снижает требования к пропускной способности видеопамяти. Однако у тайлового рендеринга есть и важные ограничения. Во-первых, необходимость предварительного прохода добавляет задержки и усложняет видеодрайвер. Во-вторых, процесс чтения и записи геометрических данных в видеопамять при большом объеме обрабатываемой геометрии начинает влиять на общую производительность даже больше самого чтения и записи пикселей.

Для тайлового рендеринга идеально, если геометрии в сцене мало, но пикселей много, и наоборот — если геометрии очень много, то никакого преимущества тайловый рендеринг не даст. Именно поэтому в мобильных играх тайловый рендеринг и процветает — пикселей там много (сами знаете, что разрешение экранов смартфонов не уступает разрешению мониторов), а вот геометрии относительно мало. А для современных ПК-игр, в которых бывает очень много обрабатываемой геометрии на кадр, этот подход далеко не идеален — весьма вероятно, что основным ограничителем производительности была бы запись/чтение геометрических данных, а не пиксельных.

В графических процессорах архитектур Pascal и Maxwell используется иной подход, хотя и использующий разбиение на тайлы, но это все та же традиционная модель, без предварительного геометрического прохода. Но вместе с этим используется и специальный блок binner, который записывает в кэш геометрические данные. По мере заполнения буфера сохраненными данными, GPU отрисовывает эту геометрию тайл за тайлом. Основное преимущество нового подхода в том, что геометрические данные и пиксели при рендеринге тайла целиком хранятся в начиповом L2-кэше и используется его когерентность, что позволяет снизить нагрузку на внешнюю память, экономя ПСП.

По сути, подход отличается от стандартного рендеринга кэшированием геометрических и пиксельных данных, попадающих в конкретный тайл. По сравнению же с тайловым рендерингом, тайловое кэширование предлагает схожий эффект по экономии ПСП, но без задержек, связанных с предварительным проходом сортировки геометрии и без негативного влияния при большом ее количестве.

Также все современные графические процессоры Nvidia поддерживают компрессию данных без потерь со степенью сжатия в 4:1 и 8:1, о которой мы не раз уже говорили в применении к графическим процессорам Nvidia семейств Maxwell и Pascal. Она также экономит и необходимый для рендеринга объем видеопамяти и, что еще более важно, ее пропускную способность. И если добавить к тайловому кэшированию еще и продвинутое сжатие информации о цвете в буфере, то все это позволяет значительно повысить эффективную пропускную способность видеопамяти до значений порядка 1,2 ТБ/с!

Конечно, сжатие данных и прибавка производительности от тайлового кэширования будут отличаться от игры к игре, но в целом добавка в эффективной ПСП составляет примерно два раза. И даже если не учитывать «виртуальный» рост ПСП, то реальная пропускная способность памяти GeForce GTX 1080 Ti не сильно отстает от производительности двухстековой HBM2-памяти, которую можно было бы ожидать от топовых решений в 2017 году (512 ГБ/с).

Кроме этого, в списке минусов нового типа быстрой HBM2-памяти есть и ограниченный объем. Если ставить два стека чипов памяти, то он будет ограничен 8 ГБ, а этот объем в Nvidia считают уже недостаточным по современным меркам. Для подкрепления своей позиции они приводят следующую статистику использования видеопамяти в некоторых играх разных лет:

Конечно, специалисты компании немного лукавят, приводя данные для 4К- и 5К-разрешений для двух самых современных видеокарт, но ведь и правда — если в 2016 году GeForce GTX 980 Ti хватало 6 ГБ локальной видеопамяти, то GTX 1080 вполне смогла получить преимущество от имеющегося объема в 8 ГБ, ну а если идти дальше, и измерить потребление VRAM в таких играх, как Watch Dogs 2 и Deus Ex: Mankind Divided в 5К-разрешении, то... лучше иметь более чем 10 ГБ памяти. И для запаса на будущее полезно. Забавно, что в Nvidia решили урезать возможности GPU до 11 ГБ, но нужно же оставить для Titan X хоть какое-то преимущество.

Инструменты для разработки DX12-приложений

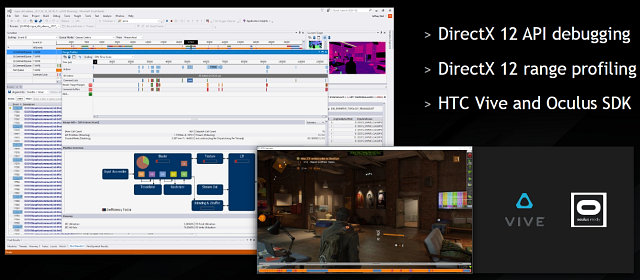

Как обычно, вместе с новой видеокартой компания Nvidia представила и несколько новых или улучшенных технологий, поддерживаемых архитектурой Pascal. На конференции GDC 2017 показали несколько программных новинок, из которых можно выделить инструменты для разработки, предназначенные для привлекающих все больше внимания новых графических API, таких как DirectX 12 и Vulkan. Они позволяют разработчикам игр получить больше гибкости, но оставляют производителям GPU меньше возможностей для оптимизации в драйверах, так как все большая часть задач 3D-конвейера делается игровыми приложениями

На оптимизацию драйверов для DirectX 11-игр, компания Nvidia потратила очень много ресурсов, сотни инженеров годами работают над решением этих проблем. Есть проработанные утилиты и инструменты, управление ресурсами осуществляется в драйвере, а не в приложении, и эти оптимизации работают без необходимости тонкой подстройки программистами, работающими над играми.

DirectX 12 же предлагает больший контроль над тем, что происходит в GPU, улучшенный менеджмент и синхронизацию, отдельные потоки исполнения для графики и вычислений (в том числе и асинхронное исполнение — async compute), позволяет управлять работой нескольких GPU с контролем передачи данных между ними для эффективной работы мультичиповых систем. Также новые API позволяют сделать специальные оптимизации для более эффективного использования многопоточных центральных процессоров и повысить производительность на слабых CPU.

Но все это одновременно означает и большую сложность правильной оптимизации DX12-кода — не раз и не два мы видели в играх, как использование нового графического API даже ухудшает скорость рендеринга, а не повышает ее. Так получается из-за того, что для применения DirectX 12 нужен иной подход и использование удобных инструментов для отладки кода, позволяющих эффективно использовать буферизацию данных, оптимизировать код под конкретную архитектуру GPU, правильно использовать возможности многоядерных CPU. В случае работы с низкоуровневыми API, порой бывает сложно определить, что именно вызывает ошибки и тормоза при рендеринге, и как лучше оптимизировать код.

Именно поэтому Nvidia обратила особое внимание на удобные утилиты для DirectX 12, включая PIX для Windows, Nvidia Aftermath и новую версию nSight Visual Studio Edition. Последний инструмент, обновленный до версии 5.3, позволяет отлавливать ошибки в DX12-приложениях, профилировать их и имеет поддержку HTC Vive и Oculus SDK, что важно при разработке приложений виртуальной реальности.

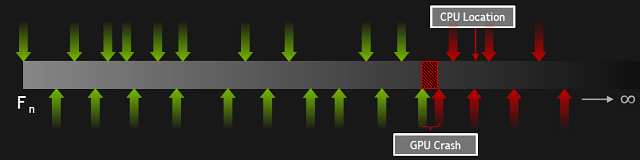

Мы уже рассматривали ранее и другой инструмент для оптимизации 3D-приложений — PIX for Windows. Nvidia сотрудничает с компанией Microsoft в его разработке для того, чтобы помочь игровым разработчикам в нелегком деле оптимизации DX12-игр, добавив плагин для счетчиков производительности GPU. Но если PIX и nSight уже были известны нам, они просто были улучшены, то Nvidia Aftermath — это совершенно новый инструмент для определения конкретных причин неверной работы GPU и остановок этой самой работы.

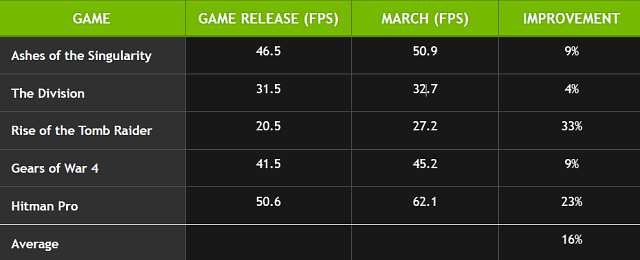

Утилита имеет возможность классифицировать крэши GPU по месту и типу и даже может быть встроена в релиз игры — чтобы игроки помогали отладке при бета-тестировании, к примеру. Nvidia сотрудничает с Microsoft и в вопросе стандартизации функциональности этой утилиты. Все эти утилиты вместе с улучшениями в драйверах помогают делать качественные DX12-движки и игры. Например, Nvidia приводит такие цифры среднего улучшения производительности в играх с момента их релиза:

А конкретно в игре Battlefield 1 при использовании DX12-рендерера, производительность увеличилась с альфа-версии до релиза проекта чуть ли не вдвое. И это речь идет в основном об улучшениях со стороны приложения — то есть разработчики со временем научились работать с новым API и оптимизировать код для него. То же самое касается и Vulkan. Если сначала, в середине 2016 года, при использовании OpenGL можно было получить большую производительность в играх, начиная с осени эти API сравнялись по скорости, а нынешней весной Vulkan будет иметь уже явное преимущество.

Очень важно, что Nvidia работает и с основными разработчиками популярных игровых движков, уже использующих DirectX 12: Unreal Engine, Unity и Amazon Lumberyard. В рамках своего выступления на GDC компании Amazon и Nvidia подготовили демонстрационную версию, в которой использовались некоторые технологии Nvidia, а также продвинутые методы сглаживания, использующие временную компоненту, а также специальный метод сглаживания для спекулярных отражений, улучшающий качество итоговой картинки.

Технологии GameWorks в помощь игровым разработчикам

Нельзя не вспомнить и об отличной инициативе компании — Nvidia GameWorks, помогающей внедрять в игры различные современные алгоритмы и эффекты, включающие визуальные и физические. Библиотека эффектов и техник позволяет упростить их добавление в игры, улучшить качество графики и повысить производительность, так как использует эффективные алгоритмы, отлично работающие на видеокартах Nvidia. Для решения этой задачи в компании работает более 300 инженеров, GameWorks уже используют тысячи разработчиков в более чем тысяче 3D-приложений, включающих такие известные проекты, как Fallout 4, The Witcher III, Gears of War 4, Grand Theft Auto V, For Honor, Resident Evil 7, Watch Dogs 2 и многие другие:

Список партнеров Nvidia по внедрению GameWorks действительно впечатляет, в него входят как игровые компании типа Ubisoft, Square Enix и Crytek, так и Autodesk с Amazon. На данный момент можно разделить все составляющие GameWorks на три части: рендеринг, физические симуляции и трассировка лучей. И все они постепенно появляются в открытом виде с исходниками. В 2015 году в публичном доступе исходных кодов GameWorks на GitHub появился PhysX 3.3 и примеры графических эффектов, в прошлом году добавились такие техники и алгоритмы, как HairWorks, FaceWorks и HBAO+, а в наступившем ожидаем публикации исходников ShadowLib, NvCloth, WaveWorks, Ansel, объемного освещения, симуляции травы, библиотек постобработки и многого другого.

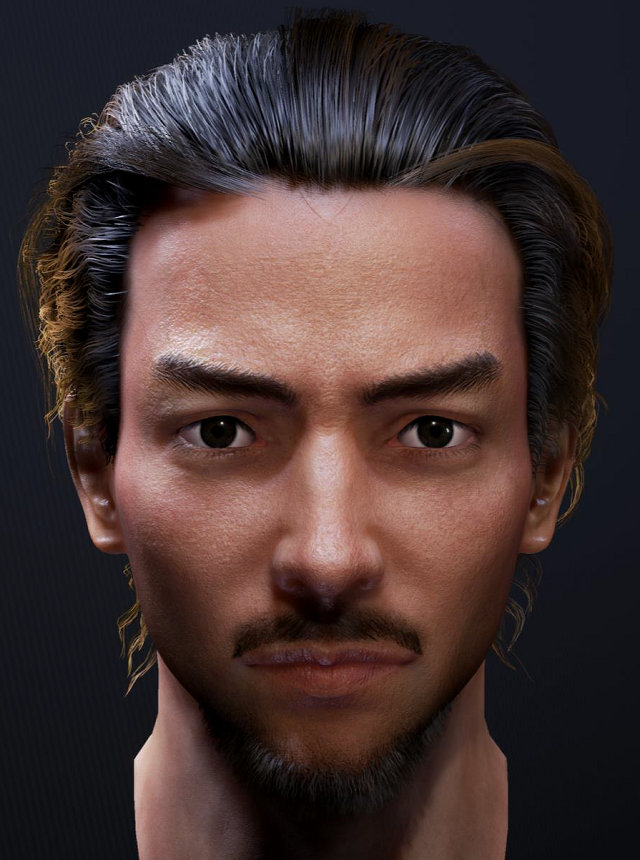

В частности, HairWorks, входящий в пакет GameWorks, отвечает за симуляцию и реалистичный рендеринг волос и шерсти, с реалистичной физикой и самозатенением. Заявлена поддержка как DirectX 11, так и DirectX 12, а также интеграция в игровые движки и средства разработки. Но главное — визуальный результат действительно весьма впечатляющий:

Кроме имитации волос, в числе последних открытых разработок Nvidia, вошедших в состав GameWorks, можно выделить Turf Effects — имитацию реалистичной травы не в виде полупрозрачных спрайтов, как это зачастую делалось ранее и делается до сих пор, а когда каждая травинка является детализированным геометрическим объектом, с управляемым уровнем детализации и с собственной физикой и самозатенением. Имитация травы интегрируется в игровые движки и уже доступна в версиях для DirectX 11 и 12. В частности, ее можно увидеть в свежей игре Ghost Recon: Wildlands.

Кроме чисто графических эффектов, GameWorks содержит и множество алгоритмов, имитирующих физическое взаимодействие различных тел, как твердых, так и жидких и газообразных: вода, дым, ткани и т. д. PhysX в новой версии 3.4 получит новые возможности: низкоуровневый API, физику твердых тел для расчета на GPU, абсолютно идентичную CPU-версии, в которой ранее эти расчеты и исполнялись. Эта версия будет внедрена в код популярного игрового движка Unreal Engine 4.14.

Из других интересных эффектов, связанных с физикой, отметим Blast — технику разрушения объектов нового поколения с кроссплатформенным низкоуровневым API, и NvCloth — имитацию тканей с модульным солвером в версиях C++ и DX, также включенные в состав Unreal Engine Mainline. Эти библиотеки приходят на замену Clothing и Destruction из состава движка Nvidia APEX, который, вероятно, уже отправили на покой.

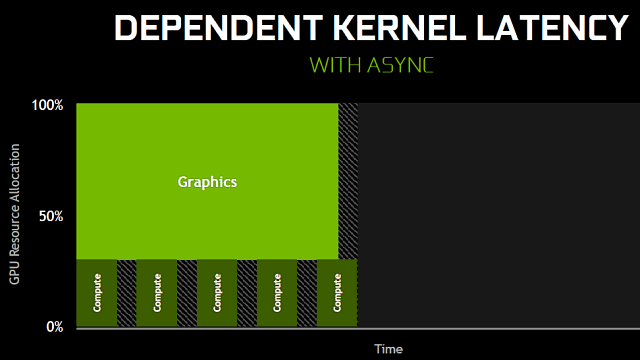

Кроме этого, были переведены на DirectX 12 такие зрелищные эффекты, как симуляция поведения жидкостей и газов. И если мы говорим о DirectX 12 и физических расчетах, то тут весьма важна качественная поддержка асинхронного исполнения шейдеров. В уже вышедших проектах она зачастую находится на зачаточном уровне, мы с вами убеждались на множестве примеров, что DX12-рендерер нередко дает лишь считанные проценты преимущества, по сравнению с хорошо оптимизированным DX11-кодом, которым отличается видеодрайвер Nvidia.

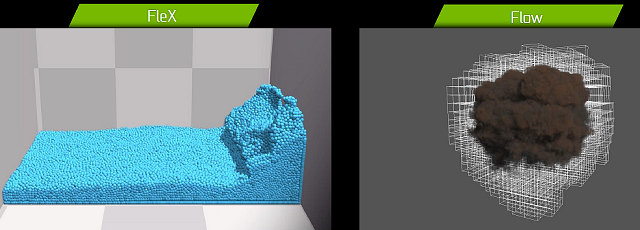

Но за async compute будущее, и компания не может это игнорировать. И так как графические и физические расчеты зачастую могут выполняться параллельно на разных исполнительных блоках, более эффективно загружая ресурсы GPU, было бы странно этим не воспользоваться, так как асинхронное исполнение шейдеров, доступное в DirectX 12, отлично подходит для симуляций жидкостей и газов. В рамках выставки GDC 2017 компания Nvidia анонсировала DX12-версии техник FleX и Flow, которые как раз и отвечают за подобные эффекты:

Эти технологии GameWorks применяются в играх для физических симуляций, которые ранее приходилось предрассчитывать заранее, а теперь это доступно в реальном времени при использовании GPU. FleX — техника симуляции на основе систем частиц для визуальных эффектов реального времени. До появления FleX разработчикам приходилось использовать несколько отдельных специализированных солверов: для физики твердых тел, жидкостей и тканей, FleX же использует унифицированный подход для всех объектов при помощи частиц, позволяя разным объектам взаимодействовать друг с другом, и чаще всего применяется для реалистичного воссоздания жидкостей, огня и дыма.

До сих пор, библиотеки FleX и Flow были оптимизированы для DirectX 11, а первым игровым движком с поддержкой этих технологий стал Unreal Engine 4. Теперь же Nvidia предлагает и DX12-вариант этих библиотек, позволяющий любым DX12-совместимым графическим процессорам исполнять подобные симуляции. Да-да, в том числе и решениям конкурентов, поддерживающим новый графический API и такие его особенности, как асинхронное исполнение шейдерных программ.

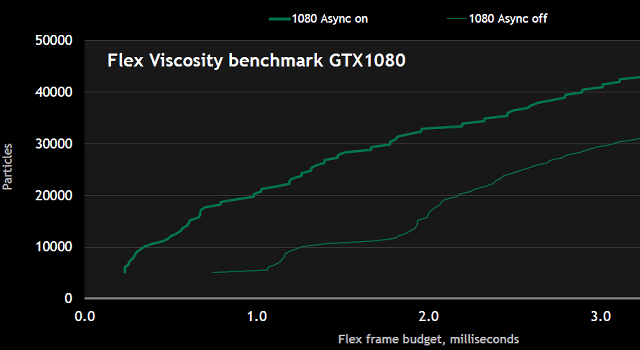

Применение асинхронных вычислений имеет весьма большое значение в этих задачах. В частности, тест производительности, основанный на коде FleX, запущенный на GeForce GTX 1080, показывает преимущество по затратам времени на вычисления вплоть до двукратного (в зависимости от количества рассчитываемых частиц), по сравнению с обычной версией, не использующей асинхронные вычисления.

Очень хорошо, что ранее проприетарные для Nvidia технологии GameWorks, такие как FleX и Flow, WaveWorks и HairWorks, а также Turf Effects, теперь выходят в DX12-версиях с поддержкой DirectCompute, что означает возможность их исполнения не только на графических решениях компании, но и на конкурирующих GPU. Будет очень интересно посмотреть, как все эти эффекты заработают на видеокартах AMD Radeon, а дальше, возможно придет и время PhysX, который пока что использует CUDA...

Искусственный интеллект в графике и создании контента

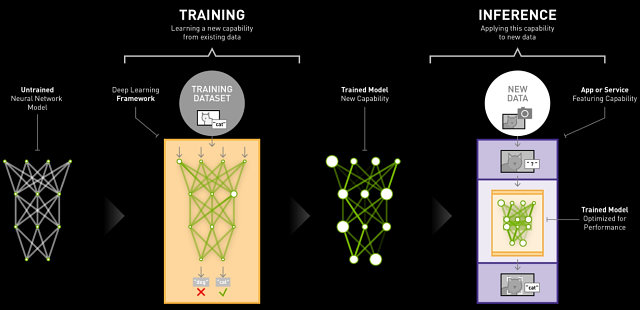

Тема нейросетей и глубокого обучения вот уже несколько лет на подъеме и, начиная примерно с 2012 года, в них начали применять графические процессоры. Новый подход к реализации искусственного интеллекта позволяет решить сразу несколько проблем традиционных моделей, связанных с большими затратами времени на написание сложных компьютерных программ, требующих длительной работы большого количества экспертов.

Самообучаемые же нейросети легко расширяются и отлично масштабируются, их достаточно хорошо «натренировать», и они будут отлично работать. Чем больший объем данных применяется в обучении — тем точнее работает нейросеть. Но это требует больших вычислительных мощностей, именно поэтому применение GPU в процессе позволило почти сразу достичь высоких результатов. К примеру, по распознаванию изображений и образов нейросети еще в 2015 году достигли уровня лишь 3,5% ошибок, превышающего человеческие возможности. В задаче распознавания речи результаты были столь же впечатляющими.

Применение графических процессоров семейства Pascal способно дать приличный прирост в скорости обучения и точности распознавания. В частности, в некоторых задачах можно применять не привычные расчеты с 32-битной точностью, а 16-битные или даже 8-битные, что позволяет кратно повысить производительность, хотя это доступно далеко не на всех GPU. В целом, Nvidia оценивает прирост скорости до 65 раз по сравнению с Kepler. Неудивительно, что GPU компании применяются большим количеством партнеров в сфере глубокого обучения:

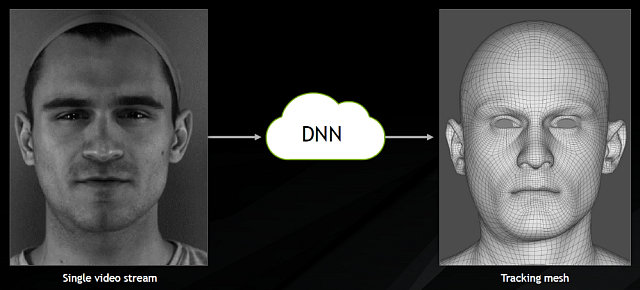

Уже сейчас обучаемые нейросети применяются в различных сферах, включая беспилотные автомобили и здравоохранение. Но нас больше интересует графика, и применение искусственного интеллекта может кое-что изменить и в этой сфере. Например, применение AI при создании контента позволяет ускорить время разработки, облегчив такие задачи, как анализ изображений и распознавание образов. Не говоря уже о более сложных применениях, вроде создания 3D-модели человеческого лица из одного 2D-видеопотока в реальном времени, в отличие от ранее применявшихся нескольких камер и длительной обработки.

Или можно взять качественное масштабирование изображения из меньшего разрешения в большее. Все же помнят голливудские фильмы про спецслужбы, которые из нескольких мутных пикселей получают различимое изображение лица человека? Конечно же, чаще всего это фантастика, но хорошо натренированная нейросеть действительно умеет распознавать сочетания пикселей, добавляя к фото недостающих деталей, довольно близких к реальности. Уже сейчас на сайте gwmt.nvidia.com доступен инструмент для повышения разрешения в два или четыре раза для текстур и фотографий, который неплохо работает:

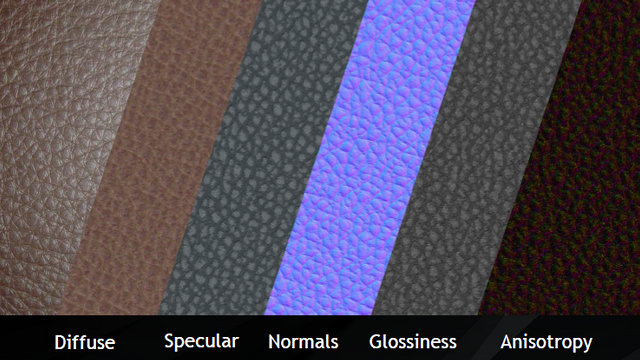

Там же есть и другие полезные инструментов для создания контента, пусть пока что лишь и в виде предварительных версий. Один из них позволит получить готовый материал из пары фотографий (со вспышкой и без нее), сгенерировав несколько текстур: базовую, карту нормалей, карту бликов и т. д., а второй — синтезировать несколько разновидностей текстур, используя за основу лишь одну из них.

Подобные инструменты способны значительно облегчить жизнь разработчикам 3D-приложений, которые тратят много времени на создание текстур и материалов. Они получат возможность создания качественных материалов в считанные минуты. Кроме этого, еще более продвинутым методом создания 3D-контента является фотограмметрия, синтезирующая готовую 3D-модель (геометрия и текстуры) из сотен изображений, снятых под разными углами и из разных точек, и применение графических процессоров способно серьезно ускорить и эту задачу.

Программные технологии Ansel и Shadowplay

Одной из самых востребованных особенностей программы GeForce Experience является технология Ansel, о которой мы уже не раз говорили в своих материалах. Она позволяет получать потрясающие скриншоты из игр, используя совершенно новые возможности: свободную камеру, наложение постфильтров, сверхвысокое разрешение и 360-градусный обзор для VR. Время показало, что энтузиастам это очень интересно, они уже создали сотни тысяч красивых скриншотов при помощи Ansel для каждой поддерживаемой этой технологией игры:

Ansel уже поддерживается в нескольких играх, включая такие проекты, как Dishonored 2, For Honor, Mass Effect: Andromeda и Watch Dogs 2. Для одной только The Witcher III было создано более 200 тысяч изображений. На GDC 2017 компания Nvidia объявила, что Ansel будет поддерживаться и в грядущем тактическом шутере Tom Clancy’s Ghost Recon: Wildlands, который отличается детализированным открытым миром, позволяющем получить красивые и разнообразные скриншоты.

Кроме этого, соответствующие плагины для внедрения Ansel стали доступны не только для игровых движков Unreal Engine и Unity, но и для свободного движка Amazon Lumberyard. Более того, компания Nvidia сразу анонсировала и публичный Ansel SDK, доступный для всех игр и движков, который уже можно скачать с сайта компании. То есть практически любой желающий разработчик может встроить эту технологию в свой проект.

Произошли некоторые изменения и в ShadowPlay — технологии, позволяющей снимать скриншоты и захватывать видеофрагменты из игровых приложений и сразу же публиковать их на Facebook, Youtube и других онлайн-сервисах. При помощи этого инструмента пользователи сняли более 200 миллионов видеороликов в прошлом году — вдвое больше, чем в предыдущем, что говорит об удобстве и популярности этой технологии.

Shadowplay продолжает улучшаться, и на GDC 2017 было анонсировано расширение ShadowPlay Highlights, которое автоматически записывает наиболее зрелищные достижения, вроде пятикратного убийства соперников подряд в многопользовательских шутерах, или удачного применения гранаты при устранении игрового босса. Причем для этого не нужно ничего специально делать, отвлекаясь от процесса, ролик запишется и добавится в Highlights автоматически.

Правда, Shadowplay Highlights требует поддержки со стороны приложения, так как именно оно решает, что записывать, а что нет. Для внедрения технологии в игры был создан специальный пакет SDK, которые легко интегрируется в код при помощи плагина или библиотеки. После его внедрения, игроки смогут просматривать и делиться наиболее эффектными моментами матчей. Неудивительно, что первой игрой с поддержкой этой новой возможности станет именно многопользовательский проект — игра LawBreakers, выход которой ожидается позднее в этом году.

Технологии виртуальной реальности VRWorks и FCAT VR

В обзоре топовой видеокарты нельзя не упомянуть и тему виртуальной реальности, продвижение в массы которой хоть и изрядно буксует, но все же потихоньку происходит. Компания Nvidia продолжает сотрудничество с разработчиками программного и аппаратного обеспечения в сфере VR для того, чтобы пользователи смогли насладиться виртуальной реальностью в полной мере. Основной проблемой VR, не связанной с физическими ограничениями (провода, большой шлем на голове, ...) является недостаток производительности, ведь VR требует более чем вдвое увеличенной мощности GPU, по сравнению с обычным рендерингом. И Nvidia старается снизить нагрузку на графические процессоры при помощи сразу нескольких технологий.

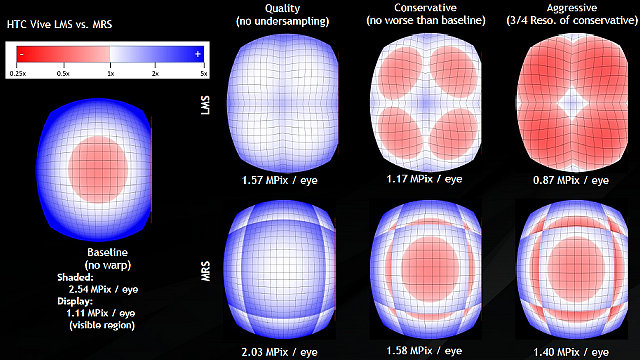

Инициатива компании VRWorks позволяет разработчикам использовать все новые возможности современных графических процессоров Nvidia. Так, им предлагается применять технологии Multi-Res Shading и Lens Matched Shading, предназначенные для повышения производительности рендеринга в виртуальном пространстве и улучшения его качества. Эти технологии снижают количество работы при рендеринге без видимого снижения качества. Если их не использовать, то в центре VR-изображения для каждого глаза GPU будет обрабатывать меньше пикселей, чем необходимо, а на периферии — наоборот, большое количество уже обработанных пикселей отбрасывается и не учитывается.

При отображении всего 1,11 мегапикселей на каждый глаз, GPU приходится обрабатывать 2,54 мегапикселей — это более чем вдвое превышает необходимый объем работы. При помощи технологий LMS и MRS можно нивелировать подобный перекос, обрабатывая больше пикселей в центре кадра и заметно меньше по его краям. Применение MRS позволяет снизить количество затеняемых пикселей с 2,54 до 2,03 мегапикселей, получив почти идеальное изображение. Или можно немного снизить качество, обрабатывая лишь 1,40-1,58 мегапикселей на каждый глаз. Еще более продвинутая технология LMS позволяет получить близкое к идеалу VR-изображение при обработке 1,57 мегапикселей или приемлемое при 1,17 мегапикселях — вдвое меньше, чем без оптимизаций! Это в теории, а вот что получается на практике:

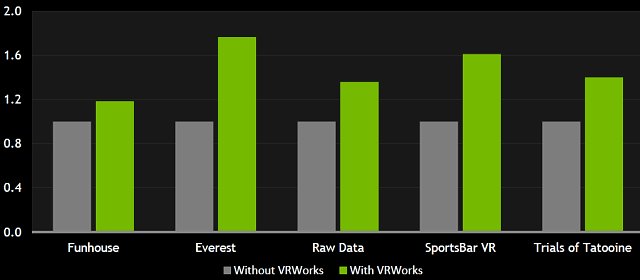

На данный момент, VRWorks интегрирована в движки Unreal Engine 4 и Unity, но не все игры используют эти популярные движки, ведь есть множество менее распространенных альтернатив. Для того, чтобы внедрить VRWorks в максимальное количество проектов, компания Nvidia анонсировала на GDC 2017 поддержку DirectX 12 для VRWorks, включая технологии LMS и MRS — любая из компаний, использующих DX12 при разработке, теперь может воспользоваться новыми VR-технологиями Nvidia. Также виртуальная реальность с поддержкой современных технологий этой компании будет доступна в движке Unity 2017.1 Beta, выходящей весной. Поддержка VRWorks позволяет повысить производительность приложений виртуальной реальности на значение от 20% до 70% (в среднем — около 35%-40%), в зависимости от применяемых технологий.

Продолжая разговор о производительности, напомним, что VR требует стабильных 90 FPS при расчете 450 мегапикселей в секунду с задержками вывода не более 20 мс. И хотя определить недостаток производительности GPU в VR по собственным ощущениям очень легко, измерить комфортность игрового процесса в виртуальном пространстве уже совсем не так просто, ведь измерение количества кадров в секунду с использованием привычных средств вроде Fraps для этого не подходит по многим причинам.

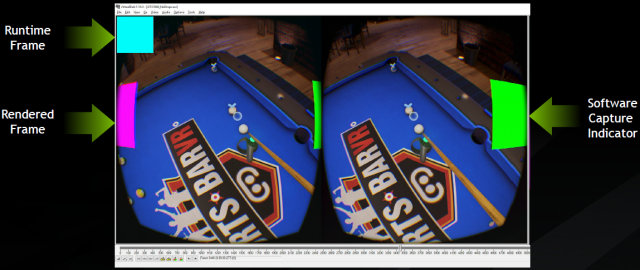

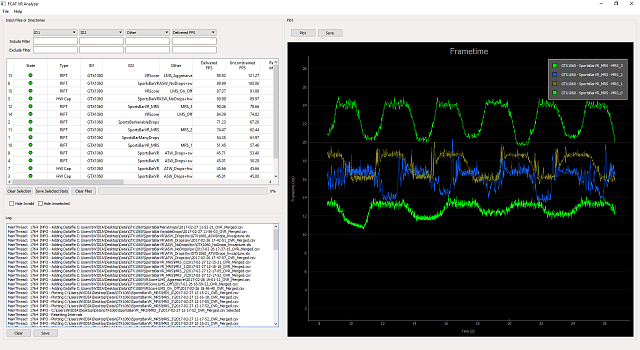

Например, продвинутое программное обеспечение виртуальной реальности может выводить пропущенные при рендеринге кадры два раза подряд или экстраполировать промежуточные кадры, что явно нельзя назвать комфортным игровым процессом и что уж точно не подходит для измерения производительности, ведь технически будут выводиться 90 кадров в секунду, но практически то далеко не все они уникальны и отрендерены на GPU. Для того, чтобы исправить это досадное недоразумение, Nvidia решила выпустить новый пакет для анализа производительности в приложениях виртуальной реальности — FCAT VR, предназначенный для помощи разработчикам, игровым энтузиастам и специализированной прессе.

Как и известная утилита FCAT, предназначенная для традиционных средств вывода, FCAT VR измеряет производительность с максимально возможной точностью, вычисляя отброшенные кадры, которые приводят к рывкам и неприятным последствиям для организма игроков, а также искусственно сгенерированные промежуточные кадры, возникающие при нехватке производительности (если таких синтезированных кадров слишком много, это означает, что GPU банально не справляется с задачей рендеринга с необходимой скоростью).

Снимать реальные данные с видеовыхода не так то просто, приходится использовать HDMI-сплиттер и карту видеозахвата. Не говоря уже о сложном процессе анализа снятых данных. Для решения этого компания Nvidia анонсировала новую утилиту FCAT VR, и вставляет в кадр специальные цветовые индикаторы, позволяющие понять, какие кадры были отрисованы в каждый момент времени, и затем анализирует выходной видеопоток аналогично FCAT, только уже специализированно для виртуальной реальности.

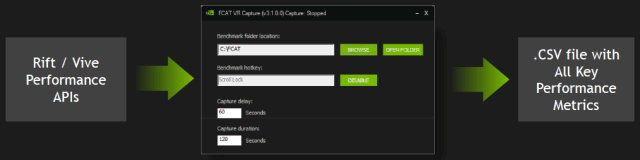

Но теперь есть и более простой вариант — в FCAT VR есть возможность исключительно программного метода анализа производительности, аналогично Fraps, но специализированного именно для виртуальной реальности, и имеющего большую точность. FCAT VR использует специальные API производителей VR-шлемов (HTC Vive и Oculus Rift) и выводит в CSV-файлы все необходимые данные о производительности приложений виртуальной реальности, что гораздо удобнее использования громоздкой схемы с видеозахватом.

Но так как сами по себе CSV-файлы не очень удобны, для анализа массива данных требуются специальные инструменты. Nvidia выпустила утилиту для анализа и визуализации результатов FCAT Data Analyzer, которая входит в комплект FCAT VR и позволяет сравнивать различные решения в удобном виде при отличающихся условиях рендеринга в приложениях виртуальной реальности.

В общем, для популяризации VR компания Nvidia делает все, от нее зависящее. Можно вспомнить и весьма удачную демонстрационную программу VR Funhouse с открытым кодом, к которой уже было выпущено немалое количество модификаций. Так что дело тут, скорее, за контентом сторонних разработчиков — уж очень мало сейчас приложений, заставляющих с интересом проводить продолжительное время за VR-шлемами. Чаще всего это остается развлечением на полчаса-час, что вполне подходит для аттракциона в торговом центре, но пока что явно недостаточно для того, чтобы завоевать место в доме большого количества обычных игроков. Будем надеяться, что усилия индустрии по продвижению VR к чему-то приведут.

Выводы по теоретической части

Новая топовая видеокарта GeForce GTX 1080 Ti предназначена для ультра-энтузиастов — тех, кто хочет наслаждаться любыми современными играми на максимальных настройках, при самых высоких разрешениях с сохранением высокой производительности. По данным самой компании, по сравнению с младшей для новинки моделью GeForce GTX 1080, вышедшее сегодня решение обгоняет эту модель в среднем на 35%, что делает ее самым эффективным топовым решением с приставкой Ti за последнее время, так как разница между GTX 980 и GTX 980 Ti была меньше — 25%, не говоря уже лишь о 18% между GTX 780 и GTX 780 Ti.

35% получили в самой Nvidia, протестировав GeForce GTX 1080 и GTX 1080 Ti в девяти приложениях (восьми играх и бенчмарке Unigine) при различных настройках и разрешениях от 2560×1440 до 4К. Интересно, что наименьшая разница была отмечена в игре Hitman — даже при условии установки 4К-разрешения, производительность и современных игр зачастую упирается в CPU, что не позволяет раскрыться столь мощному графическому процессору.

Это относится к GTX 1080 Ti в целом — если у вас нет 4К- или хотя бы WQHD-монитора, то приобретение этой видеокарты может быть не слишком удачным решением. А вот для тех, у кого такие устройства вывода есть, вместе с запрашиваемой суммой денег и желанием потратить ее на игры, GeForce GTX 1080 Ti является просто лучшей видеокартой на рынке. Судя по ее техническим характеристикам, она в игровых тестах если не обгонит Titan X, то ни в чем ему не уступит, а ведь еще вчера это был совсем другой ценовой уровень...

Новый технологический процесс 16 нм FinFET и оптимизации архитектуры позволили видеокарте GeForce GTX 1080 Ti, основанной на графическом процессоре GP102, достичь высокой тактовой частоты. И вместе с большим количеством исполнительных блоков, это делает новинку самой высокопроизводительной игровой видеокартой вообще. Можно также отметить, что модель GeForce GTX 1080 Ti также стала видеокартой, несущей наиболее высокопроизводительную графическую память нового типа GDDR5X, работающую на эффективной частоте в 11 ГГц. В сочетании с улучшенными алгоритмами сжатия информации во фреймбуфере и тайловым кэшированием, это привело к росту эффективной пропускной способности памяти для этого графического процессора до уровня более 1 ТБ/с.

Компания Nvidia наконец-то выпустила видеокарту на топовом графическом процессоре GP102, предназначенную для обычных игроков, а не только богатых энтузиастов, на которых нацелена Titan X. Рекомендованная розничная цена на GeForce GTX 1080 Ti в России составляет 52990 руб, что даже ниже цены предыдущего флагмана GeForce GTX 1080, поступившего в продажу на момент анонса за 54990 руб. Выпущенная сегодня видеокарта Nvidia GeForce чуть дешевле и при этом на 35% быстрее — отличный вариант для энтузиастов при том, что конкуренции в этой части рынка просто нет! Остается добавить, что вместе с GeForce GTX 1080 Ti на рынок выйдут и улучшенные версии GTX 1080 и GTX 1060, использующие более скоростную видеопамять: GeForce GTX 1080 11 Gbps и GeForce GTX 1060 9 Gbps — компания Nvidia настроилась на продолжение борьбы весьма серьезно.

Как обычно, не забываем отмечать солидную программную поддержку. Nvidia продолжает совершенствовать как инструменты для игровых разработчиков (nSight и Aftermath, GameWorks и VRWorks, Flex и Flow, а также многие другие), так и свои технологии, предназначенные для обычных игроков (GeForce Experience, ShadowPlay, Ansel и др.) Отдельно можно отметить то, что компания Nvidia старается перенести на DirectX 12 большинство своих инструментов и технологий, открывая многие из них широкой публике и делая возможным их использование в том числе и на решениях конкурента — это пойдет на пользу всей индустрии.

Не забываем и о технологиях, позволяющих ускорить рендеринг в среде виртуальной реальности, экономящих ресурсы графических процессоров в 1,5-2 раза. Среди программных технологий, предназначенных для простых игроков, традиционно выделяем платформу для создания скриншотов в играх Ansel, которая становится все более привлекательной — искусство создания скриншотов на новом уровне становится доступно для все более широкого круга игровых проектов. Кажется любопытной и система автоматической записи игровых достижений ShadowPlay Highlights и многое другое. Хотя все это работает не только на GeForce GTX 1080 Ti, но именно недешевые решения и позволяют Nvidia тратить на совершенствование многочисленных технологий много ресурсов.

В следующих частях материала мы оценим производительность новой видеокарты Nvidia GeForce GTX 1080 Ti на практике, сравнив ее скорость с показателями других моделей компаний Nvidia и AMD. В частности, сравним мы скорость новинки и с младшей моделью GeForce GTX 1080, чтобы получить разницу в производительности между GPU разного позиционирования. Но перед тем, как перейти к игровым тестам, сначала рассмотрим данные, полученные нами в синтетических тестах.

| Средняя цена (количество предложений) в московской рознице: | |

|---|---|

| Рассматриваемые карты | Конкуренты |

| GTX 1080 Ti 11 ГБ — 48000 руб. (на 10.05.17) | GTX 1080 8 ГБ — 36500 руб. (на 10.05.17) |

| GTX 1080 Ti 11 ГБ — 48000 руб. (на 10.05.17) | R9 Fury X 4 ГБ — 32000 руб. (на 10.05.17) |

| GTX 1080 Ti 11 ГБ — 48000 руб. (на 10.05.17) | GTX Titan X (Pascal) — 90000 руб. (на 10.05.17) |

| GTX 1080 Ti 11 ГБ — 48000 руб. (на 10.05.17) | GTX 980 Ti 6 ГБ — 35000 руб. (на 10.05.17) |

и лично Ирину Шеховцову

за предоставленную на тестирование видеокарту

| Блок питания Thermaltake DPS G 1050W для тестового стенда предоставлены компанией Thermaltake | Корпус Corsair Obsidian 800D Full Tower для тестового стенда предоставлен компанией Corsair | Модули памяти G.Skill Ripjaws4 F4-2800C16Q-16GRK для тестового стенда предоставлены компанией G.Skill | Corsair Hydro SeriesT H100i CPU Cooler для тестового стенда предоставлен компанией Corsair |

| Монитор Dell UltraSharp U3011 для тестовых стендов предоставлен компанией Юлмарт | Системная плата ASRock Fatal1ty X99X Killer для тестового стенда предоставлена компанией ASRock | Жесткий диск Seagate Barracuda 7200.14 3 ТБ для тестового стенда предоставлен компанией Seagate | 2 накопителя SSD Corsair Neutron SeriesT 120 ГБ для тестового стенда предоставлены компанией Corsair |

:no_upscale()/https://cdn.ixbt.site/ixbt-data/jp8xQvedXd/covers/IsI4GojhLyJbCJajXlgRnYy7GztO2iXhIvVlRRMc.jpg)

:no_upscale()/https://cdn.ixbt.site/ixbt-data/U80AxQ2TZv/covers/Qw35uV0mpLx0euXvtoR19bPN90CTVZJeCnlxVmax.jpg)

:no_upscale()/https://cdn.ixbt.site/ixbt-data/Tiky4gksYV/covers/7RINz0bJ5dhMAw8HGjBSZtIid2K44nRSBJIWm3Xx.jpg)

0 комментариев

Добавить комментарий

Добавить комментарий

Пожаловаться на комментарий