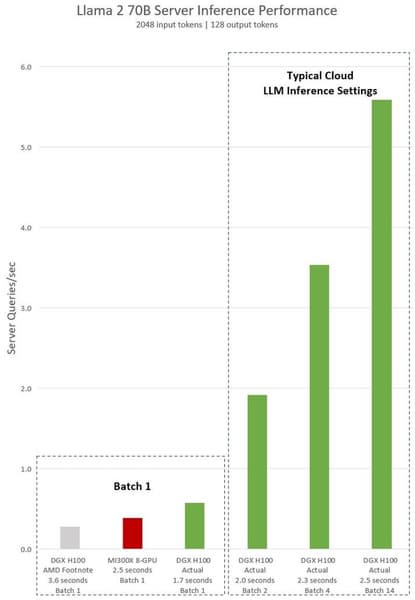

Компания AMD неделю назад объявила о запуске своих ускорителей Instinct MI300X и MI300A, заодно раскрыв подробности. В частности, компания заявила, что Instinct MI300X на 20% быстрее Nvidia H100, а в серверах из восьми ускорителей разница достигает уже 60%. Nvidia опубликовала пресс-релиз, где утверждает, что AMD просто неправильно сравнивает, а на самом деле H100 лучше.

Nvidia говорит, что в своей презентации AMD использовала данные, где для Instinct MI300X использовались её оптимизированные библиотеки в пакете ROCm 6.0, а для H100 ничего подобного не применялось. При этом у Nvidia есть схожее решение в виде TensorRT-LLM. И если использовать TensorRT-LLM, то H100 оказывается намного быстрее как в одиночном сравнении, так и при сравнении серверов.

В целом в данном случае оправдание Nvidia выглядит вполне убедительно. Правда, у компании есть намного более серьёзная проблема, чем наличие конкурента. Это недостаточные производственные мощности TSMC и, как следствие, невозможность удовлетворить спрос. Ещё несколько месяцев назад сообщалось, что сроки ожидания H100 растягиваются до года, а сейчас ситуация может быть ещё хуже.