Год назад компания Intel представила платформу Nervana для приложений искусственного интеллекта. Тогда сообщалось, что основой для платформы послужат и CPU Xeon, и ускорители Xeon Phi, и ускорители на базе FPGA.

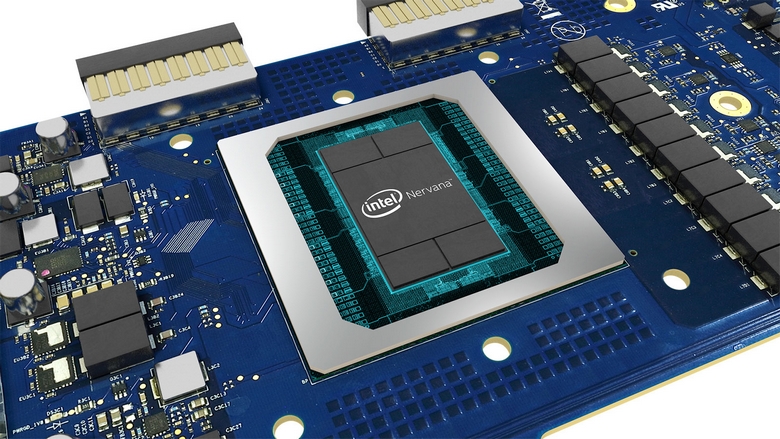

Позже мы узнали подробности об ускорителях Lake Crest, которые будут являться первым воплощением новой тензорной архитектуры Flexpoint. А вчера процессорный гигант рассказал о том, что до конца текущего года выпустит «первую в отрасли микросхему для обработки нейронных сетей». Она будет называться Intel Nervana Neural Network Processor (NNP), то есть, как ясно из названия, тоже будет относиться к платформе Nervana.

По словам Intel, NPP произведёт революцию в вычислениях, связанных с искусственным интеллектом. Используя платформу Intel Nervana, производители смогут разрабатывать совершенно новые классы приложений ИИ, которые максимизируют объёмы обрабатываемых данных.

Проще говоря, ASIC Intel Nervana Neural Network Processor, а это именно интегральные схемы, станут первыми специализированными решениями, нацеленными исключительно на работу с нейронными сетями. По крайней мере, так утверждает Intel. При этом мы держим в уме существование уже второго поколения Tensor Processing Unit компании Google. К сожалению, особых подробностей о NNP в пресс-релизе нет, но мы знаем, что данные решения — это и есть те самые ускорители Lake Crest, о которых мы уже писали.

Отдельно Intel отметила, что уже к концу года выпустит 49-кубитовую микросхему для квантовых вычислений.