Как часто ChatGPT ошибается? Разбор неточностей и паттернов

Генеративный искусственный интеллект, включая ChatGPT, стремительно набирает популярность как альтернатива традиционным поисковым системам. Но современные исследования показывают: эти инструменты часто демонстрируют паттерны ошибок, особенно в вопросах цитирования источников. В этой статье разберемся, насколько ChatGPT точен, какие ошибки совершает чаще всего и почему это важно для пользователей, редакторов и блогеров.

Содержание

Уверенность или точность? Главная проблема ChatGPT

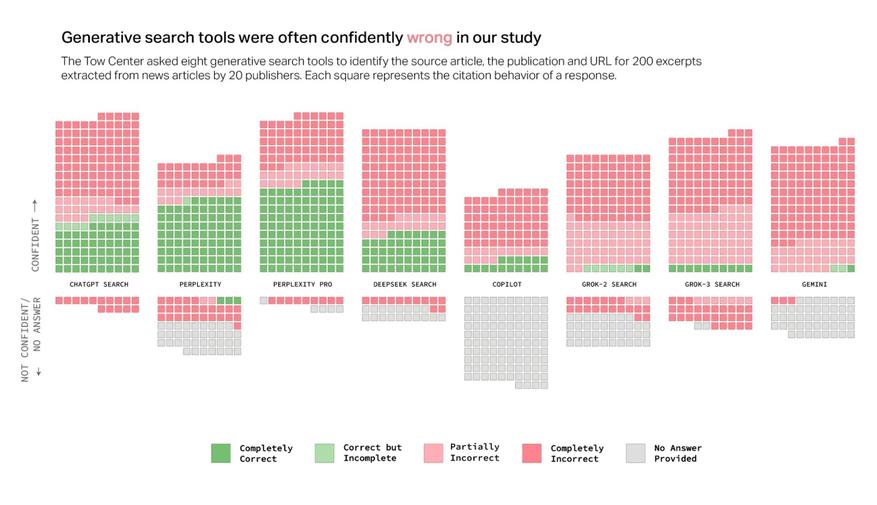

Согласно исследованию Tow Center для Columbia Journalism Review (2025), ChatGPT, как и другие ИИ-поисковики, склонен давать уверенные, но ошибочные ответы. Например, в 67% случаев (134 из 200 запросов) ChatGPT неправильно идентифицировал статьи, но лишь в 15 случаях признал неуверенность. Также в отличие от Copilot, который чаще отказывался отвечать, ChatGPT почти никогда не предупреждал пользователей о возможных неточностях.

Это создает «иллюзию надежности»: ИИ преподносит информацию авторитетно, даже если она недостоверна. Пользователи, особенно неискушенные, могут не заметить подвоха.

5 ключевых паттерна ошибок

Игнорирование настроек сайтов. ChatGPT иногда обходит протокол (Robot Exclusion), который позволяет сайтам блокировать доступ для краулеров (поисковых роботов). Например, он цитировал статьи USA Today через Yahoo News, хотя сам издатель запретил доступ к своему контенту.

- Ссылки на неправильные источники

В исследовании ИИ-поисковики часто путали оригинальные статьи с их синдицированными или пиратскими копиями. Так, Perplexity (и его премиум-версия) вместо Texas Tribune ссылались на неофициальные републикации, лишая издатель трафика.

- Некоторые чат-боты, включая Grok 3 и Gemini, генерировали несуществующие ссылки.

Некоторые чат-боты, включая Grok 3 и Gemini, генерировали несуществующие ссылки. Например, в 154 из 200 случаев Grok 3 направлял на страницы с ошибкой 404. ChatGPT в этом аспекте оказался чуть лучше, но проблема актуальна для всех систем.

- Премиум-версии ошибаются чаще

Платные модели (Perplexity Pro, Grok 3) давали больше правильных ответов, но чаще выдавали уверенные ошибки. Виной — стремление «не подвести» пользователя: вместо признания незнания ИИ предлагал домыслы.

OpenAI и Perplexity заключают сделки с издателями (The Guardian, Time, Texas Tribune), чтобы получить прямой доступ к контенту. Но исследование показало, что ChatGPT правильно определил лишь 1 из 10 статей San Francisco Chronicle, несмотря на партнерство, а Time, сотрудничающий и с OpenAI, и с Perplexity, всё равно сталкивался с ошибками атрибуции.

Даже при наличии договоренностей ИИ не гарантирует корректное цитирование. Как отметил Марк Ховард из Time: «Компании не обещали 100% точность».

Последствия для пользователей и СМИ

Для редакторов ошибки ИИ подрывают доверие к брендам. Например, если ChatGPT цитирует BBC с ошибкой, страдает репутация и СМИ, и самого ИИ.

Для аудитории последствием является то, что пользователи получают искаженную информацию, которую сложно проверить из-за фейковых ссылок.

Для монетизации тоже существует негативное влияние: издатели теряют трафик, когда ИИ направляет пользователей на сторонние платформы вместо оригинальных статей.

Будущее ИИ-поиска

Представители OpenAI заявили, что работают над улучшением цитирования и уважают настройки протоколов. Microsoft подчеркнула, что соблюдает протоколы блокировки поисковых роботов. Тем не менее, текущие данные показывают: прогресс медленный.

Пока пользователям стоит проверять информацию из ChatGPT через традиционный поиск. ChatGPT ошибается часто — в 67% случаев по данным исследования. Его ключевые слабости: чрезмерная уверенность, игнорирование правил издателей и некорректные ссылки. Пока ИИ-поисковики остаются не слишком надежными помощниками в работе с новостным контентом. Доверяй, но проверяй — главный совет для тех, кто использует эти инструменты.

Источник: fusionbrain.ai

2 комментария

Добавить комментарий

Это прям цитата из этой статьи. Улыбнуло. И здесь ИИ накосячил: в статье о косяках ИИ :)

Добавить комментарий