Почему видеокарты настолько подорожали: пора обновляться сейчас, завтра будет ещё дороже

Помните те времена, когда можно было купить приличную видеокарту за разумные деньги? Я вот помню, и, честно говоря, ностальгия берёт за душу. Сегодня же, открывая ценники на новенькие GPU, хочется то ли смеяться, то ли плакать. Сегодня же, открывая любой онлайн-магазин электроники, хочется протереть глаза и перепроверить курс валют — неужели цифры не врут? Увы, всё так. Стоимость современных GPU взлетела до небес, оставив позади даже самые смелые прогнозы аналитиков пятилетней давности.

Особенно остро ощущается этот рост, если посмотреть на ситуацию через призму «рублей на медианный FPS» для актуальных игр. Ещё вчера мы радовались, что можем позволить себе топовую графику в любимых тайтлах, а сегодня приходится выбирать между почкой и плавным геймплеем. И ладно бы речь шла только о флагманских моделях — даже середнячки теперь стоят как самолёт.

Но самое печальное — это то, что куда сильнее выросла планка для видеокарт «с запасом на будущее». Если раньше можно было купить, скажем, GTX 1066 и спокойно играть несколько лет, не задумываясь о том, что она может не потянуть новинки, то сегодня для такого спокойствия нужна как минимум RTX 4070. И это при том, что цена на неё кусается куда ощутимее, чем на GTX 1070 из не столь далёкого прошлого (цены выросли уж явно поболее официальной инфляции, причем кратно).

Младшие модели едва справляются с текущими играми, а что будет через год — страшно представить. Unreal Engine 5 и вовсе без зазрения совести «кладёт на лопатки» всё, что слабее RTX 4080.

Так что же произошло с рынком видеокарт? Давайте разбираться.

Закон Мура мёртв и разлагается

Знаете, что общего между законами физики и законом Мура? И те, и другие рано или поздно упираются в свой потолок. Вот и закон Мура, гласивший, что количество транзисторов на кристалле будет удваиваться каждые два года, в конце концов встретился с суровой реальностью. Примерно десять лет назад, аккурат к выходу серии GTX 10XX, мы добрались до этого самого потолка. И с тех пор закон Мура не просто мёртв — он активно разлагается, оставляя после себя шлейф растущих цен и разочарованных геймеров.

Конечно, вы можете возразить:

Постойте-ка, но ведь новые видеокарты всё ещё мощнее старых! Разве кривая прогресса куда-то делась?

…И будете отчасти правы. Да, производительность растёт, но давайте вспомним оригинальную формулировку закона Мура: «число транзисторов на кристалле равной стоимости будет удваиваться раз в два года». Ключевое здесь — «равной стоимости». А вот с этим как раз и возникли проблемы.

Чтобы закон продолжал работать, нужно было бы постоянно уменьшать размер транзисторов на кристалле одного размера или снижать процент брака при производстве, позволяя делать чипы большего размера за те же деньги. Желательно, оба варианта сразу. Но технологии упёрлись в физические ограничения — дальнейшее уменьшение размеров транзисторов становится всё сложнее и дороже, а процент выхода годных чипов если и растёт, то черепашьими темпами. В результате мы получаем ситуацию, когда за каждый новый процент производительности приходится платить всё больше и больше.

Два пути к производительности

Так как же производители умудряются выжимать тот самый рост производительности, которым они так гордятся на презентациях? Ответ прост: двумя не самыми приятными для нашего кошелька путями.

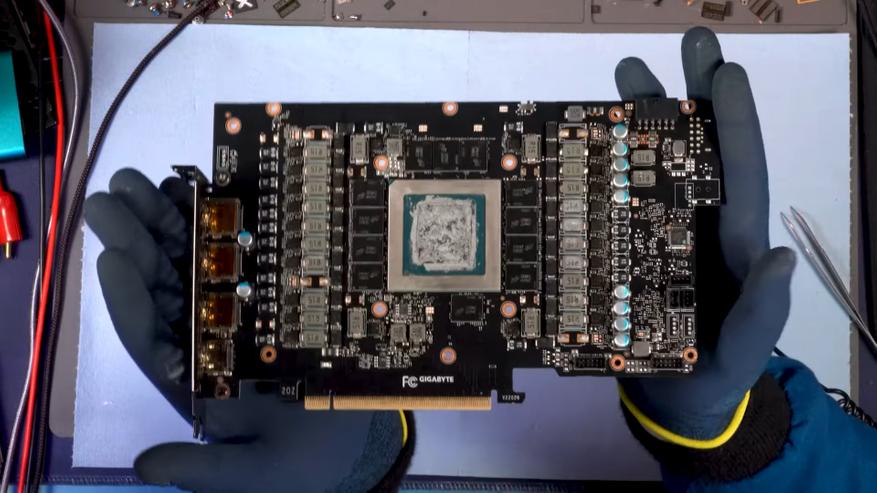

- Первый путь — это увеличение площади чипа. Казалось бы, что тут такого? Сделали кристалл побольше, набили его транзисторами под завязку — и вуаля, производительность выросла! Но не всё так просто. Чем больше площадь чипа, тем выше вероятность брака при производстве. А ещё это означает, что с одной кремниевой пластины можно будет нарезать меньше чипов. В итоге стоимость каждого отдельного GPU взлетает до небес, а мы с вами остаёмся с пустыми кошельками и разбитыми мечтами о доступном апгрейде.

- Второй путь не менее «весёлый» — это повышение частот и теплового пакета. Новые техпроцессы позволяют чипам работать стабильнее, что даёт возможность либо увеличить энергоэффективность для мобильных устройств, либо поднять планку производительности за счёт TDP для настольных систем. Звучит неплохо, правда? Но есть нюанс: такой подход требует более мощных систем охлаждения (вплоть до крайне дорогостоящей испарительной камеры на топовых исполнениях 4080 и почти всех 4090), усиленных подсистем питания, новых коннекторов и прочих «радостей жизни». И всё это, разумеется, совершенно бесплатно! Ой, простите, очепятка — совершенно не бесплатно. Видеокарты на 300+ Вт становятся нормой, а вместе с ними растут и ценники.

А теперь вспоминаем, что проектантам приходится использовать оба подхода — и понимаем всю безблагодатность ситуации.

Бум майнинга, перешедший в бум ИИ

Если вы думали, что ситуация не может стать ещё хуже, то у меня для вас плохие новости. Помните старину Адама Смита с его теорией спроса и предложения? Так вот, последние 5-7 лет рынок GPU переживает настоящее светопреставление в этом плане. И виноват в этом не только и не столько потребительский спрос, сколько настоящий энтерпрайзный бум.

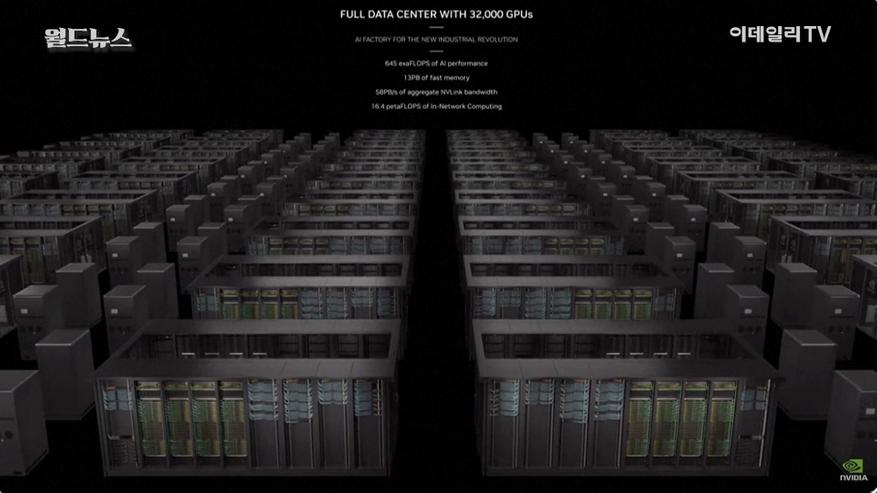

Всё началось с криптовалютного безумия. Майнеры скупали видеокарты оптом, не глядя на цены. Производители не успевали удовлетворять спрос, цены росли, а простые геймеры оказались у разбитого корыта. Казалось бы, после краха крипторынка ситуация должна была нормализоваться. Но не тут-то было! На смену майнингу пришла «нейросетевая революция», и теперь уже компании, занимающиеся искусственным интеллектом, готовы отдать любые деньги за вычислительные мощности.

Дефицит по-Смиту

В результате мы имеем классическую ситуацию дефицита по Смиту: спрос значительно превышает предложение, а производственные мощности не успевают за растущими аппетитами рынка. Чипов катастрофически не хватает, и ситуация напоминает попытку заставить стиральную машинку потреблять больше воды, чем способны пропустить трубы. Только в нашем случае «трубы» — это заводы по производству полупроводников, которые, к сожалению, невозможно построить за одну ночь.

А теперь вопрос на засыпку: что делает рынок, когда всем не хватает? Правильно, взвинчивает цены до небес! И делает это с единственной целью — отсеять наименее платёжеспособных покупателей, чтобы оставшимся наконец-то начало хватать. Проблема в том, что в нашем случае самыми платёжеспособными оказываются отнюдь не геймеры, а крупные корпорации с их практически бездонными карманами.

В итоге получается, что «брить» будут именно нас — любителей игр и небольшие стартапы, пытающиеся запрыгнуть в уходящий поезд ИИ-революции. Крупные игроки готовы платить любые деньги за вычислительные мощности, а мы остаёмся с носом и пустым кошельком. И, к сожалению, в ближайшее время ситуация вряд ли изменится к лучшему.

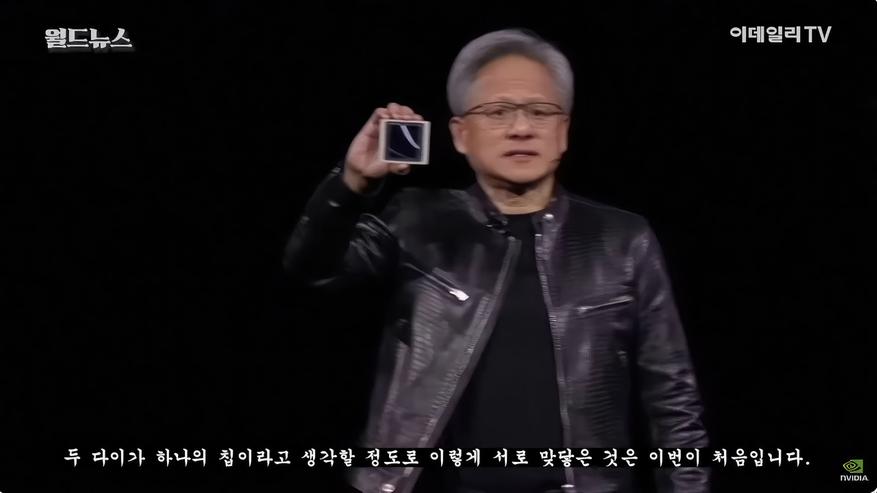

Жадность Хуанга и безальтернативность Nvidia

Знаете, кто больше всех выигрывает от сложившейся ситуации? Правильно, наш старый знакомый в кожаной куртке — Дженсен Хуанг, CEO Nvidia. И, надо сказать, он умеет пользоваться моментом. Если вы думали, что альтруизм — это про него, то я вас разочарую: Хуанг — тот ещё жлоб, каких поискать надо.

В 2024 году Nvidia оказалась в поистине уникальном положении. Видеокарты нужны всем — от геймеров до разработчиков ИИ и энтузиастов. CUDA, проприетарная платформа параллельных вычислений от Nvidia, стала де-факто стандартом в индустрии. Без неё как без рук и в энтерпрайзе, и в потребительском сегменте, где люди уже вовсю пользуются плодами нейросетевой революции локально. Попробуйте запустить какую-нибудь модную нейросеть вроде Stable Diffusion на чём-то кроме карты от Nvidia — намучаетесь с костылями и велосипедами.

Это ещё SD, которую благодаря усилиям сообщества только что на чайнике запустить нельзя, вопрос в объёме сопутствующих проблем. А если надо какую-нибудь нишевую модель не на Nvidia запустить, вроде синтеза речи или «портативной» языковой?

А что же конкуренты? Intel и AMD безнадёжно отстали даже по чистой производительности, еле-еле закрывая средний сегмент. У Nvidia образовалась фактическая монополия, помноженная на дефицит и эксклюзивность CUDA — идеальные условия для того, чтобы задрать цены до небес. Но Хуанг не был бы Хуангом, если бы остановился на достигнутом: мечта стать-таки ТОП-1 по капитализации не покидает мозг старичка.

Он пошёл дальше, намеренно «обрезав» младшие GPU (до 4060 включительно на десктопе и до 4070 включительно в ноутбуках) по шине и видеопамяти. Теперь у этих карт нет ни малейшей перспективы на будущее. Хотите видеокарту «с запасом»? Извольте выложить 60 тысяч за RTX 4070/4080m или идите лесом. А то, что год назад она стоила 50 тысяч при более дорогом долларе — так это ваши проблемы. У нас, знаете ли, дефицит!

Неразумное расходование ресурсов GPU

Казалось бы, куда уж хуже? Но нет, есть ещё один фактор, добивающий многострадальный рынок видеокарт — бесцеремонный подход игровых разработчиков к расходованию ресурсов. Особенно этим грешат создатели AAA-проектов, которые, кажется, совсем забыли о таком понятии, как оптимизация.

Сегодня считать полигоны и дроуколлы — удел жлобов и нищебродов. Все текстуры обязательно должны быть в 4К, использовать спрайты вместо полноценных 3D-моделей — это вообще моветон и харам, даже если речь идёт о бычке в пепельнице, который мелькает на заднем плане в течение полсекунды. Ну и, конечно, зачем оптимизировать модельку бычка из магазина ассетов на сто мегабайт, если можно просто впихнуть её в игру как есть?

И, само собой, какая современная игра обойдётся без рейтрейсинга? Теперь даже тлеющий огонёк того самого бычка в пепельнице обязательно нужно обсчитать по всем законам физики света. А что, вы разве не для этого покупали видеокарту за 100+ тысяч?

Справедливости ради стоит отметить, что проблема касается не только GPU. Оперативная память, место на диске, нагрузка на процессор — всё это тоже страдает от неоптимизированных игр. Но по традиции сильнее всего достаётся именно видеокартам. В итоге мы имеем ситуацию, когда даже топовое железо начинает задыхаться в попытках выдать заветные 60 FPS в 2К и выше. То есть видеокарты не только дорожают — теперь для той же производительности нужен ещё и чип классом выше.

Когда всё это кончится?!

Я знаю, о чём вы сейчас думаете. «Ну хорошо, ситуация паршивая. Но когда-то ведь это наконец закончится? Когда мы снова сможем покупать видеокарты по человеческим ценам?» У меня для вас не самые приятные новости: скорее всего, никогда.

Видеокарты по $700…$2000+ — это, увы, новая норма. И, похоже, это навсегда. История знает очень мало примеров, когда после серьёзной инфляции цены возвращались к прежним значениям. Обычно происходит ровно наоборот — то, что вчера казалось дорогим, завтра будет восприниматься как норма (и хорошо если рост цен вообще замедлитс). К сожалению, есть все основания полагать, что с видеокартами произойдёт то же самое.

Есть ли хоть какая-то надежда? Теоретически, да. Вот пара факторов, которые могли бы замедлить этот безумный тренд роста цен в среднесрочной перспективе.

- Падение внеигрового спроса на GPU-совместимые чипы. Но давайте будем честными: в условиях нейросетевой революции, которая только набирает обороты, это примерно так же вероятно, как снегопад в Сахаре. Искусственный интеллект проникает во все сферы жизни, и спрос на вычислительные мощности будет только расти.

- Другой вариант — серьёзная конкуренция от AMD или Intel. Но, увы, в ближайшие 2-5 лет это больше похоже на фантастику на грани фэнтези. Обе компании серьёзно отстали от Nvidia, и чтобы догнать зелёного гиганта, им понадобится нечто большее, чем просто в меру удачная линейка GPU, как это было с Polaris. Нужен технологический прорыв, а такие вещи, как известно, по расписанию не случаются. К тому же, TSMC всё ещё одна и безальтернативна, спокойно диктуя цены при любой конкуренции.

- Ну и последний, самый невероятный сценарий — если разработчики игр вдруг вспомнят о таком странном понятии, как «оптимизация». Но для этого, кажется, должны вмешаться высшие силы и лично настучать по голове руководству крупных студий и движкоделов.

К сожалению, куда вероятнее обратный сценарий. Нейросетевая революция только набирает обороты, а значит, спрос на мощные GPU будет расти как на дрожжах. Intel и AMD ещё долго не смогут составить серьёзную конкуренцию Nvidia, новых фабрик а чуда в виде внезапного прозрения игровых разработчиков ждать и вовсе не приходится.

Нам поможет только чудо

Итак, к какому же выводу я пришел? Как ни печально это признавать, но лучшее время для апгрейда — это, скорее всего, здесь и сейчас. Да, цены кусаются. Да, это больно бьёт по карману. Но завтра будет ещё дороже, а послезавтра — возможно, и вовсе в разы. Потому что все эти факторы — технологический потолок, растущий спрос, монополизм Nvidia/TSMC — они не просто складываются, а умножаются друг на друга, создавая эффект снежного кома.

Есть мнение, что даже проценты по кредиту, при всей их грабительской сущности, могут оказаться менее болезненными, чем разница в стоимости между покупкой GPU сейчас и через год-два. И даже если ситуация начнёт хоть немного нормализовываться, это произойдёт не раньше, чем через пару лет. А до тех пор нам остаётся только надеяться на чудо.

Каким могло бы быть это чудо? Например, освоение многослойных кристаллов с одновременным решением проблем их охлаждения. Это позволило бы обмануть смерть закона Мура, перейдя от плоских чипов к трёхмерным. Или, скажем, рабочая чиплетная компоновка GPU, которая позволила бы собирать мощные видеокарты с большой сумарной площадью чипа из более мелких и дешёвых в производстве кристаллов — то, что резко удешевило CPU, но пока никак не даётся GPU.

Но даже если какое-то из этих технологических чудес и случится, ждать его стоит не раньше, чем через пару лет. В лучшем случае.

А пока… что ж, добро пожаловать в дивный новый мир, где за право насладиться красотами виртуальных миров приходится платить вполне реальные и очень немаленькие деньги. Таков путь современного геймера и энтузиаста. Остаётся только смириться и затянуть пояса потуже — или начать копить на новую видеокарту уже сейчас. Или брать кредит. Кто знает, может быть, к тому моменту, как вы накопите нужную сумму, цены не вырастут вдвое ещё раз?

Источник: youtu.be

38 комментариев

Добавить комментарий

Такой херни Мур отродясь не нёс — он был умным мужиком :)

Там был «minimum cost per component». То есть каждый транзистор будет дешевле. Но совсем не вдвое — на сколько уж получится.

«Проблема в том, что в нашем случае самыми платёжеспособными оказываются отнюдь не геймеры, а крупные корпорации с их практически бездонными карманами»

Проблема-то в чём? И чья?

Рынок мобильных игр давно уже по объёму больше, чем комповых и консольных вместе взятых

Так что, как говорил ещё один умный мужик, вы не вписались в рынок. Идите три в ряд расставляйте ;)

«рабочая чиплетная компоновка GPU, которая позволила бы собирать мощные видеокарты с большой сумарной площадью чипа из более мелких и дешёвых в производстве кристаллов — то, что резко удешевило CPU»

Интересно — каким образом то, что в большинстве CPU не используется сумело их удешевить во-первых, и почему они так «удешевелись», что цены заметно выросли буквально за последние лет пять во-вторых? Может, дело было не бобине?

Источник? Оригинальная формулировка, известная мне, полностью:

> The complexity for minimum component costs has increased at a rate of roughly a factor of two per year. Certainly over the short term this rate can be expected to continue, if not to increase. Over the longer term, the rate of increase is a bit more uncertain, although there is no reason to believe it will not remain nearly constant for at least 10 years. <

«The complexity for minimum component costs» — переводится как «сложность (сиречь число транзисторов) при минимальной стоимости. В той же бумаге, к слову, приводится график прогнозов соотношения стоимости чипа к числу транзисторов на нём, буквально страницей ниже. Дугообразный — при выходе за зону оптимума (кристалл больше или меньше размером, чем «золотая точка» положенного по техпроцессу) цена в пересчете на транзистор растёт. Сурс: http://cva.stanford.edu/classes/cs99s/papers/moore-crammingmorecomponents.pdf, стр. 2

ПК-геймеров, о которых речь в статье. И, в меньшей степени, консольщиков.

Прямым. AMD навязала гонку ядер более дешевым чиплетным решением с меньшей долей брака, заставив Intel резать маржу. Пример, наглядно: MSRP i7-6700k — $339 и $85 на ядро, MSRP i7-14700k — $409 (индексация даже чуть меньше (!) инфляции, по которой 6700k стоил бы $449 в 2024) и $51 на ядро. Прямая выгода для потребителя. AMD — FX-8350, $199 MSRP в 2019, $50 на ядро (примем его за четырехъядерник, соответствующее решение суда было). Индексированная стоимость — $272 и $68/ядро. Для сравнения, возьмём r7 8700G и $329 — $42 на ядро без учета интегрированной графики. Так наглядно?

И да, часть этого роста можно списать на прогресс в техпроцессах, но не весь.

В массовых процессорах AMD нет никаких чиплетов до сих пор. В принципе. Причём AMD прошлой осенью открытым текстом объяснила, почему их там и не будет. Одна из причин — это как раз более _дорогое_ решение. Но в некоторых случаях идти на такое приходится.

А то и не на такое — как Intel со сборкой из своего процессора и южного моста на одной подложке с GPU AMD и 4 ГБ HBM2. Адский коктейль — но работал и прямых конкурентов не имел. Больше так не делают, поскольку прямые оказались и не слишком нужны.

«Так наглядно?»

Наглядно — закусывать надо. Уж не говоря о том, что R7-8700G как раз монолит, как и где-то так 3/4 отгрузок AMD

Основная проблема Intel в данном случае — она сейчас отстаёт от TSMC по нормам производства. Не сказать, чтоб сильно, но этого достаточно

Да и это-то не беда а пол-беды. Полная — все остальные сейчас тоже отстают от TSMC

А кто там из двух fabless-компаний лучше в разработках на этом фоне мелочи. За GPU и AMD, и Nvidia идут к одной и той же TSMC. Да и Intel — за GPU и некоторыми плитками для метеоров туда же на данный момент. Далее рыночек может и порешать того, кто не готов платить за услуги столько, сколько просит монополист. Nvidia вон готова, поскольку потом на своих продажах отобьёт — ну и всё на этом

«ПК-геймеров»

Уффф… отлегло. Я уж боялся, что действительно какая-то проблема ;)

Потому что сейчас ядерная гонка приостановилась (с релиза первого r7 мейнстримом стали 6, и почти сразу — 8 ядер, с тех пор опять стагнация — вот нормы производства и догнали число ядер в «золотой зоне». Если точнее — позволили создать восьмиядерный монолитный чип-модуль, а именно это число стал ходовым в нынешнем поколении консолей. А вот первые ЕМНИП 4 поколения Ryzen (до 5xxx не включительно) — именно чиплеты 4+4 давали массовые процессоры, позволив эту «ядерную гонку» навязать и радикально удешевить процессоры. Даже четырехъядерники лепили из отбраковки с двумя рабочими ядрами на чиплет.

Сейчас они столь же спокойно кластеризуют 8+8, давая до 16 ядер в потребсегменте и за потребительскую же цену, что раньше было неслыханно вне серверного рынка.

Если в PS6 и Series XXX будет чип на 12 ядер (из двух блоков по 8, чтобы отбраковка двух ядер на каждом не била партию), то и чиплеты снова вернутся в средне-низкий сегмент.

А главное — сейчас ситуация именно как перед релизом 1 поколения Ryzen — для GPU мы уперлись в лимит площади кристалла на доступном техпроцессе по адекватной цене. Дальше или чиплетизация, или цугундер, или одно из двух.

Собственно, о чем и в статье. Согласен целиком и полностью.

А вот с этим не согласен. При нормальной конкуренции Nvidia бы не пёрла в ТОП1 по капитализации за счет клиентов. Сейчас они закладывают премию монополисту TSMC и премию себе тоже как монополисту. Если TSMC поднимет цены — они поднимут цены, если куртка захочет — они поднимут цены ещё раз. Если бы большая N не была монополией — начались бы демпинговые гонки, прибивающие цену к планке самоокупаемости с текущими ценами TSMC. Дороже, чем было, но не НАСТОЛЬКО дороже.

Проблема для геймеров, о которых и статья.

«А вот первые ЕМНИП 4 поколения Ryzen (до 5xxx не включительно) — именно чиплеты 4+4 давали массовые процессоры»

Чиплеты только _появились_ в 3000. В 4000 их не было в принципе, ага (вопрос «почему?» — для самостоятельного изучения), в 5000 и далее они есть. Причём массовые (то есть ноутбучные) модели с чиплетами появились только в 7000-й серии. Как раз с 12- и 16-ядрами. Но их примерно так ноль целых хрен десятых по объёмам

А у _всех_ процессоров на Zen/Zen+ _монолитные_ кристаллы. В триперах — несколько, но тоже монолитных. И вся массовка то есть ноутбучные APU от 2000 до 6000 + большинство 7000/8000 — монолитные

CCX никакого отношения к чиплетам не имеет. Подобный подход в GPU как раз лет так 20 использовался и используется. И что-то как-то ни на что не повлиял. Более того — и у Intel в многоядерных чипах коммутаторы были для связки кластеров на кольцевой шине — она до 10 ядер только одна

Чиплеты, повторюсь, совсем другая история. И только начиная с настольных и серверных 3000 и в некоторых ноутбучных 7000/8000

Остальное — совершенно банальный монолит

«Дальше или чиплетизация»

И как же хоть в первом, хоть во втором поколениях Ryzen и практически всех APU без чиплетизации-то обходились и обходятся? ;)

Давайте обратимся за помощью к Википедии.

> A fundamental building block for all Zen-based CPUs is the Core Complex (CCX) consisting of four cores and their associated caches. Processors with more than four cores consist of multiple CCXs connected by Infinity Fabric.[26] Processors with non-multiple-of-four core counts have some cores disabled. <

Или, скажем, посмотрим на фото — тоже прекрасно видно два CCX-чиплета на одной подложке. https://encrypted-tbn0.gstatic.com/images?q=tbn:ANd9GcR_7L1giykk_w8yWFETL27oKMV1M6IzwoNKBA&s

Определение чиплета IEEE: https://eps.ieee.org/technology/definitions.html

«Это блок интегральной схемы, который был специально разработан для связи с другими чиплетами, чтобы сформировать более крупные и сложные ИС. Таким образом, в больших и сложных микросхемах дизайн подразделяется на функциональные блоки схемы, называемые «чиплетами», которые производятся и объединяются на высокоплотных межсоединениях. »

Был ли CCX специально разработан, чтобы иметь возможность связи с другими CCX? Да, посредством шины Infinity Fabric. Вынос части функционала на более старшие техпроцессы опционален.

Определение чиплета IBM: https://research.ibm.com/blog/what-are-computer-chiplets

«Идея чиплетов заключается в том, чтобы разбить систему на чипе на составные функциональные блоки, или части. В качестве чиплетов могут выступать отдельные элементы сложного функционального чипа, среди которых может быть отдельный вычислительный процессор или графический блок, ускоритель искусственного интеллекта, функция ввода-вывода или множество других функций чипа.»

Тоже не вижу ничего, что не дало бы CCX подпасть под это определение.

Назовите мне видеокарту с двумя чипами общего назначения (!) на одной подложке, работающими в общем режиме (не двумя отдельно распаянными на плате кристаллами и не в SLI/CrossFire). Лично я таких не знаю.

Настолько всё запущено, что приходится информацию из помоек типа говнопедии черпать? :)

Впрочем, про ССХ я выше уже сказал

«Назовите мне видеокарту с двумя чипами общего назначения (!) на одной подложке»

С чего вдруг взялись два чипа, когда в процессорах он один?

Ну вот в чиплетных — от двух и более, да. Но первые кукурузены тут не при чем.

И чтоб два раза не вставать:

https://www.ixbt.com/cpu/intel/intel-nuc-6i5syh/skylake-gt3e.jpg

Вот это не чиплеты. Хотя и многокристалльная SiP

Тем паче, гляжу, вы уже совсем в двух соснах заплутали:

«не двумя отдельно распаянными на плате кристаллами»

Вообще-то в двух чипах точно не меньше двух кристаллов. Вот больше — бывает. Но один на два точно не разделиnь. Почему, собственно, чиплеты с плитками и пришлось придумывать ;)

— отказаться от ПК и перейти на игровые приставки или стимдэк

— отказаться от ПК-гейминга и купить велосипед, заняться спортом, воспитанием детей, дачей/гаражом и прочими занятиями в реальном мире

Фондовый рынок сшп это 6 компаний, все айти. При этом доля куртки 30%

Ничего теперь не напоминает?

А крепкие среднечки с лучшим соотношением цена/производительность все эти годы стоили в районе 150-200 баксов.

Конкуренцию в чем — в доле рынка? Вероятно. Но если б они не повторяли за жадным Хуангом, то 7000-я серия могла бы эту долю увеличить.

З.Ы. Что за кривое г-но местное цитирование? :-(

А не получится — они все в одном месте производятся ;)

В этом месте почти все производятся, так что при бОльшем спросе AMD могла бы увеличить заказы, потеснив более мелких клиентов.

Да и далеко не всё там производится (иначе бы совсем тоска была), причём на разных линиях

Но вот по факту что AMD, что Intel, что Nvidia, что Qualcomm, что Mediatek (уже) от TSMC нужны как раз самые лучшие процессы. И не факт, что у AMD слишком много шансов в такой давке — она в общем-то достаточно мелкая и небогатая до сих пор

А реально «мелким клиентам» до сих пор потребны всякие 12 нм и даже хуже. У них и выбор пошире, и вообще другие линии нужны

Где вариант послать лесом ленивых разрабов и жадную куртку даже не рассматривается.

Добавить комментарий