Апгрейд бюджетного компьютера: замена GTX 1650S на RTX 3050. Всё невозможно рассчитать

Фраза «Собрал компьютер под апгрейд» довольно распространённая. Многие хотят собрать с минимальными затратами сейчас, чтобы завтра за небольшие деньги сделать его мощнее. Но знаете что самое постоянное? То что задумывалось как временное. И поэтому фраза Компьютер под апгрейд в 90% случаев обозначает что система будет стоять неизменной лет 10. Но бывает что пользователь всё же собрался улучшать свою систему, но есть множество проблем с которыми придётся столкнуться.

Мой ПК был собран в конце 2020 года на основе связки GTX 1650Super + Ryzen 3 3100 + 8Гб DDR4. Через некоторое время в системе появилась вторая плашка памяти и разношёрстный комплект был разогнан, видеокарта подвергнута андервольту с последующим разгоном, появился м2 накопитель... Система потихоньку видоизменялась, но основные комплектующие не менялись, и вот спустя 2 года был произведён первый крупный апгрейд.

Теория и история одного ПК

Но всё прошло не так гладко как хотелось бы. В начале следовало определиться что менять в первую очередь, разумеется таких элементов два: ЦП и ГП. Но каждый из них требовал бы сопутствующий апгрейд, и начать я решил исходя из имеемой суммы. Как ни крути, самым дорогим в системных блоках остаются видеоускорители. Ну чтож, ГПУ так ГПУ, начнём с него. Есть сумма в 25+-2 тысячи рублей, что позволяло взять видеокарту RTX 3050 или RTX 2060. GTX 1650 самая бюджетная карта в семействе Turing, RTX 2060 самая младшая карта с поддержкой RT и DLSS, а RTX 3050 их наследница в семействе Ampere. И можно было бы сказать что замена на любую из этих карт это шила на мыло, но тут не всё так однозначно, при чём в пользу замены на последнюю карту.

Ну хорошо, определились что надо брать видеокарту, что делать дальше? Вроде как купил, вставил в корпус и наслаждайся, но кто заказывал подводные камни? Потребление карты. Palit GTX 1650 Super в пике не превышает 100 Вт, что позволяет использовать только один 6pin коннектор питания, который в сумме с питанием по PCIe может передать карте 150Вт. В целом неплохо, карта получает сколько ей нужно. У Gigabyte RTX 3050 уже восмипиновый коннектор питания, что позволяет карте потреблять свыше 200Вт, если быть точным то 225Вт, хотя потребление карты заявлено на уровне 130Вт. Возможно Гиги немного подкрутили потребление, может нет, посмотрим дальше.

А пока вернёмся к цифрам, на сайте Gigabyte рекомендуемый БП для данной карты 450Вт, при том что сама Nvidia рекомендует блок с мощностью от 550Вт. Кто из них прав разберёмся позже, когда посмотрим какое потребление карты в играх и программах.

Но этот материал можно было бы связать с несколькими предыдущими общим циклом "История одного ПК", так что надо не забыть про некий личный опыт. Если вбить мою систему в какой-нибудь калькулятор мощности БП, как я с ними намаялся, что два года назад, что сейчас, то они покажут потребление в районе 360Вт, и вроде можно оставить блок старый, но... Начнём с процессора: четыре ядра на Zen2 выглядят неплохо, но разбиение связок двух ядер в два отдельных блока портит картину. Но это ещё не всё, до недавнего времени система работала в стоке и наблюдались какие-то микрофризы, которые встречались больше в сёрфинге интернет, чем в играх. И вот в начале лета я решил потыкать DaVinci и понял что если в предпросмотре пустить то заиграет музыка и снова покажут «6 кадров». Тогда через Razen Master я снял лимиты по потреблению, что позволило процессору потреблять не 95 Ватт, а до 180. Из-за этого кол-во микро фризов уменьшилось, они остались только в процессорозависимых моментах.

А так же не забудем к снятым лимитам потребления добавить разгон памяти, которая в текущей работает на 1,38V. Так же полный набор дисков, - ноутбучный хард, три SSD и m2, две вертушки, ещё по мелочи… И пиковое потребление в пике, по сухим расчётам, может доходить до 380-400Вт. Принимая во внимание что блок с эффективностью не 100%, а также то что постоянная работа на предельной мощности не самым лучшим образом влияет на срок службы устройства... А наибольшая эффективность компьютерных БП зачастую находится в промежутке от 50 до 80%, что явно не наш вариант. И заменяя блок можно ещё и сыграть наперёд в вопросе пгрейда, ведь пятитысячная серия процессоров AMD стала более требовательной к питанию. Да, это в меньшей степени относится к обычному R5 5600, и практически не относится к R5 5500, который по своей сути является адаптацией для десктопов мобильного кристалла.

Вот это то про что я говорил, к каждому апгрейду требуется сопутствующий апгрейд: к видяхе нужен новый блок, а к новому процессору нужна новая плата. И если блок это что называется обязательный апгрейд, то с платой не так всё просто. Gigabyte B450M S2H хорошая плата, помимо PCIe x16 есть два PCIe x1, один из которых довольно удобно расположился, так же имеется слот м2 и простенький радиатор на цепи питания. Но платы на чипсете B450 имеют только PCIe 3.0, это не так критично для старших или старых карт, однако моя новая карта имеет только 8 линий PCIe 4.0, что может, и будет влиять на производительность. Так же один из портов подключения SATA дисков находится в непосредственной близости от видеокарты. До этого я это даже не замечал, ведь 1650S довольно компактная карта, а сейчас, установив карту длиной более 200мм, это стало заметно: Г-образный кабель не подключить, ибо под ним находится ещё 2 разъёма, а если не зафиксировать провод, то кабель будет попадать в лопасти вентилятора. Но если вы думали что это всё, то нет. С питанием так же не всё хорошо, для такого простенького камня всё неплохо, однако для питания ядер отведено только 4 фазы, ещё 3 отвечают за работу SOC. Так что если ставить что-то более крутое, к примеру R5 5500 или 5600, то стоит подумать, а хватит ли этих 4 фаз и как сильно они будут греться?

Так что смена процессора повлечёт и смену платы. Хотя на бумаге всё выглядит красиво, В450 платы поддерживают Ryzen 5ххх, и на этом сейчас начали предлагать собирать системы с нуля. И вроде как поддержка есть, и дешевле выходит, но… Но неопределённость с PCIe 4.0 на физическом уровне, программно вроде как включается, но если на плате его не реализовали физически, то как его добавить чисто программно, для меня вопрос. Помимо этого VRM, который не всегда рассчитан на жористые камни, ведь в последних поколениях красные камни стали потреблять больше. Так что перед сборкой новой системы на Ryzen 3xxx/5xxx и платы на B450 прикиньте вытянет ли питание, и имеется ли реализация PCIe 4.0, а то практика с урезанием шины у младших карт стала уже повсеместной.

На этом закончим с личным опытом и перейдём к теории. Рассмотрим что можно получить при замене 1650 на 3050:

| GTX 1650 Super | RTX 3050 | |

| Кол-во CUDA | 1280 | 2560 |

| VRAM | 4096 | 8192 |

| ПСП, Гб/с | 192 | 224 |

| Версия DirectX | 12_1 | 12_2 |

| Технологический процесс | 12 нм ТSMC | 8 нм Sumsung |

| Кол-во транзисторов, млн | 6600 | 12000 |

| Потребление, Вт | 100 | 130 |

| Площадь ядра, мм² | 284 | 276 |

| Цена в момент выхода, $ | 159 | 249 |

По кол-ву ядер CUDA и объёму памяти произошло удвоение, при этом сам чип уменьшился. Уместить вдвое больше транзисторов на чипе, который уменьшился на 8мм², удалось в том числе благодаря переезду на более тонкий технологический процесс. Однако в противовес этому выросли энергопотребление и цена. Так что перейдём к практической части. В данном материале будет тест связки Ryzen 3 3100 с RTX 3050, с памятью DDR4 3600 и PCIe 3.0. Хотелось бы проверить на что способна данная связка, ведь комбинация райзена и платы b450 это довольно интересно, и что самое главное дешёво. А это, как я уже отмечал выше, накладывает некоторые ограничения.

К конкретной модели. RTX 3050 в исполнении Gigabyte Eagle OC. Сразу отвечу почему эта модель, в момент покупки, а это 17 октября, в магазинах имелось две версии 3050: GIGABYTE Eagle и KFA2 Core. Первая из них была в двух вариантах: Eagle и Eagle OC. Вторая модель обладает чуть большей частотой в бусте, и в придачу стоит на тысячу с небольшим дешевле (в момент покупки, а сейчас, как видно, ещё дешевле). Да, мне как всегда повезло, после покупки карты, буквально через 2,5 недели, цены упали на 2 тысячи, но из плюсов удалось урвать блок питания по скидке, хоть что-то. Так что выбор у меня стоял между Eagle OC и Core. В целом это идентичные карты в плане характеристик, да и сомневаюсь что на плате будут сильные отличия, как никак карты идут в одну цену, при том это одни из самых дешёвых 3050 в принципе. Но вот охлаждения отличаются: kfa2 предлагает две тепловые трубки и один вентилятор, а gigi два вентилятора с одной трубкой. Помимо этого Eagle длиннее и толще, что стоит учитывать при сборке компьютеров, о чём я уже писал выше.

Тесты

Начнём с парочки синтетический тестов, - 3dMark, DaVinci Resolve и Topaz Video Enhance AI; после которых немного игр. Если рядом с каким-то приложением стоит обозначение лаунчера и Вам непонятно зачем, то ознакомтесть с данным материалом по сравнению лаунчеров.

3dMark (Steam)

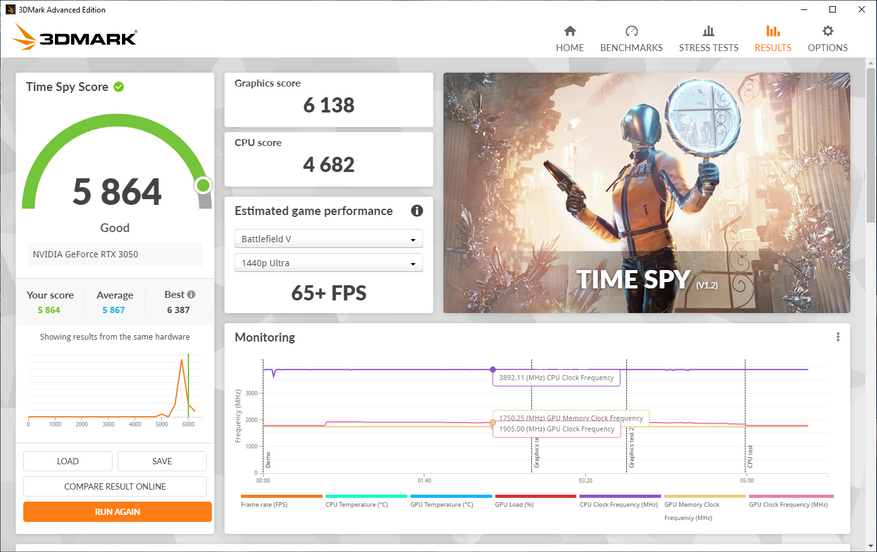

В 3dMark имеется ставший уже классическим тест TimeSpy. С реальной нагрузкой он имеет не так много общего, однако как мерило производительности подходит. После трёх прогонов получаем среднее значение графических баллов 6088,6. Вполне неплохо, переходим дальше.

| 1 прогон | 2 прогон | 3 прогон | Среднее значение | |

| Графический балл | 6072 | 6082 | 6112 | 6088,6 |

| Итоговый балл | 5805 | 5812 | 5848 | 5821,7 |

Topaz Video Enhance AI

В Topaz Video Enhance AI возьмём видео из теста DaVinci, который будет следующим, только в низком разрешении. Рендерим ролик в DaVinci в разрешении 480р, после чего заходим в Video Enhance и выставляем в настройках рендер на GPU, режим Progressive Footage to 4k. И по после всё тех же трёх рендеров получаем среднее время 1 минут и 4 секунды.

| 1 прогон | 2 прогон | 3 прогон | Среднее значение | |

| Время, сек. | 64 | 63 | 64 | 64 |

DaVinci Resolve

Для теста DaVinci я возьму один из своих экспериментов, анимацию появления портала. Вроде анимация очень простая (сама анимация), однако вокруг этого портала летает 5000 частиц, и ещё какая-то часть от этих 5000 рендериться в отражении. Ставим рендер на CUDA, в QuickTime Н264 и повторяем процедуру трижды. Моя прошла карта справлялась с восьмисекундным отрезком за 17 с небольших секунд, 3050 же справляется с этим за 12.

CS:GO

Игра явно выдаст кадров больше чем нужно для комфортной игры, но для себя я её проверить обязан, в конце концов я тестирую в том числе и то, что буду использовать и запускать очень часто. Используем карту FPS Behcmark, которая сразу подскажет средний фпс, выставляем максимальные настройки в FHD, сглаживание MSAA 8x без FXAA. К вопросу почему в CS нет смысла выводить минимальный fps: есть такое особое место в игре, дым называется. В дыму кадровая частота просаживается до 20-40, и это не зависит от мощности системы. Так что в тестах данной игры имеет смысл только средний и/или максимальный FPS. Хотя с максимальным fps тоже есть вопросы, ведь в конце тестового отрезка камера улетает в пустоту, без всякой геометрии и текстур.

| 1 прогон | 2 прогон | 3 прогон | Среднее значение | |

| Средний fps | 278.4 | 275.6 | 274.7 | 276.2 |

Cyberpunk 2077

Игра постепенно становится всё лучше, в техническом плане в том числе, так что проверим на что способна данная карта в этой игре. Однако тот факт что игра становится всё лучше, не значит что в ней нет проблем, и я во время тестов обратил внимание на два пункта: на Впечатляющих настройках загрузка на ЦП выше, на ГП соответственно ниже, чем на более низком пресете, - Высокое, хотя они отличаются тем, что на Впечатляющем пресете отключен AMD FSR (на Высоком пресет Качество), а так же поднятыми на одну ступень параметрами отвечающими за туман, облака и динамические декали. Вроде как усложнюсь альфа составляющая кадра, большее кол-во элементов с динамическим освещением, но нагрузка на ГПУ не выросла, но оставим это разработчикам. Второй проблемой для меня стал бенчмарк, после прогона которого тебя выкидывает на загрузочный экран, и приходится заново заходить в игру, потом в настройки для того чтобы прогонять тест повторно. Но второй момент это не такая большая проблема, это банальный дискомфорт. И проблемы CP2077 становятся уже чем-то вечным, как баги Skyrimа.

Но от плохого к хорошему, игра поддерживает RT и DLSS, которые мне бы тоже хотелось потрогать. Выставляем Впечатляющий пресет, запускаем бенчмарк и смотрим. Результаты из встроенного бенчмарка

| 1 прогон | 2 прогон | 3 прогон | ||

| Средний fps | 73,6 | 74,6 | 74,3 | 74,2 |

| Максимальный fps | 103,8 | 108,2 | 105,3 | 105,8 |

| Минимальный fps | 38 | 16,6 | 38,1 | 30,9 |

| Без RT | RT min. DLSS off | RT min. DLSS авто | RT min. DLSS кач. | |

| Средний fps | 74.2 | 55.55 | 50.9 | 51 |

| Максимальный fps | 105.8 | 77.3 | 72.1 | 82.6 |

| Минимальный fps | 30.9 | 42.8 | 32.3 | 31.2 |

Почему при включении DLSS fps упал, вопрос открытый, видимо автоматическая семена режима DLSS игре ещё толком не под силу. Хотя может дело как в моментах выхода из бенчмарка, ибо в тот момент игра выкидывает на стартовый экран и возможно, возможно, я точно не знаю, игра может выгружать данные и каждый запуск бенчмарка является "холодным". Если что игра лицензионная со всеми обновлениями.

Shadow of the Tomb Raider

Последняя на данный момент часть приключений Лары Крофт. Игра уже долгое время пребывает в тестовых подборках, так что не будем исключать её. Единственное что меня в этом смущает это данные по бенчмарку, зачастую все тестеры берут только данные по третей сцене. Почему так не особо интересовался, но в связи с тем что я тянул с этим материалом месяц, то вот оба набора: данные по всему бенчмарку, с замерами через встроенные средства, а так же данные по третей сцене, с замерами через MSI Afterburner.

| FPS ГП | 1 прогон | 2 прогон | 3 прогон | Среднее значение |

| Средний fps | 59 | 60 | 59 | 59 |

| Максимальный fps | 94 | 96 | 96 | 95 |

| Минимальный fps | 46 | 46 | 46 | 46 |

| 1 прогон | 2 прогон | 3 прогон | Среднее значение | |

| Средний fps | 61,9 | 63,7 | 63,6 | 63,1 |

| Максимальный fps | 92,5 | 95,8 | 95,4 | 94,6 |

| Минимальный fps | 49,9 | 51,1 | 51,4 | 50,8 |

| 1% | 44,4 | 46,2 | 46,3 | 45,6 |

| 0,1% | 41,9 | 43,2 | 42,8 | 42,6 |

А ведь в этой игре есть RT, так что включим RTX-тени на ультра и проверим как упал FPS.

| RT (данные по бенчмарку) | RT (данные по 3-ей сцене) | |

| Средний fps | 42 | 46,6 |

| Максимальный fps | 76 | 74,9 |

| Минимальный fps | 33 | 32,7 |

Разгон одной кнопкой?

Вот уж не знаю, это моя система что-то шалит, то ли драйвера от Nvidia решил что карта должны быть энергоэффективной, но в данный момент это не имеет значения, особенно если знаешь результат. После ситуации с моей GTX 1650S, когда её Power Limit оказался занижен, про этот случай я рассказывал в данном материале, в оверлее у меня выводится напряжение и потребление карты. И вот, во время тестов я заметил что потребление моей новой карты колеблется в районе 100±2Вт, а как вы помните TDP заявленное Nvidia - 130Вт. Потребление видеокарты оказалось ограничено значением 76% от максимальной мощности, при том что через MSI Afterburner можно поднять лимит до 110% от TDP. Благо новый блок спокойно передаст карте лишнее 40 Вт, так что выкручиваем ползунок и повторим.

В этот раз думаю можно обойтись и без подробных тестов, несколько символических прогонов, дабы понять, - есть ли смысл повышать предел потребления, или всё упирается в другие вещи?

| 76% TDP | 110% TDP | |

| Графический балл | 6088,6 | 6138 |

| Итоговый балл | 5821,7 | 5864 |

В 3dMark TimeSpy прирост от снятия лимитов составил около 0,9% графических баллов, при этом потребление в пике доходило до 139Вт. Понять отчего такой маленький прирост конкретно в этой задаче я в принципе могу: максимальная частота поднялась всего на 30МГц, а снятие лимитов разве что увеличило «жор» карты. Но на то это и синтетика, проверим на примере пары игр.

Но после первых же прогонов Cyberpunk 2077 и Shadow of the Tomb Raider, что без RT, что с ними, надежды испарились. Игры отреагировали на повышения лимитов так же как синтетика, - никак. Единственное отличие от 3dMark заключается в том что потребление карт в пике не превышало 135Вт, а в среднем держалось на отметке 125±2Вт.

В таблице данные Лары по третьей сцене с замерами через MSI Afterburner, на скринах отдельные прогоны бенчмарка

| Cyberpunk 2077 | Cyberpunk 2077+RT | SotTR | SotTR+RT | |

| Средний fps | 75 | 57.85 | 63.7 | 47.9 |

| Максимальный fps | 106.1 | 79.2 | 95.4 | 76.7 |

| Минимальный fps | 24.2 | 28.9 | 51 | 33.2 |

Вывод

Что в итоге можно сказать про карту по итоге. Исполнение Gigabyte выглядит солидно, однако по охлаждению есть вопросы. Температуры в норме, но вот с температурами в режиме 2D есть вопросы, - карта имеет пассивный режим работы, однако этот режим работы я замечаю только если нагрузка на систему минимальная. Не низкая, именно минимальная. При старте системы, пока работает что-то из офисного пакета от Мелкомягких, вертушки не будут включатся, однако стоит запустить браузер, где есть поддержка декодирования видеокартой, либо поработать за системой минут 30, то вертушки включаются и уже врятли остановятся. Кто-то может списать это на корпус, у меня AeroCool Cylon, а это тот ещё не продуваемый ящик, про что я сказал при обзоре.

Но дело в том что мой блок сейчас выглядит так:

Переднее стекло снято уже давно, а то это совсем парилка, а задняя крышку я снял после смены блока, ведь места под кабеля нового блока не хватило. Про то что места под кабель-менеджмента очень мало я упоминал в обзоре, а с блоком на 450Вт задняя крышка закрывалась через силу, а с новым блоком...

И если в играх температура в норме, ну или в её приделах, что видно по тесту в 3DMark, где пиковая температура чипа лишь немного превышает 70ºС, но если запустить тест GPU из пакета OCCT, то пиковые температуры самой горячей точки подойдут вплотную к 95ºC, при средних значениях по GPU в 75º. Это всё на автоматических оборотах, при Power Limit в 110%. И исходя их того что прирост от повышения лимитов не превышает, я бы сказал, погрешности тестирования, а при снижении этого лимита до «номинальных» 100% пиковые температуры падают до более примерных 90ºС... Так что в ближайшее время, или точнее как появится время, можно будет вновь заняться андерволтом.

Скорее всего при смены платы на материнку с поддержкой PCIe 4.0 прирост появится, пока есть вероятность что идёт упор в шину: возможно у карты голод данных. Но пока мне непонятно, во что больше упирается система, в урезанную шину или в слабый процессор. И всё это задел на будущие тесты, когда будет плата с PCIe 4.0.

Касательно того почему не было сравнений с моей GTX 1650S, это само по себе интересно, так ещё и могло послужить прекрасным продолжением вот этого материала, где я сравнивал GTX 650 и 1650S. Да, в том сравнении были свои условности, как например тесты самой слабой итерации 650 с самой производительной 1650, однако продолжать сравнение самых слабых игровых карт в игровых линейках, да да есть ещё ультрабюджетная серия GT, которая была и в 600-ой линейке, и в 16хх, но эти карты в данный момент я вывожу за скобки. Так вот, к вопросу почему этого сравнения тут небыло: слишком большая погрешность от теста к тесту. Материал с тестами GTX 1650S вышел больше года назад, за это время Windows не раз обновлялась, лаунчеры тоже не стояли на месте, но эта та разница которую можно было бы принять за погрешность тестирования. Но вот факт того что в том тесте память была 3200, а сейчас 3600, увеличены лимиты процессора, системные параметры так же менялись… И вот это уже может сказаться на результате, а при учёте что должны быть тесты видеокарт, это явно создаст несколько процентов дополнительного преимущества сегодняшнему пациенту.

P.S. За этот материал я сел ещё в конце октября, и анонс Portal RTX для меня стал одним из аргументов в пользу покупки видеокарты, а не связки проц + материнка. Мне очень нравится серия, и обе игры я прошёл на несколько раз, и единственное что осталось не тронутым это кооператив второй части, который мне банально не с кем пройти. И вот сейчас начало декабря и огласили системные требования, где 3060 в минимальных требованиях для FHD для игры на минималках при 30 кадрах в секунду… Игра даже вышла, и вроде даже первые миссии у меня получилось пройти без проблем, но об этом поговорим позже

P.S.S С памятью я на самом деле играюсь уже полгода как, и пока вроде остановился на текущем варианте, но не уверен. Всё же хочется напряжения пониже чем 1.38, но тогда придётся или частоту скидывать, или тайминги задирать.

17 комментариев

Добавить комментарий

I9 11900 + RTX 3090 ))

Похоже у автора талант не только в области альтернативного использования русского языка, но в выборе убогих видеокарт с порезанным питальником и никакущей СО… для полноты картины осталось ещё выбросить деньги, потратив их на мат.плату с поддержкой PCIE 4.0 :-(

ну если ты так хочешь, то покупай плату на agp, переходник на pci и сиди так, тебя никто не заставляет

ну киберпанк, лара, средневысокие и есть 60 фпс, портал ртх тоже работает, хотя я до сих пор не понял зачем там вообще ртх

радиатор на vrm, м2, 4 сата и два pci x1. Единственное что это мало фаз на питание проца, о чём я и говорил.

А продавать нет желания, ибо у меня есть кому отдать железо, и карту после теста сравнения я отдам родным которым она будет нужнее чем мне сейчас

3050 всё равно оказывается странным выбором — маленький прирост, невыгодность по сравнению с 2060 Super. 2060 Super так же укладывается в бюджет (25 ± 2), но на четверть быстрее и избавляет от обсессий о ширине шины. Влияние ширины шины уже тестировалось. Поэтому пост многих разочаровывает (и меня тоже).

Вот такой 'надежный вариант'.

Странно, что автор БП на киловатт не купил.

Что-то про мышек и кактус.

Про питалово:

Я еще лет 15 назад сразу покупал бп 850 ватт и закрывал вопрос питания.

Также после автора железо гретое 'не покупать')

Про разгон:

Я тут даунвольт во всю, у меня память на 3600 работает на 1.23в…

И проц минус 0.1…

Добавить комментарий