Ретро-обзор: видеокарта Matrox G200 8 МБ — «убийца» Voodoo 2

Обзор видеокарты Matrox G200 8Mb второй половины 1998 года, прозванной задолго до релиза «убийцей» Voodoo 2.

Содержание

История

Видеокарта была анонсирована 1 мая 1998 года, и стала первым полноценным 3D чипом Matrox. Да, видеокарты с 3D возможностями Matrox делала с начала 90х, но всё это так или иначе были костыли с фирменными API, годными разве что для работы в CAD приложениях и паре десятков игр, в той или иной степени оптимизированных для работы с данными картами. Собственно, это и не удивительно, ибо нормальные 3D API появились только в 1997 году в виде DirectX 5.0 и OpenGL 1.1. Кое кто успел выпустить карты с их поддержкой в 1997 году — ATi Rage Pro, nVidia Riva 128, а вот Matrox и S3 задержались со своими картами до второй половины 1998 года. Ну и над всем этим возвышалась 3Dfx выпустившая в начале 1998 года свою легендарную Voodoo 2, которая помимо DirectX и OpenGL имела так же и свой фирменный API Glide, имевший широкую поддержку среди разработчиков игр.

Вернёмся уже обратно к Matrox G200, который по традиции предоставляли лучшее на рынке качество 2D изображения — 32bit цвет, разрешение экрана вплоть до 1600х1200, поддержку широкоформатных экранов и 32bit Z-буфер для CAD приложений. Также старшие модели видеокарт на данном чипе позволяли осуществлять захват аналогового видео и прочие штуки для работы и обработки видеосигнала.

Видеокарты задолго до появления в продаже получили звание «убийцы» Voodoo 2 и все обзоры на них так или иначе писались с придыханием и трепетом в превосходных тонах. И действительно, по части 2D даже сейчас карта даёт просто бомбическую картинку. Но меня как в те годы, так и сейчас интересует её игровое применение и то на что она способна в играх. А вот с этим у неё на релизе были большие проблемы, ибо на релизе она умела работать только с Direct3D, а полноценный OpenGL драйвер был выпущен только в декабре 1998 года, да и тот имел такую низкую производительность, что врапперы OpenGL через Direct3D в том же Quake 2 оказывались предпочтительней. Но такая ситуация в принципе не была чем-то из ряда вон выходящим в те годы.

Тестируемый экземпляр

Я уже как-то проводил краткое тестирование Matrox G200 в обзоре на видеокарту Intel i740 и выяснилось, что по игровой производительности-то у них паритет.

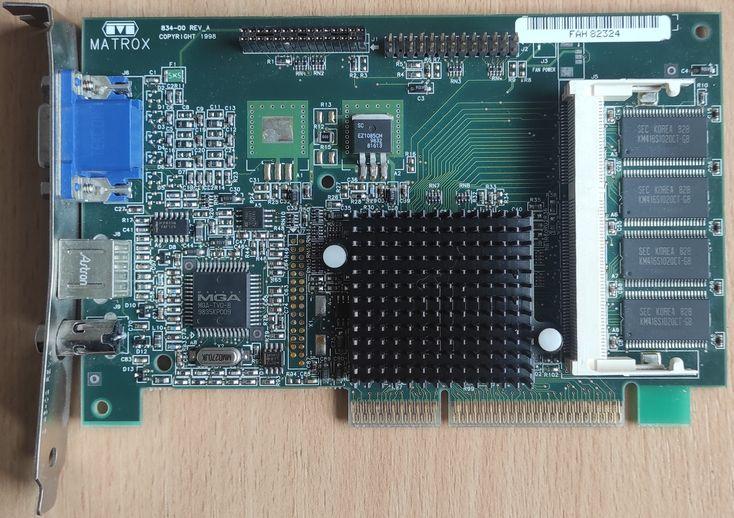

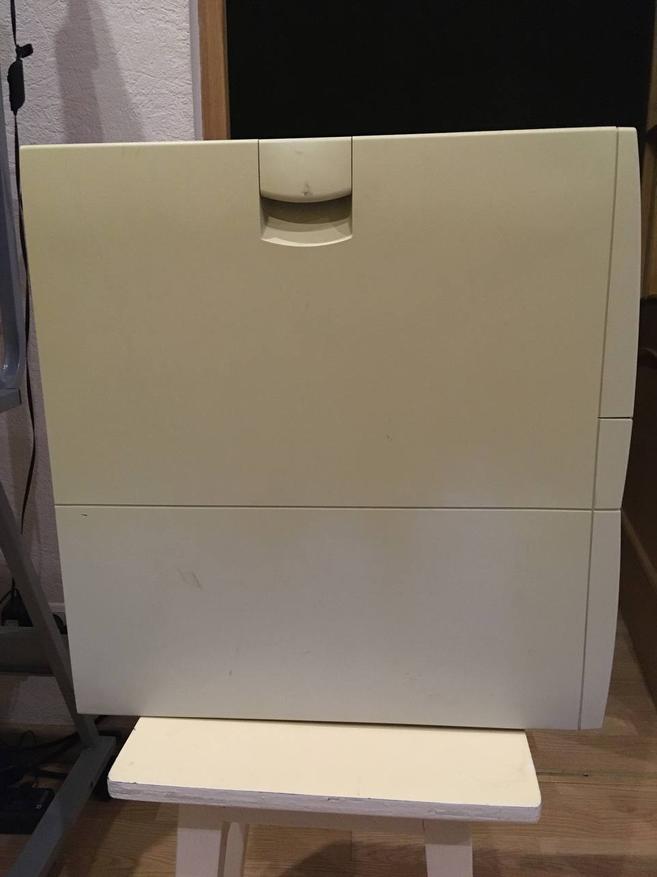

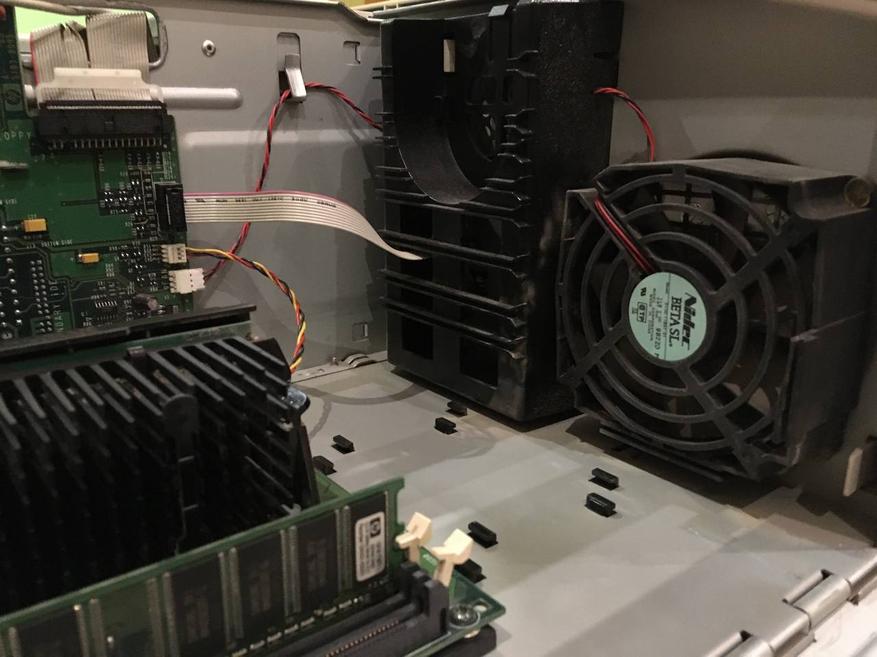

Так что теперь предлагаю развёрнуто сравнить в лоб две легенды 1998 года — 3Dfx Voodoo 2 12Mb и Matrox G200 8Mb, используя финальные драйверы для обеих видеокарт. Для Voodoo 2 это будут 3.02.02 от 27 января 2000 года, а для G200 — 6.82.016 от 27 февраля 2002 года. Естественно тестировать мы это всё будем под управлением Windows 98 SE. А тестовым стендом нам будет служить системник «белой сборки» HP Vectra VLi8, имеющий на борту распаянный Matrox G200 на 8Mb, а также процессор Intel Pentium III 500MHz и 512Mb оперативной памяти.

Ценник на данный системный блок в те годы был порядка 1500$ в комплектации с 8.4Gb жёстким диском и 64Mb оперативной памяти. Так что учитывая на круг у нас тут железа на 2000$, что по тем временам +/- зарплата среднего россиянина за пару лет… да и по нынешним временам сумма немалая.

Собственно, это мой основной системный блок для всяческих ретро игр и прочего баловства, на время тестирования правда пришлось установить дополнительно 2D видеокарту SiS 6125 для чистоты эксперимента, ибо Windows 98 и игры того времени не вполне корректно умеют работать с двумя 3D ускорителями в системе и нужны дополнительные костыли чтобы заставить работать игру на нужном в данный момент ускорителе.

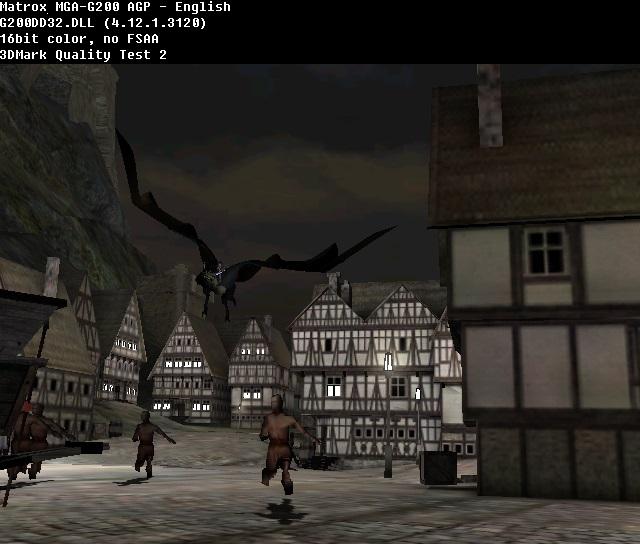

Ну давайте уже перейдём к тестам, Voodoo 2 не умеет работать с 32bit цветом в 3D, а Matrox G200 хоть и умеет, но ценой потери производительности, так что тесты в 32bit будут в ограниченном количестве. Ну, а картинки в 32bit на Matrox G200 я добавлю, для того чтобы вы сами могли решить — а надо ли оно было в те времена в играх.

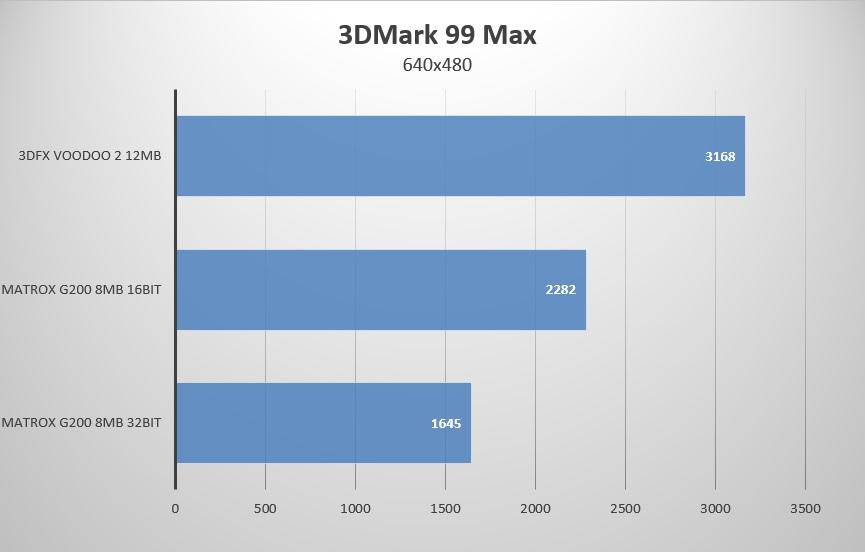

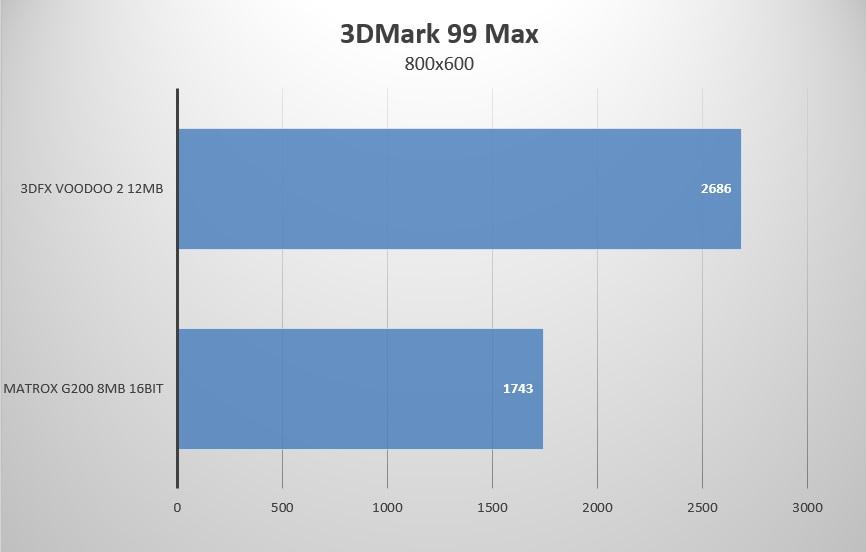

Для начала по традиции начнём с синтетики.

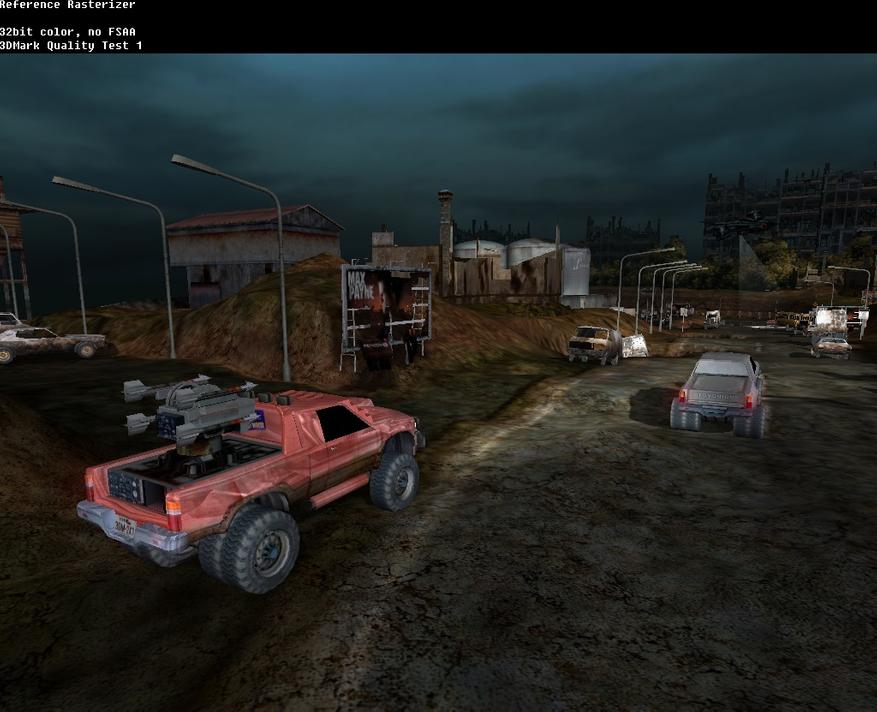

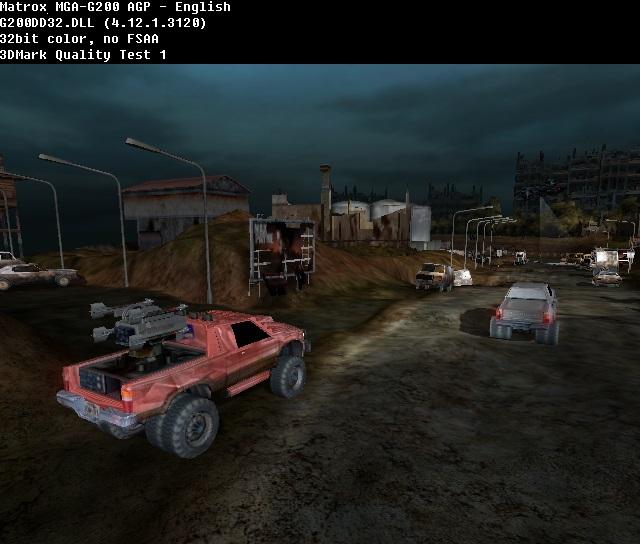

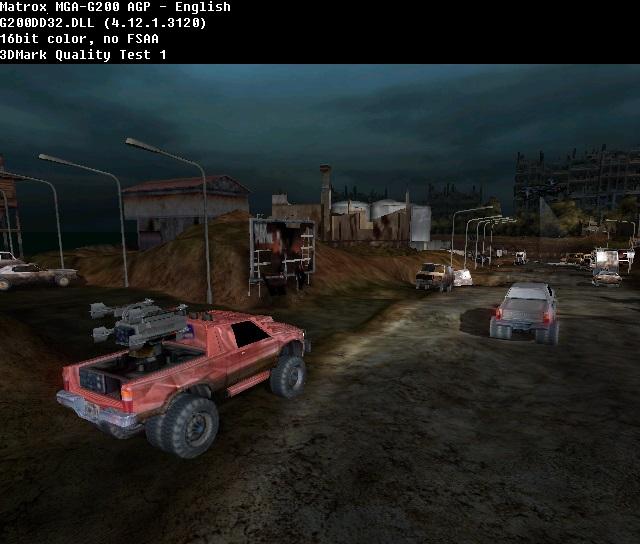

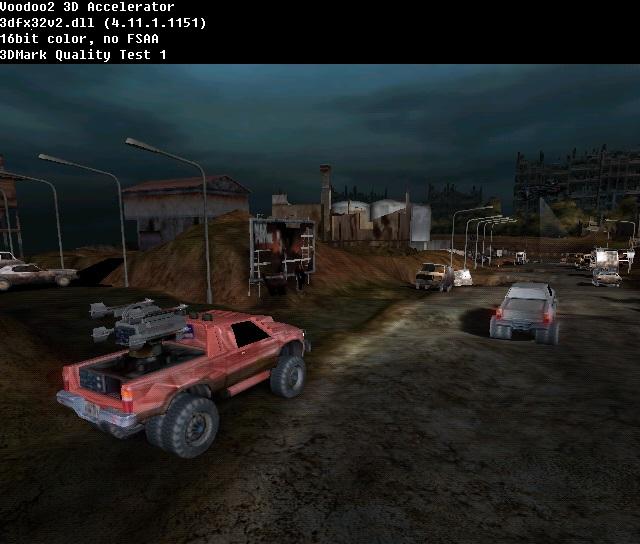

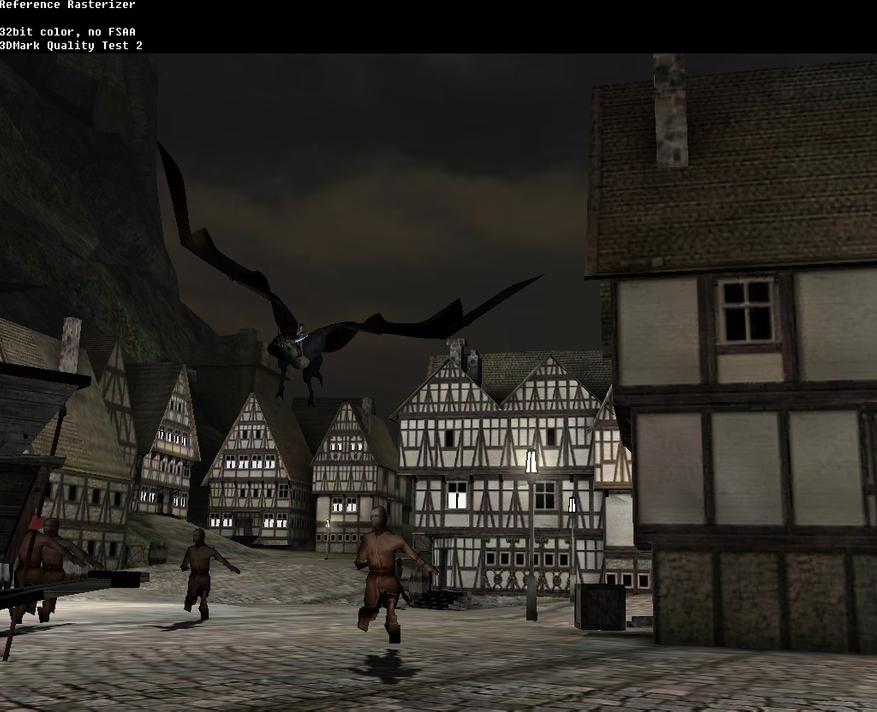

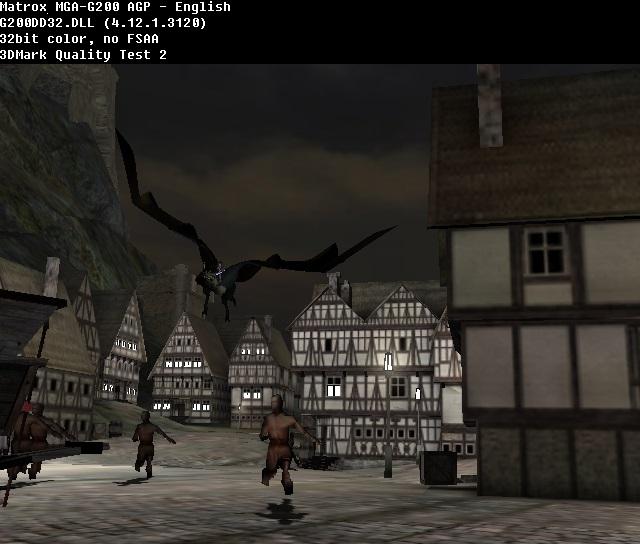

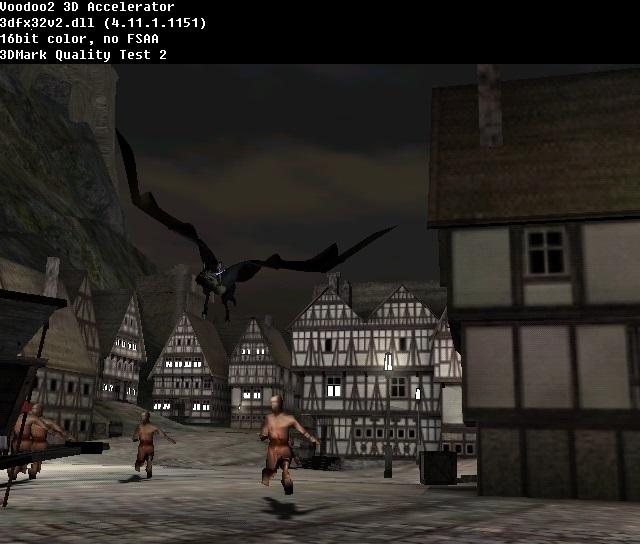

3DMark 99 Max

Matrox G200 серьёзно так отстаёт по попугаям от Voodoo 2.

К картинке обеих плат ни каких претензий у меня нет.

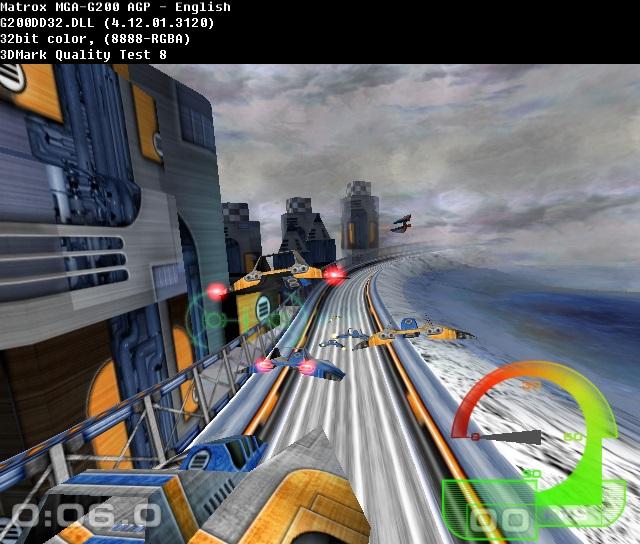

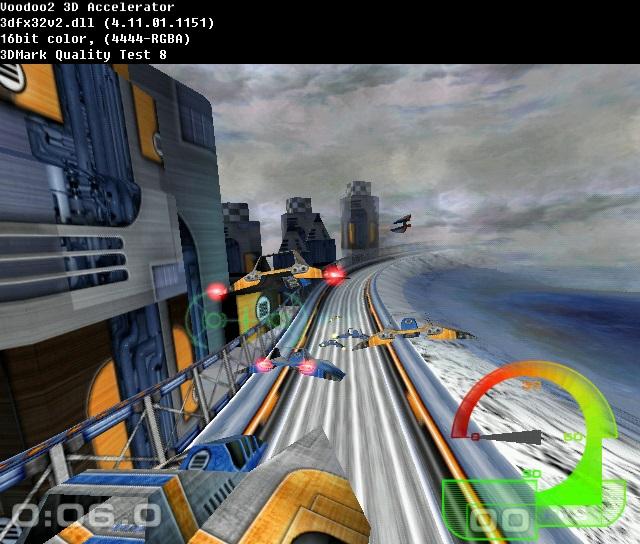

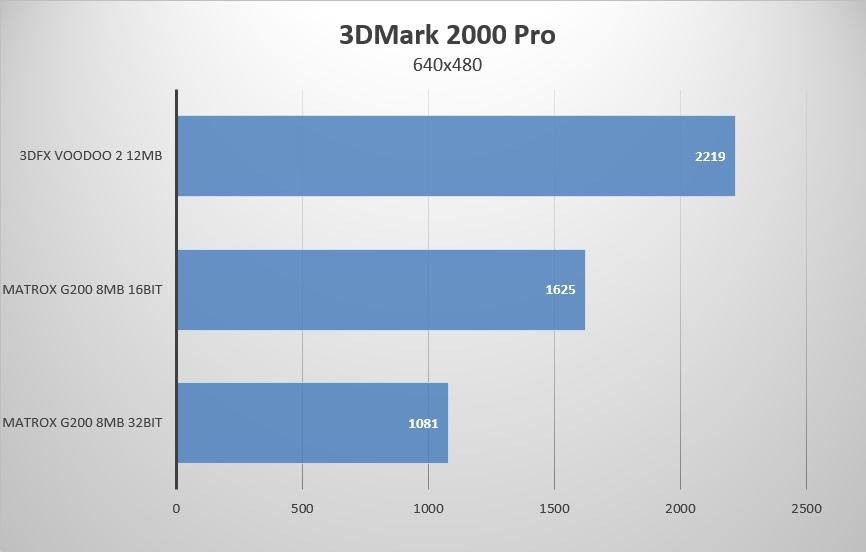

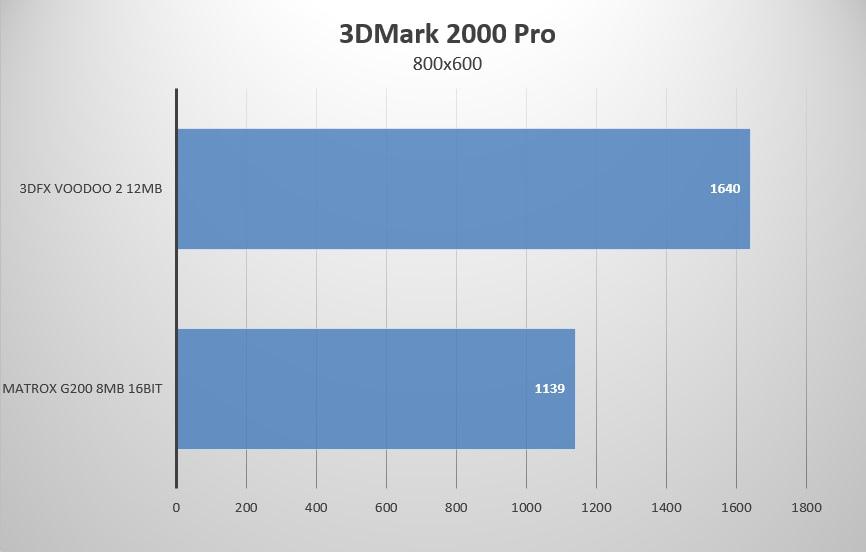

3DMark 2000 Pro

Ситуация аналогична таковой в предыдущем тесте — G200 отстаёт по попугаям и серьёзно просаживается при попытках использовать 32bit цвет для рендеринга.

И вновь претензий к качеству изображения нет никаких.

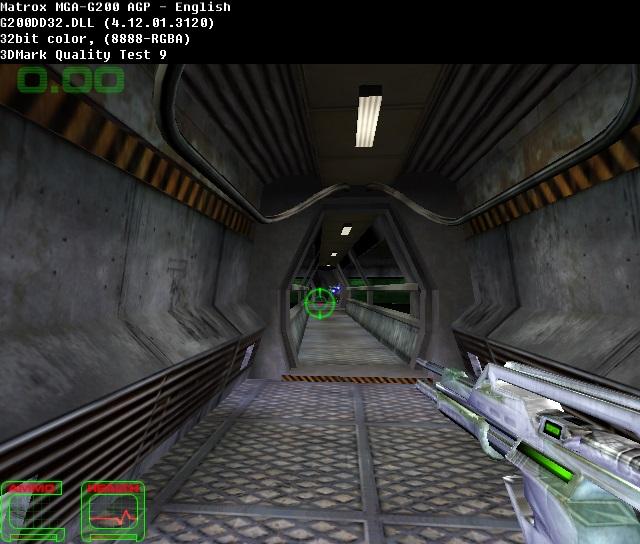

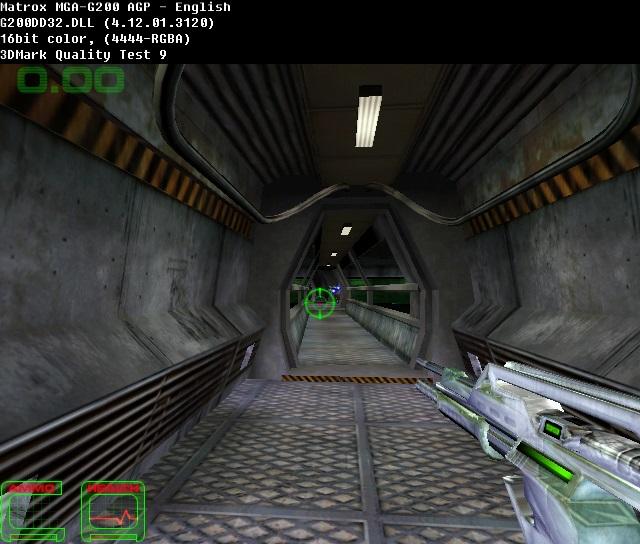

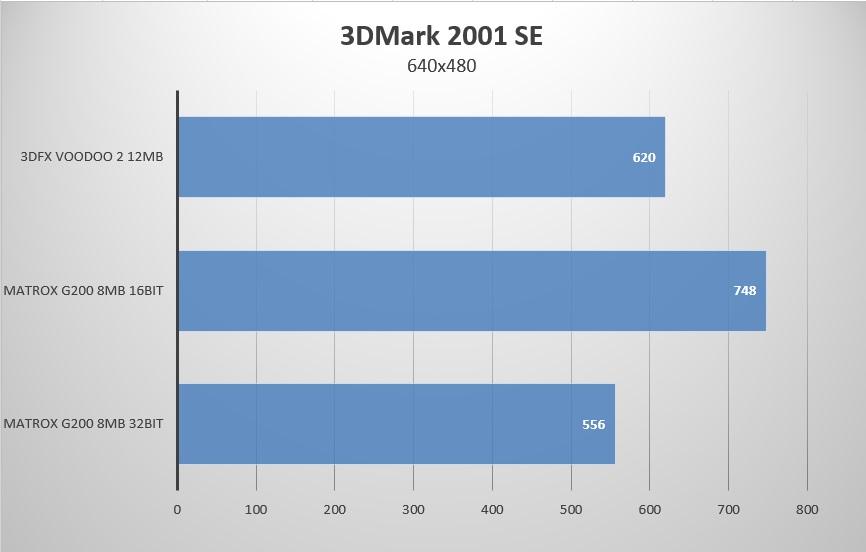

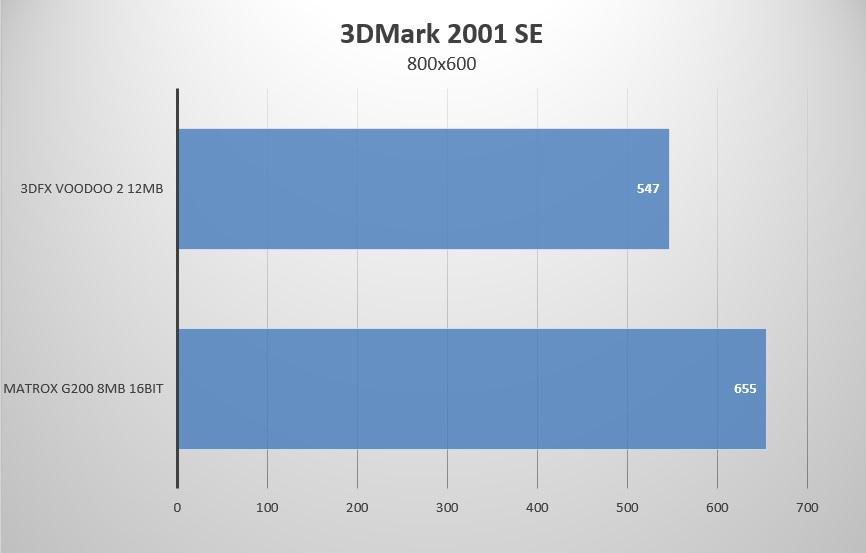

3DMark 2001 SE

А вот в 3DMark 2001 SE уже Matrox G200 вырывается вперёд, что в принципе не удивительно, ибо под Direct3D данные карты были оптимизированы лучше, да и у Voodoo 2 ко временам 3DMark 2001 SE уже давно не обновлялись драйверы в виду банкротства компании 3Dfx.

Вот тут уже Voodoo 2 даёт заметно более мыльную картинку нежели G200, который держится в этом отношении вполне бодрячком.

Ну, давайте глянем уже как дела обстояли в реальных приложениях.

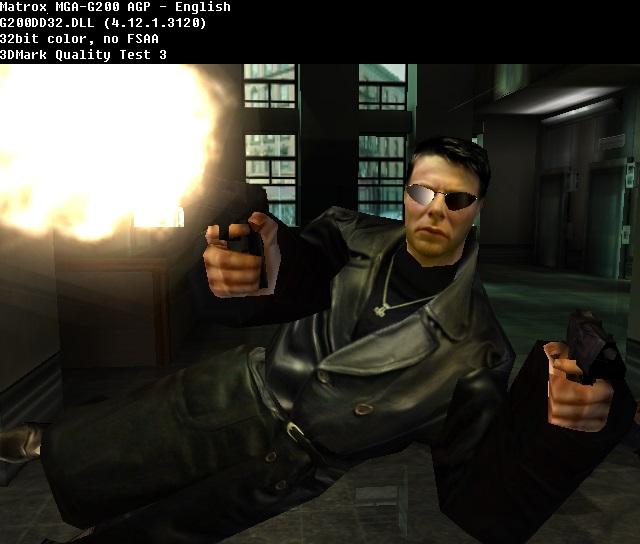

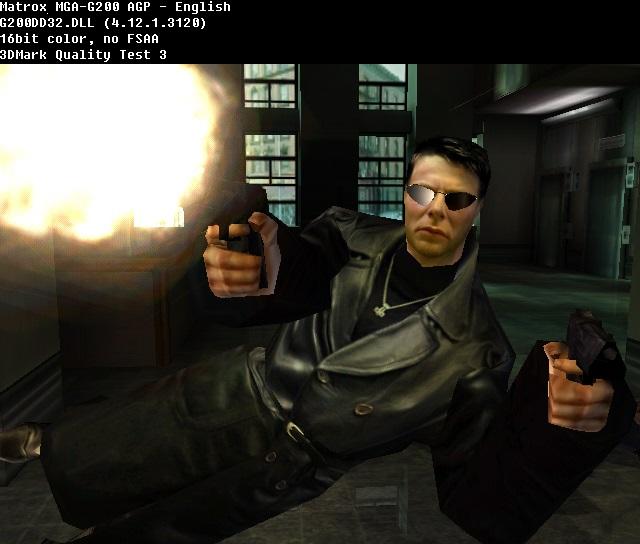

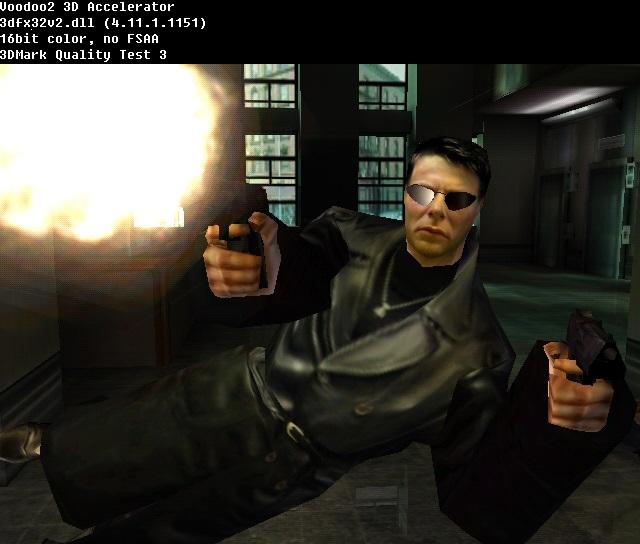

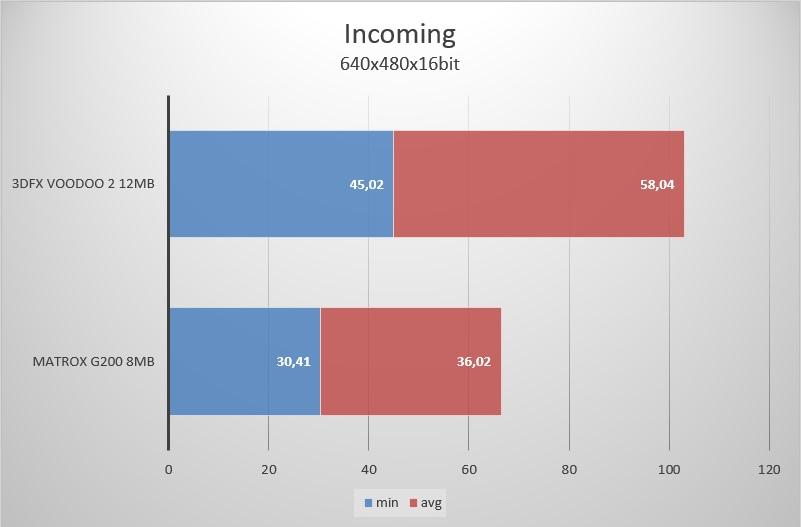

Incoming

Одна из первых игр под Direct3D, и на удивление Voodoo 2 уделывает G200 по всем статьям.

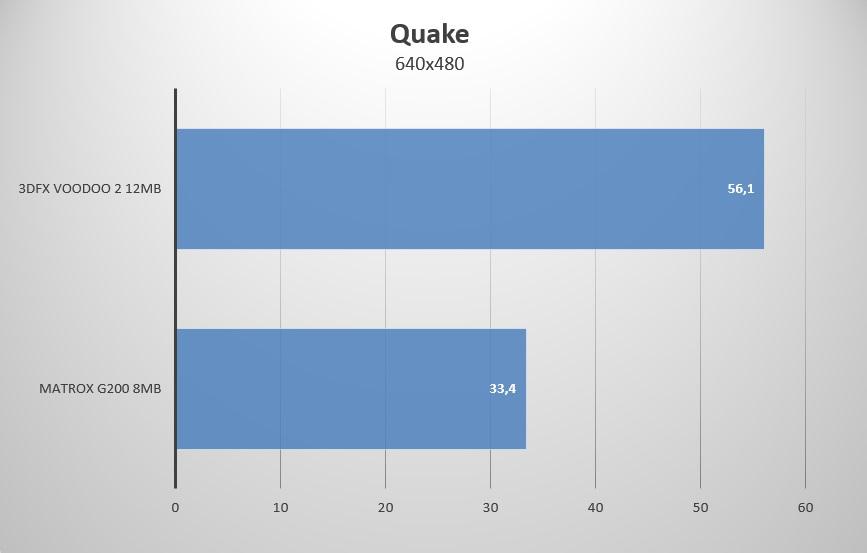

Quake

Как видим в OpenGL видеокарта Matrox G200 ничего не может противопоставить Voodoo 2.

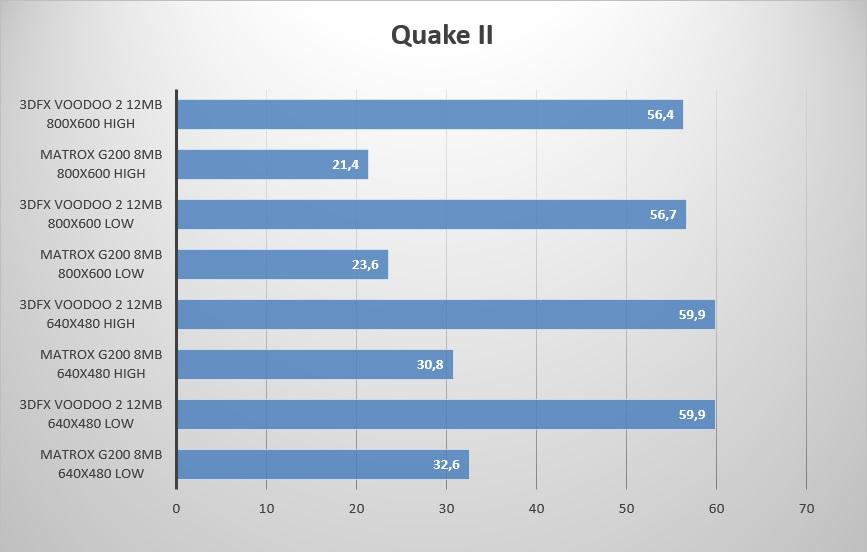

Quake II

Во всех режимах тотальное превосходство Voodoo 2.

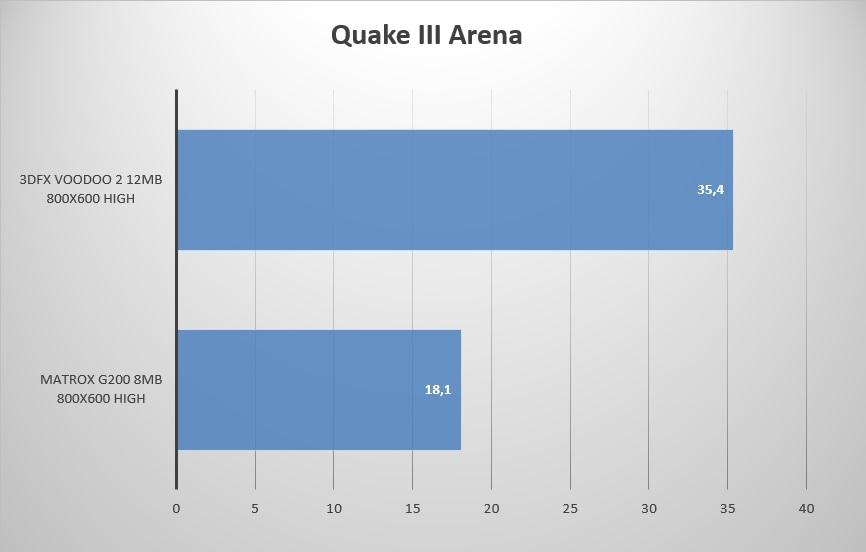

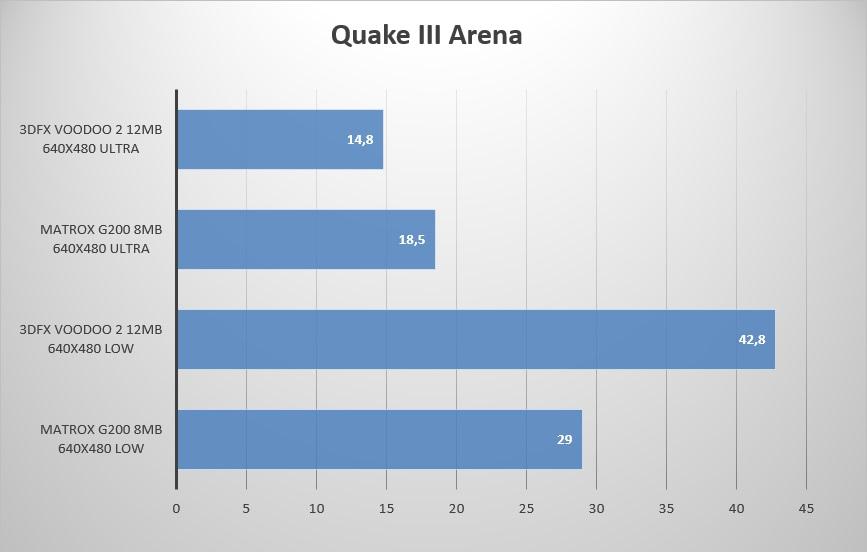

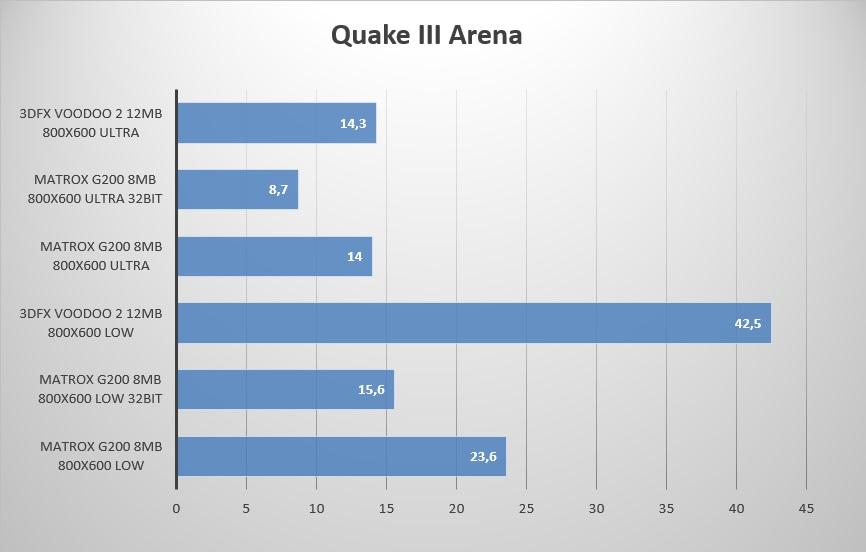

Quake III Arena

Мда, как видим в OpenGL наш «убийца» не может тягаться с Voodoo 2 ни при каких обстоятельствах, а его способность работать с 32bit цветом в 3D по факту бесполезна в играх. Voodoo 2 на Ultra настройках просадка ниже комфортного уровня, но этому есть объяснение — нехватка текстурной памяти которой у него на борту всего 8Mb. А так как он использует PCI шину, то он лишён быстрого доступа к оперативной памяти откуда можно было бы быстро подгружать текстуры как это делает G200 на шине AGP. Но вот если снизить качество текстур на один пункт с Ultra до High, то всё встаёт на свои места:

И Matrox G200 вновь проигрывает Voodoo 2.

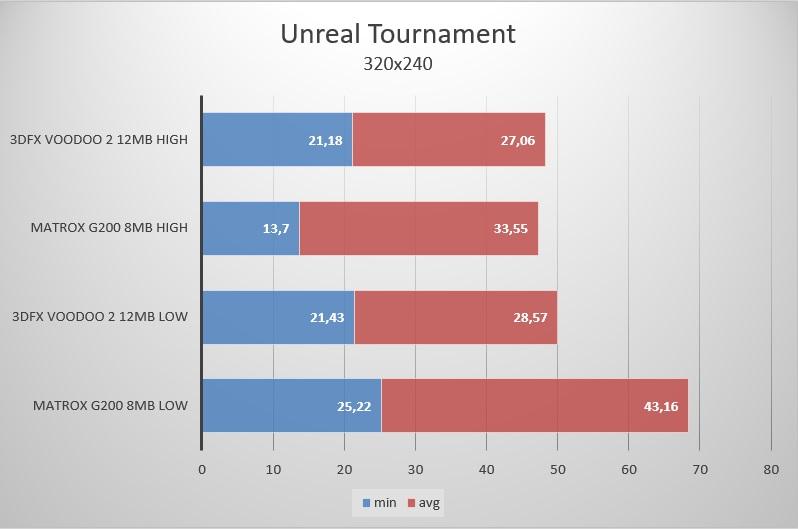

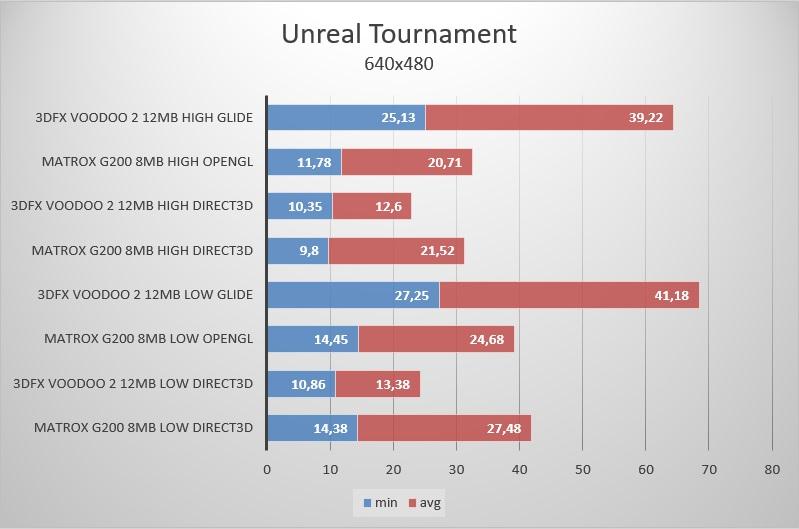

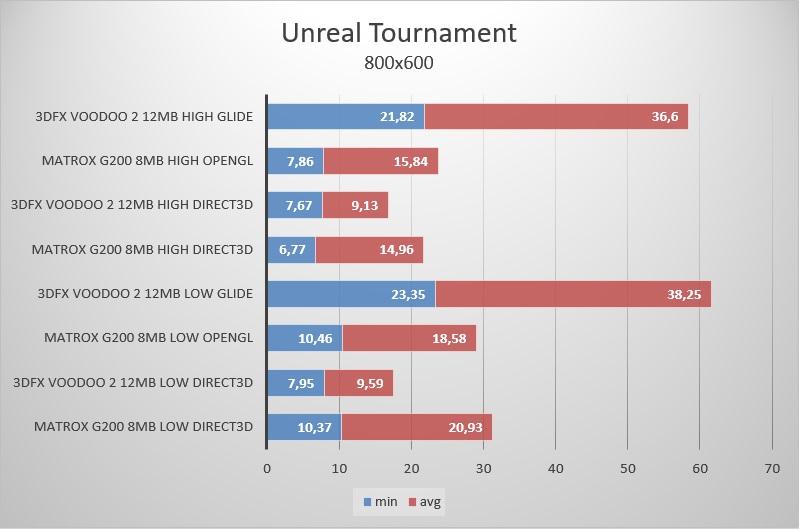

Unreal Tournament

А вот в Unreal Tournament всё не так плохо у Matrox G200, и он заметно опережает Voodoo 2 при использовании Direct3D рендера, который в своё время и разрабатывался с упором на Matrox G200. Вот только есть один нюанс… Unreal изначально разрабатывался под API Glide, так что при его использовании Voodoo 2 просто недосягаем. Ну, а с OpenGL у Matrox G200 как мы помним всё очень не очень, так что преимущества этого рендера он в полной мере реализовать не может.

Итоги

Что по итогу? По итогу мы выяснили что Matrox G200 никаким убийцей и даже конкурентом Voodoo 2 не был, да и по большому счёту не мог быть. Данная видеокарта разрабатывалась для профессионального использования, в отличии от Voodoo 2 который разрабатывался сугубо для игр. Так что если вы собирались в 1998 году работать и зарабатывать, используя персональный компьютер для работы с текстами, фото или видео, то Matrox G200 был по сути единственным вменяемым кандидатом для покупки. А вот если вы собирались играть, то вам нужен был Voodoo 2. Благо при наличии свободных финансов вы могли совместить эти два продукта в одном ПК — что люди зачастую и делали. Что-то вменяемое для профессионального использование за от прочих производителей начало появляться не ранее 2001 года.

А под конец 1998 года и у G200, и у Voodoo 2 появились серьёзные конкуренты на игровом поприще — ATi Rage 128, nVidia RivaTNT и S3 Savage3D. Увы, пока из этой троицы я раздобыл только S3 Savage3D, да и ту пока заставить стабильно работать не получилось. Да и Matrox G200 было бы неплохо найти отдельной платой, чтобы в будущем провести полноценное тестирование и устроить очередную эпичную битву за звание «убийцы» Voodoo 2.

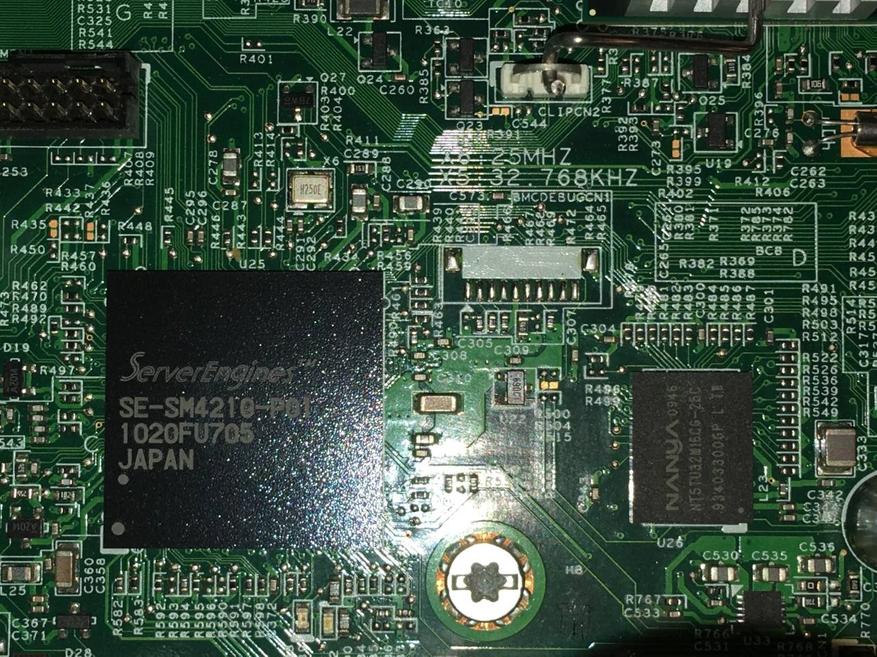

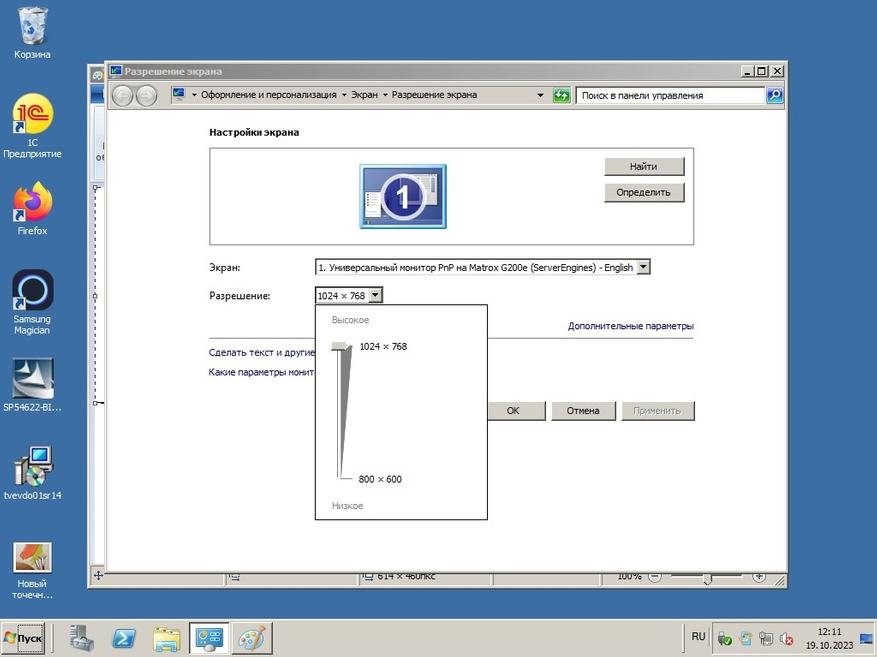

Что касается Matrox G200, у него была ещё долгая счастливая жизнь во всяческих серверах и рабочих станциях. Даже появилась спец версия Matrox G200e, которая паялась на платы всяческих серверов и вызывала лютую ненависть отсутствием при этом драйверов под Windows Server 2008. Скоро кстати у меня будет статья о таком сервере 2010 года выпуска HP ProLiant ML110 G6 из которого я буду делать игровой комп для Genshin Impact.

Апдейт: Тут меня в комментариях поправили, указали на то что драйверы под G200e под Windows Server 2008 R2 существуют. И действительно — драйвер такой есть, и даже есть драйвер под Windows 10. Собственно микросхема содержащая в себе этот G200e называется Server Engines SE-SM4210-P01 и выглядит вот так:

Но как вы можете видеть, толку от установки драйверов нет — выбор разрешений такой же, как если бы этого драйвера не было. И интерфейс точно так же продолжает тормозить, как будто никакого драйвера и нет. Но микросхема эта не только вопросами графики занимается, она нужна для удалённого управления и мониторинга работы сервера.

Ну, а на этом у меня на сегодня всё — всем пока.

36 комментариев

Добавить комментарий

Что не мешало выдать 85-100фпс при актуальном тогда разрешении 1024x768, во всяком случае, на 3DFX.

Фпс достигли частоты развертки монитора, это и был огромный прорыв.

Сейчас 4k144 далеко не везде достигается при отведении полкиловатта мощности!

Ну и как видим даже в 800х600 оно 60 фпс показывает с трудом и не везде.

30 фпс для GPU тех лет было очень хорошо, ну а отсутствие радиаторов в больше мере диктуется стремлением вписать видеокарту в существующие тогда стандарты — одна плата = один слот, до двуслотовых видеокарт ещё очень не скоро додумались. Вплоть до времён 9800GT референсные карты за каким-то чёртом делали однослотовыми, хотя всем уже было понятно — что охлаждения недостаточно. Так что это инерция мышления и банальная экономия.

Никакого дополнительного охлаждения не было и блок питания был китайский ноунейм.

Но Matrox был какой-то не рабочий и дорогой вариант, 3D не осилили.

А там 3DFX начал городить Voodoo4/5, на чем и закончился.

А Voodoo 4/5 это уже 2000 год и совсем другая история… Voodoo 2 был высшей точкой после которой 3Dfx покатилась к неминуемому банкротству.

Что касается игр, то рабочим разрешением до середины 00х было 800х600 в лучшем случае и на «стекле» оно выглядело вполне приемлемо — так что не удивительно что производители видеокарт особо не запаривались. Ну а «Voodoo или Intel для CAD» эт из разряда анекдотов — ни кому бы и в голову такое не пришло даже подумать о таком, и уж тем более их разработчикам.

У автора просто не завалялось подходящего 20" CRT Viewsonic ))

https://www.tomshardware.com/reviews/3d-accelerator-card-reviews,42-6.html

p.s. было очень забавно, когда я в конце 90-х годов написал письмо в Diamond о том, что при игре в Quake на этой карте есть проблемы с текстурами. и через неделю (!) вышел новый драйвер, который пофиксил эту проблему :-)

и 2D был почти как у матрокса.

но через пару лет все же заменил на Matrox G400, когда осилил купить Sony GDM-200PS

нормальные компы для меня начались с P100, S3Trio, моник LG 14"

на дальнейшие графические прибамбасы заработал уже сам. но на нормальные игровые видюхи всегда было жалко денег. монитор был для меня приоритетом.

Сейчас, по прошествии времени, имея в хозяйстве Voodoo 2, я бы не сказал, что это прям уж какая-то выдающаяся карта, есть всего пара десятков игр, которые на ней действительно выглядят лучше чем на прочих 3D картах. Думаю в те времена вся эта «магия» Voodoo была во многом связана с качественными и стабильным софтом, нежели с какой-то особой уникальностью самих этих карт.

И действительно — работает, не знаю правда на кой оно мне на серверах надо — но пусть будет.

И окна как тормозили, так и тормозят.

А проблемы увы были и в Quake 2, и в Unreal как минимум до конца 1998 года.

Для Quake 2 вышедшей в декабре 1997 года, не было у Matrox G200 драйвера с поддержкой OpenGL и вышел таковой только в декабре 1998 года, т.е. целый года с момента релиза игры на видеокартах от Matrox нельзя было играть в него с аппаратным ускорением, хотя нет вру… был у Matrox отдельный ускоритель OpenGL — Matrox m3D на базе чипа NEC/PowerVR PCX2 ценой в 100-200$ эт к вопросу о бесящих 3D ускорителях без 2D составляющей.

Ну, а что касается Unreal вышедшего в мае 1998 года, то там вообще на старте аппаратное ускорение было доступно только для Glide, т.е. только на Voodoo. А Direct3D рендер появился лишь в октябре 1998 года, да и то в альфа версии. Альфа OpenGL там появилась чуть раньше в сентябре 1998, но как мы помним для него у G200 не было соответствующей поддержки со стороны драйверов.

Но благо в обеих этих играх можно было наслаждаться Software рендерингом вообще без этих всех богомерзких 3D ускорений. )))

Сам я до таких дебрей программирования под DOS не дорос, тогда лет было мало, а потом уже окна во всю были и потребности не было.

P.S. Совпадение или нет. Я недавно возился с сервером Intel S1200BT. И вы не поверите, какая там стоит встроенная видеокарта. https://www.rsmanuals.com/71053/intel-s1200bt/page-15/ Некий ServerEngines LLC Pilot III BMC, который в Linux определяется именно как Matrox G200. Тормозит жутко, если честно.

Увы, знаний у меня недостаточно для того чтобы её вполне понять, но явно умное что-то написано. )))

А вот с этим ServerEngines я как раз сейчас развлекаюсь, если что дополню статью, оказывается под него драйверы есть аж под Windows 10.

У меня вот всё это железо лежало лет 15, всё не до того было… а недавно плюнул на всё и вот тестирую — пишу статьи.

Весело.

Добавить комментарий