Обычно сравнения большого количества разнообразных видеокарт у нас на сайте выходят в полюбившемся многим формате ежемесячных «3DiТогов», но его основной задачей является изучение актуальных предложений обоих производителей дискретных GPU. В то же время иногда возникает задача оценить что-нибудь совсем старенькое (но сохранившееся у пользователя), дабы понять, нужно ли ему «новенькое», и какое. Фактически, для этого нужны специальные материалы, выпускать которые крайне сложно, поскольку далеко не всегда устаревшие карты оказываются доступными тестовой лаборатории. В результате читателям приходится открывать несколько статей и вести поэтапное сравнение за длительный исторический период. Но нам сегодня в какой-то степени «повезло», поскольку «под рукой» нашлось два видеоадаптера AMD образца пятилетней давности, что вызвало нестерпимое желание протестировать их в более-менее современном игровом окружении. И не только их, благо наш «процессорный» подход и сам по себе немного отличается от традиционного «видеокарточного», что может оказаться достаточно полезно. На полноту охвата темы мы, безусловно, не претендуем, поскольку видеокарт не так уж много, и часть из них не слишком отличается друг от друга. Но некоторые вопросы, часто остающиеся за кадром, попробуем осветить :)

Объекты тестирования

Главное, из-за чего все затевалось — появление в зоне досягаемости «свободного» Radeon HD 5870, топового решения образца второй половины 2009 года. Почему именно эта видеокарта вызвала у нас не только ностальгию, но и желание протестировать ее сейчас? Дело в том, что именно такой видеоадаптер применялся во всех тестах центральных процессоров по методике версии 4.5, которой мы пользовались более года и протестировали 64 конфигурации. «Вспомнить всё» всегда интересно, что и стало причиной номер один. Под номером два — то, что в момент анонса Radeon R7 260X, активно использовавшегося нами в прошлом году, AMD сравнивала бюджетную новинку именно с этим «мощным стариканом»:

Тогда мы проверять данное утверждение не стали, поскольку не имели такой возможности, а сейчас она появилась. Интересно же. Благо и R7 260Х, изрядно подешевев, продолжает представлять собой интерес. Пользуясь случаем, заодно поговорим о масштабных переименованиях чипов и готовых решений.

Итак, R7 260X, представленный осенью 2013 года, представлял собой почти полную копию Radeon HD 7790, появившегося на полгода ранее, но дешевле, несмотря на 2 ГБ памяти вместо 1 ГБ. Чуть позднее был проведен и ребрендинг HD 7770, аналог которого начал продаваться под названием R7 250Х, а между этими двумя решениями встроился «промежуточный» R7 260. Изначально — на том же GPU, что и HD 7790/R7 260Х, но часть конвееров была заблокирована, а вот при «рестайлинге» чипа (Tobago вместо Bonair) они, похоже, «исчезли» физически. В итоге при переходе от «двухсотого» к «трехсотому» семейству младшим решением стал Radeon R7 360, аналогичный R7 260, а непосредственной замены R7 260Х не нашлось. Некоторые партнеры AMD продолжили выпуск формально устаревшего R7 260Х, благо он хорошо встраивается между R7 360 и R7 370. Разумеется, делать это можно было лишь до физического исчерпания чипов Bonair, которое уже, похоже, случилось, но карты пока в продаже встречаются.

Стоит отметить, что переименования, которыми грешит не только AMD, но и Nvidia, далеко не изобретение каких-то последних лет. В частности, в сегодняшнем тестировании участие примет еще и Radeon HD 6770, на деле представляющий собой переименованный HD 5770. Впрочем, в отличие от вышеописанного HD 5870, эти карты уже тогда относились к (почти) бюджетным решениям, но и это тоже интересно — посмотреть, на что они способны спустя пять лет.

Впрочем, никаких чудес мы, конечно, не ожидали изначально. Что HD 6770 в свое время, что R7 260Х сейчас (да и год-два назад) — это вовсе не выбор серьезного геймера. Поэтому мы взяли для сравнения еще и три видеокарты более высокого уровня: R9 280, R9 380 и некогда топовый двухпроцессорный R9 295X2. Последний сейчас устарел морально вследствие появления семейства Fury, так что из «3DiТогов» он вылетел, однако почему бы не протестировать его разово? Благо прошлым летом мы этим занимались как раз по тогдашней «процессорной» методике. Тогда же обнаружилось, что во многих играх технология CrossFire не работает вовсе, поэтому интересно посмотреть, что изменилось за прошедшее время. Ведь сколько бы ни говорилось о недостатках любых технологий multi-GPU, некоторые пользователи до сих пор рассматривают их как потенциально интересные — если и не сразу, то при модернизации системы (т. е. предполагая не менять видеокарту, а добавить к ней со временем такую же).

R7 260X и R9 280 в упомянутом тестировании участие тоже принимали, R9 380 — продукт для нас немного новый, но, возможно, будет регулярно использоваться в ближайшее время. Принципиально же нового в нем ничего нет — несмотря на формальную принадлежность к 300-му семейству, фактически это R9 285. Но вот к 200-й серии его отнести можно — в отличие от R9 280, изначально дебютировавшего «на арене» под названием Radeon HD 7950 (равно как и R9 280Х, изначально именовавшийся HD 7970). Правда, «обновления» идут на пользу не всем: чип Tonga (применяемый в R9 285/380/380Х) по вычислительным возможностям аналогичен Tahiti (HD 7950/R9 280/HD 7970/R9 280Х), а вот шина памяти в нем урезана в полтора раза — 256 бит против 384. Причины понятны: так дешевле, благо на топовые позиции новые карты уже не претендуют, в то время как HD 7970 (вместе с двухпроцессорным HD 7990) когда-то были флагманами AMD. А как это все сказывается на производительности — посмотрим. В принципе, повторимся, в рамках «видеотестов» это было сделано уже не раз, однако информация лишней не бывает — раз уж есть возможность ее быстро получить.

Драйверы и прочие вопросы поддержки

Поскольку в творчестве AMD сейчас «много ремиксов» (как было показано выше), компания придерживается достаточно логичного, но не самого приятного для пользователей слишком старой продукции подхода: все GPU на базе архитектуры GCN считаются актуальными, а все остальные оптом занесены в устаревшие (независимо от функциональности, производительности и прочего). Для актуальных продуктов драйверы обновляются регулярно, поэтому карты семейств Radeon R7 и R9 мы тестировали с Crimson Edition 16.4.1 Hotfix от 4 апреля этого года, а вот последний официальный драйвер для предыдущих поколений относится к лету прошлого года. С другой стороны, тем, кто не испытывает страха перед бета-версиями, сообщаем, что мартовский Crimson Edition 16.2.1 Beta с Radeon HD 5xxx полностью совместим. Вот его мы и использовали. В принципе, разброс версий оказался невелик, но со временем он будет расти.

Конфигурация тестового стенда и методика тестирования

Для тестирования мы воспользовались системой на базе процессора Core i3-6320 с 16 ГБ памяти типа DDR4, работающей под управлением Windows 10 x64. Методика же, в общем и целом, та же, что и для тестирования процессоров. Она подробно описана в отдельной статье; здесь же отметим, что в основном мы использовали тесты из методики измерения производительности в играх iXBT.com образца 2016 года, с которой также можно ознакомиться по ссылке. Но использовали мы не только их, и с дополнения и начнем, упомянув лишь, что все результаты доступны не только на диаграммах (там как раз не все), но и в виде традиционной таблицы в формате Microsoft Excel.

Энергопотребление и влияние на производительность приложений общего назначения

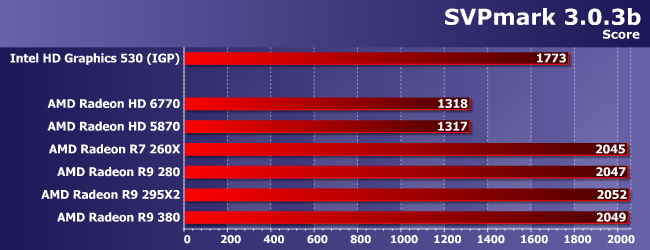

Как показали наши предварительные тестирования, даже если не учитывать потребление дискретных видеокарт по «выделенному» проводу, «питаются» они далеко не святым духом, увеличивая и общее энергопотребление платформы. Максимальным же оно оказалось во время выполнения теста в SVPmark, который наиболее активно из используемых нами задействует GPU. При этом дискретная видеокарта, несмотря на негативное влияние на энергопотребление по сравнению с интегрированным GPU, несколько увеличивает производительность в данном приложении.

Но все эти результаты мы получили с Radeon R7 260X. А что изменится, если использовать более мощные видеокарты того же поколения или старые видеоадаптеры? Проверим. Начнем с производительности.

До того, как мы начали использовать SVPMark в тестах, нам неоднократно предлагалось это сделать на основании того, что, дескать, это приложение «активно использует GPU». Однако по результатам хорошо видно, что к GPGPU это «использование» отношения не имеет: карты разной 3D-производительности показывают одинаковые результаты. А «сортируются» они по производительности и функциональности отдельного блока, как раз предназначенного для декодирования (в современных чипах — и кодирования) видеопотоков. Разумеется, в программном режиме эти операции выполняются очень медленно, так что «использование GPU» для программы актуально. Но это не использование для вычислений. Поэтому нет ничего странного в том, что интегрированный в процессор графический контроллер с легкостью обгоняет более мощные, но старые видеокарты — такой там был декодер (отметим, что в эпоху «до GCN» он был действительно исключительно декодером). Используй мы более высокое разрешение, вполне возможно, что и относительно современные дискретные видеокарты остались бы позади — вопрос, повторимся, в функциональности и производительности именно блока обработки видео, а не количества и мощности «графических процессоров».

Но независимо от того, увеличивается производительность или даже снижается, энергии, как видите, нужно больше. И это даже если предположить, что по выделенным линиям она не поступает (не потребляется), что точно не выполняется: R9 295Х2, к примеру, будучи подключенной к БП одним кабелем, этот тест пройти не может. В общем-то, именно с разным подходом к распределению питания «по каналам поставки» связаны и разные результаты видеокарт в этом тесте. Главное же, что следует помнить: даже через слот на системной плате при использовании дискретной видеокарты поступает от 10 до 40 Вт электроэнергии, что вполне сравнимо с полным потреблением системы на базе Core i3-6320. Поэтому комплектация компьютера видеокартой по принципу «а вдруг пригодится» разумной не является. В современных условиях дискретная видеокарта оправдана только тогда, когда без нее обойтись невозможно. Например, в игровом компьютере.

Игры: высокое разрешение при минимальном качестве

Для экономии места и времени мы решили не выносить подробные результаты на диаграммы — желающие ознакомиться с ними могут сделать это, скачав полную таблицу. Понятно, что все видеокарты работают по-разному, но даже для средних современных решений такой режим оказывается слишком легким. А главное — абсолютно все участники тестирования, включая Radeon HD 6770 (который, напомним, на самом деле HD 5770, т. е. на рынок вышел еще в конце 2009 года), во всех 13 играх в таком режиме демонстрируют частоту кадров выше 30 FPS. Почему это главное? Потому что никакая современная интегрированная графика на такое неспособна даже в подобном «щадящем» режиме! Лучшее из протестированных решений Intel «осилило» 12 игр из 13, а AMD — всего 9. Возможно, процессоры семейства Skylake с GPU серии GT4e и повторят сей «подвиг», но их пока нет. А Radeon HD 6770, напомним, есть уже больше шести лет :) Собственно, это исчерпывающий ответ на вопрос, может ли интегрированная графика полноценно заменить геймеру дискретную. В ближайшее время — нет, поскольку даже с минимальным качеством такая вот ситуация. Но ведь в первую очередь интересует далеко не оно.

Игры: максимальное качество в двух разрешениях

Для HD 6770 из уважения к его сединам мы ограничились одним разрешением: хорошо уже, что с Full HD он справился хотя бы «на минималках» — на большее никто и не рассчитывал. Это подтверждают и «танчики», зачастую считающиеся эталоном нетребовательности к видеосистеме: в режиме максимального качества эта видеокарта даже в HD демонстрирует не такую уж высокую частоту кадров. На остальных же испытуемых можно использовать и «полное» разрешение, причем с уровня R9 280 — уже с солидным запасом производительности. R9 295Х2 же, как и предполагалось, «вырождается» здесь в аналог R9 290Х, что тоже неплохо: остальные карты еще слабее.

Для этой игры видеокарты выше R9 280 тоже не требуются, если ограничиться Full HD. В HD же отличные результаты демонстрирует и бюджетный R7 260X, и древний HD 5870. Вот если видеокарта одновременно древняя и бюджетная, то все куда хуже. В чем никто и не сомневался.

CrossFire (как и ранее) здесь не работает, только снижая производительность. Но вообще игра (и движок) уже настолько старые, что производительность карт уровня HD 5870/R7 260Х можно считать нормальной уже и в Full HD. Больше — не требуется. Меньше — может оказаться маловато.

Более новая модификация того же движка EGO, как видим, отдает однозначное предпочтение новым видеокартам: если в предыдущих играх HD 5870 еще можно было как-то сравнивать с R7 260Х (подтверждая тем самым версию производителя), то в новых проектах они могут оказаться вовсе несопоставимы. Может, просто потому, что 1 ГБ памяти уже мало, а может, и архитектурные оптимизации сказываются. CrossFire так и не заработал, R9 280 и выше — достаточно.

Полный разгром «пожилых» решений: даже HD 5870 «не вытянул» HD-разрешение, в то время как R7 260Х в нем почти достаточно. R9 280 не в первый раз в принципе хватает для FHD, но все-таки для данной игры желательно «заполучить» что-то более мощное. Отлично работает CrossFire — правда, в данном случае маловато становится уже процессора, что хорошо заметно по близости результатов в двух разрешения на R9 295Х2. В общем, до сих пор довольно «тяжелая» игра. Но в первую очередь она «тяжелая» для видиосистемы: хорошо заметно, что прочие факторы можно начинать учитывать лишь тогда, когда частота кадров уходит за 60 FPS. А если нет видеокарты, способной обеспечить подобное, то можно не напрягаться. Впрочем, не напрягаться можно, пожалуй, в любом случае: ведь искомый уровень могут обеспечить только карты за несколько десятков тысяч рублей (в нынешних ценах), а на этом фоне как-то странно экономить 5-10 тысяч на процессоре :)

Движок этой игры изначально появился еще 10 лет назад, но позднее был существенно переработан, обзаведшись полной поддержкой DX11 и прочего. Однако несложно заметить, что требования к видеосистеме тут далеко не запредельные: Metro: LL вышла, к примеру, на полтора года раньше, однако в этом плане выглядит серьезнее. Собственно, это обычное дело: никакого линейного непрерывного роста «тяжеловесности» игровых проектов не наблюдается, так что на один монструозный старый проект всегда найдется пяток «легковесных» новых. Но в среднем требования к оборудованию постепенно растут, так что флагманы былых времен ныне зачастую не позволяют играть даже в не самые требовательные игры с приемлемым уровнем качества. Впрочем, здесь мы в очередной раз видим, что R9 280 (и аналогичных решений) вполне достаточно для использования «полного» разрешения Full HD. Также в очередной раз видим, что CrossFire только мешает :)

Несмотря на то, что эта игра вышла еще в 2012 году, для недорогих видеокарт она до сих пор является «крепким орешком», а вот уровень R9 280 и здесь вполне «совместим с жизнью». Неожиданно, на R9 295Х2 игра вообще не заработала, хотя в прошлом году проблем с ней мы не испытывали. Возможно, сейчас они вызваны свежей версией драйвера, где как раз было обещано улучшение работы CrossFire именно в этой игре. Дотвикались, «починив» то, что и так работало :)

Здесь проблемы с функционированием multi-GPU никуда не исчезли, однако для этой игры в принципе достаточно видеокарты среднего уровня. Отметим, что для интегрированной графики Thief является «камнем преткновения» даже при настройках на минимальное качество. Бюджетная же дискретка позволяет использовать максимальное — пусть и при сниженном разрешении. То есть эти классы оборудования пока вообще можно считать непересекающимися.

Как мы уже не раз отмечали, данная версия Tomb Raider весьма «щадяща» к видеосистеме в режиме минимального качества, но очень требовательна в максимальном. Ну как «очень» — в принципе, на том же уровне, что и некоторые другие виденные выше проекты. При этом производительность зависит фактически только от видео, что заодно дает просто идеальную масштабируемость, в том числе и в режиме multi-GPU: два R9 290Х (5632 ALU) здесь в три раза быстрее, чем R9 280 (1792 ALU). Старые же или бюджетные решения хвалить особо не за что.

В принципе, ничего нового, кроме пополнения в рядах игр, с которыми нормально совместим CrossFire — как видим, встречается это мягко говоря куда реже, чем хотелось бы. А когда встречается, иногда начинают влиять другие компоненты системы, так что производительность в таком режиме все равно оказывается ниже потенциальной.

Но уж Sniper Elite V2, подобно Tomb Raider, демонстрирует идеальную масштабируемость по видео. Это более важно, чем в предыдущих случаях, поскольку, как видим, тут не повредит более мощная видеокарта, нежели одиночный R9 280.

|

|

Эти две игры используют один и тот же графический движок UE3 (первая игра на котором вышла еще в 2006 году, а последняя на данный момент — в феврале текущего; причем планируются и другие игры), да и вышли в одном году. Несмотря на то, что это был 2013 год, обе до сих пор остаются популярными, но во многом из-за не слишком высоких требований к компьютеру. Примечательно же здесь то, что эти игры совершенно по-разному относятся к CrossFire: в Bioshock эта технология работает хорошо, а в Batman — практически никак. Но требования обеих, повторимся, невысокие, так что в принципе для них хватает и не самых мощных устаревших видеокарт.

Итого

Какие общие выводы мы можем сделать на основании всего вышесказанного? Их несколько. Как видим, на данный момент сохраняется принципиальная разница между производительностью интегрированных и дискретных графических адаптеров: среднее решение шестилетней давности способно на то, чего не может ни один интегрированный GPU — «справиться» хотя бы со всеми играми нашего набора хотя бы в режиме минимального качества при разрешении Full HD. Понятно, что и сейчас продолжают продаваться дискретные видеокарты с более низкой производительностью, а раньше их было еще больше, так что заменить их интегрированным видео вполне возможно. Однако в этом нет смысла :) По сути, если 3D-игры рассматриваются как одна из приоритетных задач при покупке компьютера, то дискретная карта обязательна. Карта нормального уровня. И современная. Фактически, приходим к тому, что дискретный видеоадаптер нужно не только покупать, но и регулярно менять: если процессоры пяти-шестилетней давности еще можно как-то использовать (а иногда и без негативных эмоций), то даже самые мощные видеокарты того времени сейчас выглядят слишком бледно. Дело в том, что в большинстве приложений общего назначения, как правило, нет «границы комфорта», так что двукратная разница в производительности — это просто двукратная разница в производительности (процесс, который длится час или два — это все равно «длительный процесс», а секунду или две — «почти мгновенный»). В играх же максимальная нагрузка приходится именно на видеокарту, и лишь потом на процессор, так что, модернизируя игровой компьютер, первым делом надо менять именно видеокарту, а потом уже проверять, не пора ли задуматься о прочих компонентах.

Причем видеокарту нужно именно менять, в чем мы в очередной раз убедились: идея добавить еще одну аналогичную разбивается о то, что игр, нормальным образом не поддерживающих работу в режиме multi-GPU, вагон и маленькая тележка, и меньше их не становится. Это не слишком мешает покупке топовых двухпроцессорных ускорителей (либо установке двух топовых на момент покупки видеокарт), если хочется получить максимальные результаты «здесь и сейчас», поскольку в худшем случае тут и «половинка» конфигурации будет работать как топовая карта. А вот на идее применить пару устаревших видеокарт это ставит крест: их лучше поменять на одну современную, даже если вариант с multi-GPU будет выглядеть привлекательным по цене. В принципе, ничего нового в этой проблеме нет, но лишний раз ее озвучить не мешает.

Как не мешает озвучить и то, что требования игр к аппаратному обеспечению растут вовсе не линейно, т. е. задача «играть во все свежие игры» вовсе не равноценна задаче «играть в самые тяжелые игры последнего десятилетия». Точно так же «старая игра» вовсе не синоним «легкой». Это не отменяет постоянного роста аппаратных требований «в среднем» — но за счет именно штучных приложений, делать которые года три назад, к примеру, было нельзя по причине отсутствия рынка сбыта, а сейчас уже можно. С другой стороны, разобравшись с тем, что игры выгоднее не продавать, а раздавать бесплатно, получая деньги за дополнительные услуги, производители запустили обратный процесс — когда с «красивостями» специально стараются не перебарщивать для расширения «кормовой базы». Да еще игры, портированные с консолей, дают о себе знать, а ведь скоро и порты с телефонов должны пойти широким потоком... В общем, и владельцу среднего игрового компьютера всегда будет во что поиграть, даже без необходимости постоянно модернизировать ПК. Но конечно, если вам требуются именно те самые конкретные «штучные проекты», то понадобится и оборудование, которое, пожалуй, имеет смысл рассматривать отдельно и в рамках специальных материалов.