Теоретическая часть: особенности архитектуры

Недавно компания Nvidia представила видеокарты нового семейства GeForce RTX 30, основанные на архитектуре Ampere, пришедшей на смену Turing. Предыдущая архитектура стала революционной, впервые предложив аппаратную поддержку трассировки лучей и аппаратного же ускорения задач искусственного интеллекта при помощи тензорных ядер. Но производительности тех GPU порой не хватало даже для использования пары эффектов с применением трассировки, поэтому неудивительно, что Nvidia в Ampere сделала упор именно на производительность.

Как только стали доступны технологии производства полупроводников по более тонким нормам, вместе с возможностью значительного прироста количества транзисторов при сохранении приемлемой площади кристалла, в архитектуре Ampere сразу было реализовано улучшение именно в плане производительности, а не для появления новых возможностей. Хотя и они тоже есть, но все же это явно эволюционное развитие возможностей предыдущей архитектуры Turing. Предлагаемые по приемлемым ценам, новинки дали пользователям долгожданное улучшение соотношения цены и производительности.

Решения семейства Ampere, благодаря специальным решениям и производству по более тонкому техпроцессу, обеспечивают повышенную энергоэффективность и производительность в пересчете на единицу площади кристалла, что особенно полезно в самых требовательных задачах, вроде трассировки лучей в играх, которая сильно просаживает производительность. Игровые решения архитектуры Ampere примерно в 1,5-1,7 раза быстрее Turing в традиционных задачах растеризации, и до двух раз быстрее при трассировке лучей.

Первым графическим процессором на основе архитектуры Ampere стал большой «вычислительный» чип GA100, вышедший в мае и показавший мощный прирост производительности в различных вычислительных задачах. Но это все-таки чисто вычислительный чип, предназначенный для узкоспециализированных применений. А игровые видеокарты серии GeForce RTX 30 на базе архитектуры Ampere были представлены директором компании Дженсеном Хуангом во время виртуального мероприятия Nvidia в начале сентября.

Всего было представлено три модели: RTX 3090, RTX 3080 и RTX 3070, мы с вами уже рассмотрели среднюю из них, сегодня узнаем все о топовой, ну а время младшей придет в октябре. Модели RTX 3090 и RTX 3080 сделаны на базе разных модификаций чипа GA102, имеющих отличающееся количество активных вычислительных блоков. Если даже младшая RTX 3070 должна быть примерно на уровне флагмана предыдущей линейки RTX 2080 Ti, то топовая RTX 3090 и вовсе на 50% обходит дорогущий Titan RTX.

Самая производительная модель новой линейки имеет 10496 вычислительных CUDA-ядер, 24 ГБ локальной видеопамяти нового стандарта GDDR6X и отлично подходит для игр в самом высоком 8K-разрешении. Это модель класса Titan с ценой в $1499 (136 990 руб.), но имеющая обычное цифровое наименование — в этот раз Nvidia решила (пока?) не выпускать Titan. Трехслотовая модель с огромным кулером способна справиться с любыми задачами, игровыми и не только. Новинка предназначена для игры как минимум в 4K-разрешении, и даже может обеспечить 60 FPS в 8K-разрешении во многих играх, особенно с применением DLSS.

Основой рассматриваемой сегодня модели видеокарты стал новый графический процессор архитектуры Ampere, но так как она имеет достаточно много общего с предыдущими архитектурами Turing, Volta и местами даже Pascal, то перед прочтением материала мы советуем ознакомиться с нашими предыдущими статьями:

- [18.09.20] Nvidia GeForce RTX 3080, часть 2: описание карты Palit, игровые тесты, выводы

- [16.09.20] Nvidia GeForce RTX 3080, часть 1: теория, архитектура, синтетические тесты

- [08.10.18] Обзор новинки 3D-графики 2018 года — Nvidia GeForce RTX 2080

- [19.09.18] Nvidia GeForce RTX 2080 Ti — обзор флагмана 3D-графики 2018 года

- [14.09.18] Игровые видеокарты Nvidia GeForce RTX — первые мысли и впечатления

- [06.06.17] Nvidia Volta — новая вычислительная архитектура

- [09.03.17] GeForce GTX 1080 Ti — новый король игровой 3D-графики

| Графический ускоритель GeForce RTX 3090 | |

|---|---|

| Кодовое имя чипа | GA102 |

| Технология производства | 8 нм (Samsung «8N Nvidia Custom Process») |

| Количество транзисторов | 28,3 млрд |

| Площадь ядра | 628,4 мм² |

| Архитектура | унифицированная, с массивом процессоров для потоковой обработки любых видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12 Ultimate, с поддержкой уровня возможностей Feature Level 12_2 |

| Шина памяти | 384-битная: 12 независимых 32-битных контроллеров памяти с поддержкой памяти типа GDDR6X |

| Частота графического процессора | до 1695 МГц (турбо-частота) |

| Вычислительные блоки | 82 потоковых мультипроцессора (из 84 в полном чипе), включающих 10496 CUDA-ядер (из 10752 ядер) для целочисленных расчетов INT32 и вычислений с плавающей запятой FP16/FP32/FP64 |

| Тензорные блоки | 328 тензорных ядер (из 336) для матричных вычислений INT4/INT8/FP16/FP32/BF16/TF32 |

| Блоки трассировки лучей | 82 RT-ядра (из 84) для расчета пересечения лучей с треугольниками и ограничивающими объемами BVH |

| Блоки текстурирования | 328 блоков (из 336) текстурной адресации и фильтрации с поддержкой FP16/FP32-компонент и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растровых операций (ROP) | 14 широких блоков ROP на 112 пикселей с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16/FP32-форматах буфера кадра |

| Поддержка мониторов | поддержка HDMI 2.1 и DisplayPort 1.4a (со сжатием DSC 1.2a) |

| Спецификации референсной видеокарты GeForce RTX 3090 | |

|---|---|

| Частота ядра | до 1695 МГц |

| Количество универсальных процессоров | 10496 |

| Количество текстурных блоков | 328 |

| Количество блоков блендинга | 112 |

| Эффективная частота памяти | 19,5 ГГц |

| Тип памяти | GDDR6X |

| Шина памяти | 384-бит |

| Объем памяти | 24 ГБ |

| Пропускная способность памяти | 936 ГБ/с |

| Вычислительная производительность (FP32) | до 35,6 терафлопс |

| Теоретическая максимальная скорость закраски | 193 гигапикселей/с |

| Теоретическая скорость выборки текстур | 566 гигатекселей/с |

| Шина | PCI Express 4.0 |

| Разъемы | один HDMI 2.1 и три DisplayPort 1.4a |

| Энергопотребление | до 350 Вт |

| Дополнительное питание | два 8-контактных разъема |

| Число слотов, занимаемых в системном корпусе | 3 |

| Рекомендуемая цена | $1499 (136 990 рублей) |

Это вторая модель нового поколения и ее название соответствует принципу наименования решений компании, так как ниже нее стоит менее дорогая RTX 3080. Правда, в прошлом поколении модели RTX 2090 не было вообще, а был отдельный Titan RTX. Соответственно, рекомендованная цена для GeForce RTX 3090 ближе не к RTX 2080, а что-то среднее между RTX 2080 Ti и Titan RTX, так как они являются топовыми представителями своих поколений — $1499. Для нашего рынка рекомендация по цене в 136990 рублей сначала могла показаться завышенной, но из-за резкого падения курса национальной валюты в последнее время, как бы ее еще корректировать в большую сторону не пришлось.

В любом случае, у RTX 3090 на рынке просто нет конкурентов, и на нее Nvidia может ставить цену по своему усмотрению. Точнее, соперник то у нее есть, и довольно сильный, но это — модель этой же линейки в виде RTX 3080, которая даже по теоретической производительности уступает топовому решению от силы 20%-25%. А стоит то она гораздо дешевле! Поэтому если кому-то достаточно 10 ГБ видеопамяти и несколько меньшей производительности, то у него появляется немалый соблазн сэкономить. С другой стороны, если вам нужен максимум производительности и большой объем памяти, а вопрос цены на третьем месте, то выбора просто не остается.

О конкурентах со стороны компании AMD пока что сказать нечего. Radeon VII давно устарел и снят с производства, Radeon RX 5700 XT является решением более низкого уровня, а больше у них ничего и нет. Так что ждем решений на базе архитектуры RDNA2, и особенно любопытен будет большой чип «Big Navi», хотя и далеко еще не факт, что и он сможет конкурировать с GeForce RTX 3090.

Nvidia выпустила видеокарты новой серии и в собственном дизайне под наименованием Founders Edition. Они предлагают любопытные системы охлаждения и строгий дизайн, которого не найти у большинства производителей видеокарт, гонящихся за количеством и размером вентиляторов, а также разноцветной подсветкой. Самое интересное в GeForce RTX 30, продаваемых под брендом Nvidia — совершенно новый дизайн системы охлаждения с двумя вентиляторами, расположенными необычным образом: первый более-менее привычно выдувает воздух через решетку с торца платы, а вот второй установлен с обратной стороны и протягивает воздух прямо сквозь видеокарту.

Таким образом, тепло отводится от компонентов на карте в гибридную испарительную камеру, где оно распределяется по всей длине радиатора. Левый вентилятор выводит нагретый воздух через большие вентиляционные отверстия в креплении, а правый вентилятор направляет воздух к выдувному вентилятору корпуса, где он обычно установлен в большинстве современных систем. Эти два вентилятора работают на разной скорости, которая настраивается для них индивидуально.

Подобное решение заставило инженеров менять всю конструкцию. Если обычные печатные платы проходят во всю длину видеокарт, то в случае продувного вентилятора пришлось разработать короткую печатную плату, с уменьшенным слотом NVLink, новыми разъемами питания (переходник на два обычных 8-контактных PCI-E прилагается). При этом, разместить на карте большое количество фаз для питания и микросхем памяти, было очень непросто. Но эти изменения дали возможность большого выреза для вентилятора на печатной плате, чтобы потоку воздуха ничего не мешало.

Nvidia утверждает, что дизайн кулеров Founders Edition привел к заметно более тихой работе, чем стандартные кулеры с двумя осевыми вентиляторами с одной стороны, при этом эффективность охлаждения у них выше. Поэтому новые решения устройств охлаждения позволили повысить производительность без роста температуры и шума по сравнению с видеокартами предыдущего поколения Turing. Так, по данным компании, при уровне потребления 350 Вт рассматриваемая сегодня новинка или на 30 градусов холоднее модели Titan RTX, или на 20 дБА тише. Это мы проверим далее.

Видеокарта модели RTX 3090 доступна в розничных магазинах с 24 сентября, но в связи с недостаточным объемом производства и пока еще высоким спросом, продукт по хорошей цене еще придется поискать. Видеокарты GeForce RTX 30 Founders Edition должны начать продаваться на русскоязычном сайте Nvidia с 6 октября. Естественно, что партнеры компании выпускают карты собственного дизайна: Asus, Colorful, EVGA, Gainward, Galaxy, Gigabyte, Innovision 3D, MSI, Palit, PNY и Zotac.

Некоторые из видеокарт будут продаваться участвующими в акции продавцами с 17 сентября по 20 октября в комплекте с игрой Watch Dogs: Legion и годовой подпиской на сервис GeForce Now. Также графическими процессорами серии GeForce RTX 30 будут оснащены игровые системы компаний Acer, Alienware, Asus, Dell, HP, Lenovo и MSI и системы ведущих российских сборщиков, включая Boiling Machine, Delta Game, Hyper PC, InvasionLabs, OGO! и Edelweiss.

Архитектурные особенности

При производстве GA102 используется техпроцесс 8 нм компании Samsung, он дополнительно оптимизирован именно для Nvidia. Старший игровой чип Ampere содержит 28,3 миллиарда транзисторов и имеет площадь 628,4 мм² — это хороший шаг вперед по сравнению с 12 нм у Turing, но тот же техпроцесс 7 нм на TSMC по плотности все же превосходит 8 нм у Samsung, если судить по чипам одной архитектуры Ampere, сравнивая игровой GA102 и большой чип GA100, который производится именно на тайваньских фабриках.

Скорее всего, Nvidia выбрала техпроцесс Samsung, исходя из себестоимости и доступности массового производства больших чипов. Выход годных на заводе Samsung вполне может быть лучше, условия для такого жирного клиента наверняка особые, а у TSMC производственные мощности техпроцесса 7 нм уже заняты другими компаниями. Так что игровые Ampere производятся на фабриках Samsung скорее всего из-за несогласия Nvidia с предложенными тайваньцами ценами или другими условиями.

Как и предыдущие чипы компании, GA102 состоит из укрупненных кластеров Graphics Processing Cluster (GPC), которые включают несколько кластеров текстурной обработки Texture Processing Cluster (TPC), которые содержат потоковые процессоры Streaming Multiprocessor (SM), блоки растеризации Raster Operator (ROP) и контроллеры памяти. Полный чип GA102 содержит семь кластеров GPC, 42 кластера TPC и 84 мультипроцессора SM. Каждый GPC содержит шесть TPC, каждый из пары SM, а также один движок PolyMorph Engine для работы с геометрией.

GPC — это высокоуровневый кластер, включающий все ключевые блоки для обработки данных внутри него, каждый из них имеет выделенный движок растеризации Raster Engine и теперь включает два раздела ROP по восемь блоков каждый — в новой архитектуре Ampere эти блоки не привязаны к контроллерам памяти, а находятся прямо в GPC. В итоге, полный GA102 содержит 10752 потоковых CUDA-ядра, 84 RT-ядер второго поколения и 336 тензорных ядер третьего поколения. Подсистема памяти полного GA102 содержит двенадцать 32-битных контроллеров памяти, что дает 384-бит в общем. Каждый 32-битный контроллер связан с разделом кэш-памяти второго уровня объемом в 512 КБ, что дает общий объем L2-кэша в 6 МБ для полной версии GA102.

Но пока что мы говорили о полном чипе, а даже топовая модель видеокарты GeForce RTX 3090 использует слегка урезанный по количеству блоков вариант GA102. Эта модификация получила незначительно сниженные характеристики, в которой активных кластеров GPC осталось семь, а количество блоков SM снизилось лишь на два — то есть, в одном из GPC просто отключили один из кластеров TPC с парой мультипроцессоров. Соответственно, в итоге отличается и количество других блоков: 10496 CUDA-ядер, 328 тензорных ядер и 82 RT-ядра. Текстурных блоков осталось 328 штук, а вот блоки ROP активны все — 112. Эти показатели заметно выше, чем у RTX 3080, но это все равно не полный чип.

Еще одно важнейшее отличие от GeForce RTX 3080 заключается в наличии 24 ГБ быстрой GDDR6X-памяти, которая подключена по полной 384-битной шине, что дает чуть ли не терабайт пропускной способности. В отличие от 10 ГБ у «средней» модели RTX 3080, этого объема точно хватит на все. Хотя Nvidia уверяет, что ни одна игра в 4K-разрешении не требует большего объема памяти, но скоро выйдут консоли нового поколения с большим объемом памяти и быстрыми SSD, и некоторые мультиплатформенные или портированные с них игры могут начать требовать большего, чем 10 ГБ локальной видеопамяти.

Пропускная способность также увеличилась и достигла 936 ГБ/с. Но для столь мощного GPU и этого может не всегда хватать, особенно при удвоении общей производительности. Кроме того, хотя Micron указывает эффективную рабочую частоту памяти как 21 ГГц, Nvidia в своих продуктах использует довольно консервативные 19,5 для RTX 3090 — интересно, в чем тут дело? В сырости нового типа памяти и/или ее слишком высоком энергопотреблении?

Подробно рассматривать архитектурные улучшения Ampere в этой статье мы не будем, все написано в теоретическом материале по GeForce RTX 3080. Основным нововведением Ampere является удвоение FP32-производительности для каждого мультипроцессора SM, по сравнению с семейством Turing, что привело к значительному повышению пиковой производительности. Почти то же самое касается и RT-ядер — хотя их число и не изменилось, внутренние улучшения привели к удвоению темпа поиска пересечений лучей с геометрией. Улучшенные тензорные ядра хоть и не удвоили производительность при обычных условиях, но темп вычислений удвоился, а также появилась возможность удвоения скорости обработки так называемых разреженных матриц.

Все остальные архитектурные особенности игровых решений Ampere, включая изменения в мультипроцессорах SM, блоках ROP, системе кэширования и текстурирования, тензорных и RT-ядрах, подробно рассмотрены в теоретическом обзоре RTX 3080. Там же приведены сведения о новом типе памяти GDDR6X, который применяется в старших чипах новой линейки. Все улучшения привели к достижению довольно высокой энергоэффективности, вся архитектура Ampere делалась с упором на это, включая доработанный техпроцесс Samsung, дизайн чипов и печатных плат, оптимизацию ПО и многое другое.

Добавим лишь небольшое дополнение про интереснейший набор технологий RTX IO, обеспечивающих быструю передачу и распаковку ресурсов на GPU, что повышает производительность системы ввода-вывода в десятки раз, по сравнению с привычными HDD и традиционными API. RTX IO в будущем обеспечит очень быструю загрузку ресурсов игры и позволит создавать гораздо более разнообразные и детализированные виртуальные миры.

RTX IO распаковывает данные при помощи потоковых процессоров GPU, это осуществляется асинхронно — при помощи высокопроизводительных вычислительных кернелов, используя механизмы прямого доступа к памяти архитектур Turing и Ampere, также помогает в процессе улучшенный набор инструкций и новая архитектура мультипроцессоров SM, позволяющая использовать расширенные асинхронные вычислительные возможности.

У Nvidia все необходимое для работы этой технологии было и раньше в их собственной технологии GPUDirect Storage, но за исключением распаковки сжатых данных на GPU. Именно в этом и заключается принципиально новая возможность RTX IO и DirectStorage API. При использовании GPU Nvidia и ранее можно было осуществить подобный подход в операционных системах Linux, но в Windows есть определенные фундаментальные архитектурные ограничения, не позволяющие реализовать прямой обмен данными в полной мере.

Поэтому разработчикам придется ждать, пока Microsoft реализует эти возможности в их собственном DirectStorage API. Впрочем, это не должно сильно помешать, так как вряд ли в ближайшие годы появятся игры, даже портированные с консолей следующего поколения, которые смогут полностью использовать возможности быстрых SSD. Пока что разработчики все еще ориентируются на механические HDD-накопители, но так как рыночная доля SSD (NVMe, в частности) растет быстро, то пройдет пара-тройка лет, и такие игры точно появятся.

Поддержка технологии DLSS в 8K

Совсем недавно 4K-разрешение казалось очень высоким, а теперь 8K-телевизоры уже предлагаются на рынке в исполнении компаний LG, Samsung и Sony, и цены на них начинаются от $2999. Распространению 8K мешает не только отсутствие соответствующего контента в подобном разрешении, но и высочайшая требовательность. Такие условия не только предъявляют вчетверо больше требований к мощности GPU, но и повышенный объем видеопамяти для загрузки всех необходимых ресурсов повышенного качества. Даже простое декодирование 8K-видео в форматах H.265 и VP9 может быть слишком требовательной задачей, не говоря уже о его кодировании и уж тем более 3D-рендеринге.

Зачем вообще нужно высокое разрешение? Разве не важнее само качество затенения, освещения, качественного наложения теней и так далее? Конечно важнее, но все эти улучшения труднее увидеть в низких разрешениях, когда изображение расплывчатое. Увеличение разрешения позволяет повысить общие четкость и детализацию, а вместе с этим и реалистичность. Конечно, это не стоит делать, снижая качество графики, все должно быть сбалансировано. Но именно в высоких разрешениях, вроде 8K, и можно увидеть мелкие детали.

Устройства вывода с поддержкой 8K-разрешения (7680×4320 пикселей) выводят 33 миллиона пикселей несколько раз в секунду, по сравнению с парой миллионов для Full HD и 8 миллионами для 4K. Так что вполне можно себе предположить приличный шаг в улучшении четкости, если учитывать разницу между Full HD и 4K, которую все уже видели. Столь большое количество пикселей позволяет увидеть максимальное количество деталей в сгенерированной картинке. Например, по 8K-скриншоту из игры Watch Dogs: Legion:

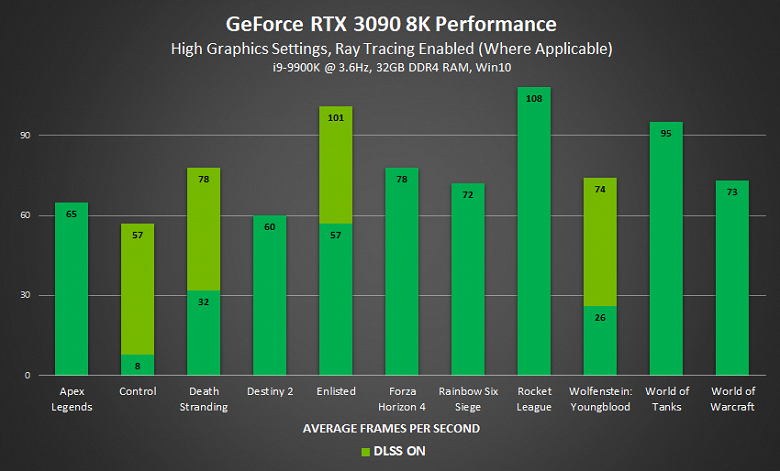

Видеокарта GeForce RTX 3090 в принципе является наиболее подходящей для 8K-разрешения. Во-первых, вместо двух кабелей для подключения к устройствам с разъемом HDMI 2.1 на всех Ampere можно использовать лишь один кабель. Во-вторых, это максимально производительный графический процессор на сегодня, а даже 4K-разрешение требует подобной мощности, не говоря уже о 8K. И в-третьих, зачастую 3D-приложения в высоком разрешении используют очень много видеопамяти, а GeForce RTX 3090 имеет более чем вдвое больший объем видеопамяти, по сравнению с прошлым флагманом компании — RTX 2080 Ti с его 11 ГБ. Новая модель несет 24 ГБ памяти нового типа GDDR6X с высокой пропускной способностью, которая также важна для 8K. Так что Nvidia не так уж далека от истины, когда называет этот GPU первым подходящим для 8K. Но все не так просто, ведь даже в 4K порой недостаточно производительности, особенно при включенной трассировке лучей.

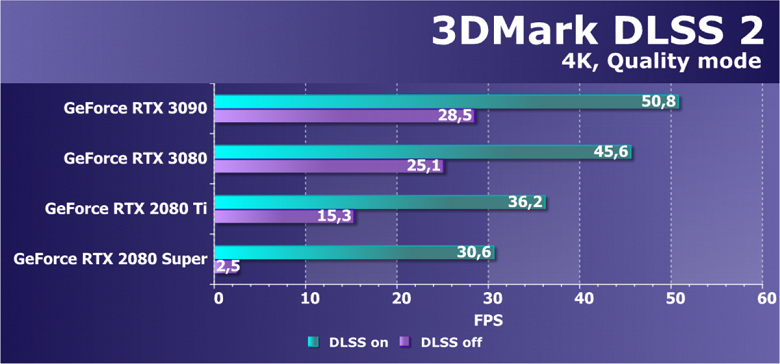

Давно известно, что трассировка лучей — это крайне затратный и ресурсоемкий процесс. Настолько, что компания Nvidia сделала аппаратную поддержку так называемого Deep Learning Super Sampling (DLSS) в своем предыдущем поколении Turing. Этот метод повышения производительности использует возможности выделенных тензорных ядер для работы нейросети, которая дорисовывает недостающие пиксели при переводе изображения из более низкого разрешения в требуемое.

Например, для того, чтобы получить приемлемую производительность с применением трассировки в 4К, картинка отрисовывается в меньшем разрешении (вплоть до Full HD в случае производительного режима DLSS) и далее восстанавливается до полноценного разрешения при помощи заранее подготовленной нейросети, которая работает с использованием информации из предыдущих кадров и способна отображать даже мелкие детали. В итоге, картинка получается схожей с той, что получается при рендеринге в полном разрешении, при этом общая производительность будет намного выше. А сам по себе алгоритм DLSS требует совсем немного ресурсов GPU.

Вместе с выходом решений архитектуры Ampere были добавлены некоторые улучшения и в технологию DLSS — в частности, была проведена оптимизация под тензорные ядра третьего поколения и улучшенные асинхронные вычисления, а также появился новый режим для разрешения 8K. Он использует рендеринг изображения с в 9 раз меньшим количеством пикселей и затем восстанавливает его до полного разрешения 8K. Именно такой подход и позволяет получить качество высокого разрешения при сохранении 60 FPS даже в играх с поддержкой трассировки лучей.

При работе DLSS в 8K применяется улучшенная модель для нейросети, которая использует рендеринг в разрешении 2560×1440 и затем растягивает его до 7680×4320 с использованием мощи тензорных ядер. Даже на 4K-мониторе видно, насколько лучше становится качество в восстановленном при помощи DLSS изображении. Это и неудивительно, ведь оно предлагает в 16 раз больше пикселей чем Full HD, и вчетверо больше 4K.

Вообще, DLSS 2.1 включает три улучшения: новый режим Ultra Performance, позволяющий запускать игры в разрешении 8K при помощи DLSS на GeForce RTX 3090; поддержку VR-приложений и динамического разрешения, когда разрешение рендеринга входного кадра для DLSS изменяется постоянно, но выходное всегда фиксировано — так что если игровой движок поддерживает динамическое разрешение, то эта DLSS позволяет довольно легко отмасштабировать его до разрешения дисплея с максимально возможным качеством.

В играх с поддержкой технологии, у пользователей появится выбор из четырех режимов качества DLSS: Quality, Balanced, Performance и Ultra Performance. Поддержка последней версии технологии DLSS, включая режим Ultra Performance для 8K, должна появиться в следующих играх: Boundary, Bright Memory Infinite, Control, Call of Duty: Black Ops Cold War, Cyberpunk 2077, Death Stranding, Justice, Fortnite, Minecraft RTX, Ready or Not, Scavengers, Watch Dogs: Legion и Wolfenstein: Youngblood.

Применение в профессиональном ПО

Видеокарта модели GeForce RTX 3090 предназначена не только для богатых энтузиастов игр на ПК, но и различных представителей современной индустрии, использующих мощь современных графических процессоров в собственной работе: дизайнеры, 3D-аниматоры, ИИ-разработчики, ученые и многие другие, нацеленные на использование самых мощных GPU в мире. Именно GeForce RTX 3090 и является таковым, предлагая максимум всего. Аналогично своему условному предшественнику в виде Titan RTX, новинка несет на борту 24 ГБ быстрой памяти, важной для всех перечисленных категорий пользователей, в частности для обработки видеоданных в формате 8K HDR, а также предлагает высочайшую производительность в вычислительных приложениях, в том числе с аппаратной поддержкой трассировки лучей.

Новое семейство видеокарт GeForce RTX 30 приносит улучшенные возможности по ускорению рендеринга в таких популярных приложениях, как Blender Cycles, Chaos V-Ray и Autodesk Arnold. Помимо вдвое более производительных RT-ядер и удвоенного темпа исполнения математических вычислений в GPU новой архитектуры Ampere, отдельно отметим новую возможность для ускорения смазывания в движении (motion blur) для трассированных изображений, которая ускоряется на RTX 30 в несколько раз, вплоть до пяти. А огромный объем видеопамяти в 24 ГБ позволяет загрузить в нее большие 3D-проекты для аппаратной обработки полностью, без необходимости использования медленной системной памяти.

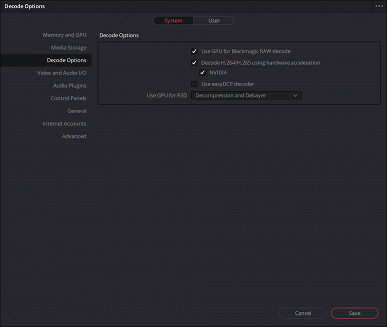

Новая архитектура Ampere помогает ускорять и приложения искусственного интеллекта, также применяемые в 3D-графике в виде технологии DLSS и постфильтров шумоподавления. Например, технология DLSS повышает производительность рендеринга в реальном времени не только в играх, но и в приложениях визуализации, вроде D5 Render. Тензорные ядра третьего поколения помогают ускорить процесс шумоподавления в рендерерах Blender Cycles, Chaos V-Ray и Autodesk Arnold, а также повысить разрешение видеороликов или улучшить качество замедленного видео в Davinci Resolve.

Серия GeForce RTX 30 отлично подходит для всех перечисленных применений, ведь в число новых возможностей входит поддержка PCI Express четвертого поколения, удваивающая производительность каналов между GPU и остальной системой, что помогает при передача огромных объемов данных при обработке видеороликов высокого разрешения. Для этой же цели будет полезен очень большой объем локальной видеопамяти в 24 ГБ. Многие приложения по работе с видеоданными позволят комфортно работать с множеством эффектов при обработке 8K-видео. А в приложениях с применением трассировки лучей средняя производительность решений на базе архитектуры Ampere в 1,8-2,4 раза выше, чем у аналогичных GPU из семейства Turing:

Мы уже писали о том, что в архитектуре Ampere появилось аппаратное ускорение эффекта смазывания в движении при трассировке лучей. Одним из первых рендереров с поддержкой такой возможности стал Blender Cycles, и в результате процесс ускоряется вплоть до пяти раз. Это в теории, а в реальных сценах поменьше, конечно. Использование RTX-ускорения в рендерере Cycles дает высококачественное смазывание без артефактов при высокой скорости. Blender — это очень популярное ПО для 3D-моделирования, анимации и рендеринга, которое может использовать возможности ускорения трассировки лучей на GPU при помощи Nvidia Optix, как для финального рендеринга, так и при предпросмотре прямо в окне Blender, что дает возможность удобной оценки получаемых материалов, освещения и теней.

Еще один популярный рендерер — OctaneRender. Это независимый рендерер, использующий возможности CUDA и RTX и доступный в большинстве популярных приложений по созданию 3D-контента: Autodesk Maya и 3ds Max, Maxon Cinema 4D, DAZ 3D, Side Effects Houdini, Unreal Engine и других. Также Octane включает полноценный внешний редактор рендеринга, позволяющий отрисовывать сцены без необходимости запуска стороннего ПО. Предварительная версия OctaneRender 2020.1.5 получила поддержку второго поколения RTX, включая аппаратное ускорение трассировки лучей на RT-ядрах и оптимизации работы ИИ на тензорных ядрах — для шумоподавления.

В результате на Ampere достигается производительность примерно вдвое выше, чем на соответствующих Turing. Использование технологий Nvidia для рендеринга с трассировкой лучей и со смазыванием в движении, а также ускоренном при помощи ИИ шумоподавлении, 3D-приложения вроде Blender позволяют специалистам повысить производительность труда и быстрее получать итоговый результат. Также в приложения по созданию цифрового контента потихоньку внедряется и технология DLSS. Это позволяет получить в программе визуализации D5 Render неплохие 35 FPS вместо 19 FPS без DLSS в одной из сцен. То же самое касается и Autodesk VRED 2021, позволяющем получить трассированные изображения высокого качества в реальном времени.

Отметим также относительно новую форму искусства Машинима (Machinima — сочетание machine и cinema), в которой для создания кинематографических шедевров применяются игровые движки и модели и текстуры из игр же. Машинима стала популярной в 90-е годы, и имеет немало поклонников. Компания Nvidia, желающая поддержать таких энтузиастов, представила специальное средство для создания подобных роликов — Omniverse Machinima.

Оно значительно упрощает подобную работу, предоставляя инструменты для просмотра и движок с поддержкой трассировки лучей, корректных физических взаимодействий, включая симуляцию жидкостей и частиц, продвинутых материалов и т. д. Все желающие смогут использовать ресурсы из списка поддерживаемых игр, и при помощи ИИ и собственных действий создавать качественную анимацию кинематографического качества при помощи мощных графических процессоров серии RTX 30.

Создание контента подобной сложности всегда представляло определенные проблемы из-за ограничений игровых ресурсов и имеющихся инструментов для анимации. Довольно сложно создать долгую и реалистичную анимацию современного уровня, но теперь, благодаря внедрению технологий Nvidia, создатели Machinima будут иметь под рукой богатый набор инструментов с расширенными возможностями для создания собственных историй в реальном времени. Для анимации персонажей достаточно веб-камеры, микрофона и специального алгоритма обработки с применением ИИ.

При помощи Nvidia Omniverse можно импортировать ресурсы из поддерживаемых игр и сторонних библиотек ресурсов, а затем автоматически анимировать персонажей при помощи использования специального средства позирования с применением возможностей ИИ и записей с веб-камеры. Лица персонажей можно оживить при использовании технологии Nvidia Audio2Face просто с помощью аудиозаписи с голосом.

Также можно имитировать физические взаимодействия высокой реалистичности с применением систем частиц и симуляции поведения жидкостей. После создания всех сцен, итоговый фильм можно отрисовать с применением трассировки пути при помощи рендерера Omniverse RTX. Бета-версия Nvidia Omniverse Machinima должна появиться в октябре.

Особенности видеокарты Nvidia GeForce RTX 3090 Founders Edition

Сведения о производителе: Компания Nvidia Corporation (торговая марка Nvidia) основана в 1993 году в США. Штаб-квартира в Санта-Кларе (Калифорния). Разрабатывает графические процессоры, технологии. До 1999 года основной маркой была Riva (Riva 128/TNT/TNT2), с 1999 года и по настоящее время — GeForce. В 2000 году были приобретены активы 3dfx Interactive, после чего торговые марки 3dfx/Voodoo перешли к Nvidia. Своего производства нет. Общая численность сотрудников (включая региональные офисы) — около 5000 человек.

Объект исследования: ускоритель трехмерной графики (видеокарта) Nvidia GeForce RTX 3090 Founders Edition 24 ГБ 384-битной GDDR6X

Характеристики карты

| Nvidia GeForce RTX 3090 Founders Edition 24 ГБ 384-битной GDDR6X | |

|---|---|

| GPU | GeForce RTX 3090 (GA102) |

| Интерфейс | PCI Express x16 4.0 |

| Частота работы GPU (ROPs), МГц | 1395—1695(Boost)—1995(Max) |

| Частота работы памяти (физическая (эффективная)), МГц | 4875 (19500) |

| Ширина шины обмена с памятью, бит | 384 |

| Число вычислительных блоков в GPU | 82 |

| Число операций (ALU/CUDA) в блоке | 128 |

| Суммарное количество блоков ALU/CUDA | 10496 |

| Число блоков текстурирования (BLF/TLF/ANIS) | 328 |

| Число блоков растеризации (ROP) | 112 |

| Число блоков Ray Tracing | 82 |

| Число тензорных блоков | 328 |

| Размеры, мм | 310×125×53 |

| Количество слотов в системном блоке, занимаемые видеокартой | 3 |

| Цвет текстолита | черный |

| Энергопотребление пиковое в 3D, Вт | 364 |

| Энергопотребление в режиме 2D, Вт | 38 |

| Энергопотребление в режиме «сна», Вт | 11 |

| Уровень шума в 3D (максимальная нагрузка), дБА | 34,7 |

| Уровень шума в 2D (просмотр видео), дБА | 18,0 |

| Уровень шума в 2D (в простое), дБА | 18,0 |

| Видеовыходы | 1×HDMI 2.1, 3×DisplayPort 1.4a |

| Поддержка многопроцессорной работы | SLI (NVlink) |

| Максимальное количество приемников/мониторов для одновременного вывода изображения | 4 |

| Питание: 8-контактные разъемы | 1 (12-контактный) c адаптером на 2 8-контактных разъема |

| Питание: 6-контактные разъемы | 0 |

| Максимальное разрешение/частота, Display Port | 7680×4320@60 Гц |

| Максимальное разрешение/частота, HDMI | 7680×4320@60 Гц |

| Максимальное разрешение/частота, Dual-Link DVI | 2560×1600@60 Гц (1920×1200@120 Гц) |

| Максимальное разрешение/частота, Single-Link DVI | 1920×1200@60 Гц (1280×1024@85 Гц) |

| Средняя розничная стоимость карты Palit | около 150 тысяч рублей на момент подготовки обзора |

Память

Карта имеет 24 ГБ памяти GDDR6X SDRAM, размещенной в 24 микросхемах по 8 Гбит на обеих сторонах PCB (по 12 на каждой). Микросхемы памяти Micron (GDDR6X, MT61K256M32JE-21) рассчитаны на условную номинальную частоту работы в 5250 (21000) МГц. Расшифровщик кодов на упаковках FBGA находится здесь.

Особенности карты и сравнение с Nvidia GeForce RTX 2080 Ti

| Nvidia GeForce RTX 3090 Founders Edition 24 ГБ | Nvidia GeForce RTX 2080 Ti 11 ГБ |

|---|---|

| вид спереди | |

|

|

| вид сзади | |

|

|

Прежде всего: почему мы сравниваем с GeForce RTX 2080 Ti? Во-первых, это флагманский продукт предыдущего поколения, как GeForce RTX 3090 является флагманом сейчас. Во-вторых, GeForce RTX 2080 Ti имеет шину обмена с памятью 352 бита, что максимально близко к нынешним 384 битам ширины шины у GeForce RTX 3090. В-третьих, по иронии судьбы, к нам так до сих пор и не прибыли референс-карты GeForce RTX 3080 (с которыми сравнивать, наверно, было бы логичнее).

Очевидно, что референс-дизайн инженеры Nvidia сделали не только уникальным, но и весьма забавным внешне. Впрочем, в Nvidia сделали два варианта дизайна PCB: для своих карт Founders Edition и для партнеров, у последних платы без таких вырезов, немного проще. В целом фирменная карта получилась очень компактной, несмотря на шину обмена с памятью в 384 бита.

Суммарное количество фаз питания у GeForce RTX 3090 просто ошеломляет: 22! Это на 6 больше, чем у GeForce RTX 2080 Ti и GeForce RTX 3080 (там 16). При этом распределение фаз у GeForce RTX 2080 Ti — 13 фаз на ядро и 3 на микросхемы памяти, у GeForce RTX 3080 — 14+2, а у GeForce RTX 3090 — 18+4.

Зеленым цветом отмечена схема питания ядра, красным — памяти. При этом никаких удвоителей (даблеров) фаз нет, для управления схемой питания GPU используются три ШИМ-контроллера Monolithic Power Systems: MP2884 рассчитан на 4 фазы, MP2886 — на 6 фаз, а MP2888 — на управление 10 фазами питания. Первые два расположены на оборотной стороне платы, а третий — на лицевой.

Совместными усилиями они обеспечивают 18 фаз схемы питания GPU. Система питания микросхем памяти включает 4 фазы, которыми заведует один из uS5650Q (uPI Semiconductor).

Второй такой контроллер отвечает за мониторинг состояния платы.

В преобразователе питания, традиционно для всех видеокарт Nvidia, используются транзисторные сборки DrMOS — в данном случае, MP86957 той же Monolithic Power Systems.

У карты необычный коннектор питания — 12-контактный. Причем один.

Еще в начальном видеоролике мы упомянули, что ряд производителей блоков питания, прежде всего Seasonic, объявили о выпуске отдельных кабелей («хвостов») для своих модульных БП для подключения к референс-картам серии GeForce RTX 30. Ну а с самой картой, конечно же, поставляется переходник, позволяющий подключить два 8-контактных коннектора к новому разъему.

Возникает вопрос: зачем эти сложности, если для питания карты все равно задействованы те же два 8-контактных коннектора, под которые совершенно спокойно распаивают два 8-контактных разъема на своих GeForce RTX 3080/3090 партнеры Nvidia? Ведь новый 12-контактный разъем пока встречается только у карт серии Founders Edition. Ответа на этот вопрос пока нет. Впрочем, у карт с двумя 8-контактными разъемами наблюдался повышенный нагрев разъемов питания, чего не было отмечено у референс-карты. Возможно, распределение тока по проводникам в 12-контактном разъеме, как у Founders Edition, более рациональное.

Нагрев и охлаждение

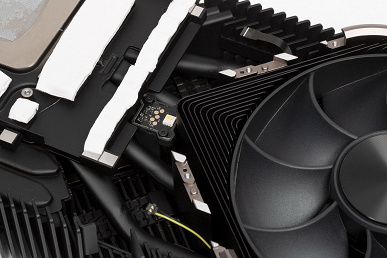

Не случайно в Nvidia решили сделать PCB более компактной: для новых карт задумана специальная система охлаждения.

Основной пластинчатый радиатор, выполненный из медного сплава и очень тяжелый, имеет тепловые трубки, подведенные к теплосъемнику на GPU. Массивная основа (по сути, настоящая рама) охлаждает также микросхемы памяти с лицевой стороны и преобразователи питания VRM. Задняя пластина служит охладителем других 12 микросхем памяти, а также участвует в охлаждении оборотной стороны PCB.

Вентиляторов здесь два (∅95 мм), в обоих используются двойные подшипники. Особенность СО состоит в том, что вентиляторы установлены с разных стороны карты (один с лицевой, другой с оборотной). Замысел создателей прост и сложен одновременно:

Как видно по схеме, правый вентилятор продувает радиатор (ту его часть, куда выведены тепловые трубки) насквозь (через решетку на оборотной стороне). Нагретый воздух поднимается вверх, и его должен подхватить выдувной вентилятор в корпусе системного блока. Левый же вентилятор сразу выдувает горячий воздух за пределы корпуса сквозь отверстия в брекете карты. PCB имеет характерный вырез именно для эффективной работы правого вентилятора. Для эффективной работы такого кулера в корпусе должна быть организована хорошая вентиляция, потому что часть нагретого воздуха будет оставаться в корпусе. Впрочем, абсолютное большинство партнеров Nvidia выпускают карты с системами охлаждения, которые не выбрасывают воздух сразу за пределы корпуса, поэтому такая ситуация является на сегодняшний день совершенно привычной.

Демонтаж такой СО — тот еще квест. Nvidia даже выпустила руководство по корректному снятию и установке кулера. Нашему фотографу пришлось просто ювелирно потрудиться с тонким пинцетом, лупой и т. п.

Ряд разъемов демонстрируют богатую фантазию разработчиков.

Напомним, что обычно видеокарты останавливают свои вентиляторы в простое, при работе в 2D, если температура GPU опускается ниже примерно 60 градусов, и СО при этом становится бесшумной. В случае карты Nvidia GeForce RTX 3090 Founders Edition режим работы кулера иной: для остановки вентиляторов температура GPU должна быть ниже 50 °C, температура чипов памяти — ниже 80 °C, а энергопотребление самого GPU — ниже 35 Вт. Только при соблюдении всех трех условий вентиляторы остановятся. Ниже есть видеоролик на эту тему, где в конце вентиляторы все же останавливаются.

Мониторинг температурного режима с помощью MSI Afterburner:

После 6-часового прогона под нагрузкой максимальная температура ядра не превысила 70 градусов, что является великолепным результатом для видеокарты топового уровня.

Мы засняли и ускорили в 30 раз 8,5-минутный прогрев:

Максимальный нагрев наблюдался в центральной части PCB, причем, с учетом конфигурации системы охлаждения, нагревалась вся карта! Обратите внимание на разъем питания: его нагрев не выделялся на общем фоне, тогда как у других видеокарт на GeForce RTX 3090 два 8-контактных разъема нагреваются очень сильно (об этом мы расскажем в соответствующих обзорах).

Шум

Методика измерения шума подразумевает, что помещение шумоизолировано и заглушено, снижены реверберации. Системный блок, в котором исследуется шум видеокарт, не имеет вентиляторов, не является источником механического шума. Фоновый уровень 18 дБА — это уровень шума в комнате и уровень шумов собственно шумомера. Измерения проводятся с расстояния 50 см от видеокарты на уровне системы охлаждения.

Режимы измерения:

- Режим простоя в 2D: загружен интернет-браузер с сайтом iXBT.com, окно Microsoft Word, ряд интернет-коммуникаторов

- Режим 2D с просмотром фильмов: используется SmoothVideo Project (SVP) — аппаратное декодирование со вставкой промежуточных кадров

- Режим 3D с максимальной нагрузкой на ускоритель: используется тест FurMark

Оценка градаций уровня шума следующая:

- менее 20 дБА: условно бесшумно

- от 20 до 25 дБА: очень тихо

- от 25 до 30 дБА: тихо

- от 30 до 35 дБА: отчетливо слышно

- от 35 до 40 дБА: громко, но терпимо

- выше 40 дБА: очень громко

В режиме простоя в 2D температура была не выше 37 °C, вентиляторы не работали, уровень шума был равен фоновому — 18 дБА.

При просмотре фильма с аппаратным декодированием вентиляторы иногда запускались, но не раскручивались выше 500 об/мин, поэтому шум сохранялся на прежнем уровне.

В режиме максимальной нагрузки в 3D температура достигала 70 °C. Вентиляторы при этом раскручивались до 1300 оборотов в минуту, шум вырастал до 34,7 дБА: это отчетливо слышно, но еще не раздражает. В видеоролике ниже видно, как растет шум (шум фиксировался пару секунд через каждые 30 секунд).

Как и в случае с GeForce RTX 3080, с учетом того, сколько данная карта «кушает» (около 364 Вт в максимуме!), шум абсолютно приемлемый, и надо похвалить разработчиков, придумавших такую хитроумную СО.

Подсветка

Подсветка у карты одноцветная (белая), подсвечены логотип и «V»-образные полоски вдоль центрального «креста».

Подсветка не регулируется и не выключается. Благо она минимальная и не раздражает.

Подсветка имеется на обеих сторонах радиатора, питание ее светодиодов и вентиляторов разведено только с одной стороны, поэтому имеется хитроумный разъем для передачи питания на вторую сторону карты.

Комплект поставки и упаковка

Комплект поставки, кроме традиционного руководства пользователя, включает переходник питания на новый 12-контактный разъем с двух 8-контактных коннекторов.

Упаковка вызывает восторг, все очень стильно! Ощущение премиального продукта создается еще при виде коробки. Видео распаковки и восторгов — в начальном ролике :)

Тестирование: синтетические тесты

Конфигурация тестового стенда

- Компьютер на базе процессора Intel Core i9-9900K (Socket LGA1151v2):

- Компьютер на базе процессора Intel Core i9-9900KS (Socket LGA1151v2):

- процессор Intel Core i9-9900KS (разгон 5,1 ГГц по всем ядрам);

- ЖСО Cougar Helor 240;

- системная плата Gigabyte Z390 Aorus Xtreme на чипсете Intel Z390;

- оперативная память Corsair UDIMM (CMT32GX4M4C3200C14) 32 ГБ (4×8) DDR4 (XMP 3200 МГц) ;

- SSD Intel 760p NVMe 1 ТБ PCI-E;

- жесткий диск Seagate Barracuda 7200.14 3 ТБ SATA3;

- блок питания Seasonic Prime 1300 W Platinum (1300 Вт);

- корпус Thermaltake Level20 XT;

- операционная система Windows 10 Pro 64-битная; DirectX 12 (v.2004);

- телевизор LG 65NANO996NA (65″ 8K HDR);

- драйверы AMD версии 20.8.3;

- драйверы Nvidia версии 452.06/456.16/456.38;

- VSync отключен.

- Компьютер на базе процессора Intel Core i9-9900KS (Socket LGA1151v2):

Тесты GeForce RTX 3090 проводились с выводом картинки на новейший телевизор LG 65NANO996NA, имеющий разрешение 7680×4320, то есть 8К.

8K-матрица телевизора LG Nano99 65″ 8K NanoCell состоит из 33 миллионов пикселей (99 млн субпикселей). Для качественного изображения в 8K важно фактическое число пикселей, но еще важнее, чтобы каждый пиксель был отдельным и отличимым для глаза. Такие телевизоры положили начало новому поколению продуктов и услуг с маркировкой 8K Ultra HD, которые обеспечивают четкость в четыре раза выше, чем у 4K-телевизоров, и в 16 раз выше, чем у Full HD-моделей. Телевизоры LG NanoCell 2020 года создают чистые цвета благодаря мельчайшим наночастицам, которые отфильтровывают некорректные цвета и усиливают чистоту цвета, так что виртуальный мир превращается в настоящую реальность. А благодаря функции Motion Pro вы видите все быстрые и малейшие движения каждого игрока в спортивных соревнованиях без размытости.

NanoCell-телевизоры LG — интеллектуальные. Функция распознавания голоса позволяет управлять интерфейсом SmartTV и контролировать умный дом при помощи технологии LG ThinQ. Также они обеспечивают оптимальное качество HDR-изображения с поддержкой основных форматов HDR, включая HDR 10 и HLG Pro. Dolby Vision IQ грамотно настраивает яркость, цвет и контрастность экрана в зависимости от жанра контента и условий освещения.

Телевизоры LG NanoCell получили сертификат «светобиологической безопасности светодиодов» Underwriters Laboratories (UL), подтверждающий, что излучение от экрана не вредит глазам. В ходе испытаний на светобиологическую безопасность светодиодов оценивается пять показателей: синий свет, актиничное УФ-излучение, ближнее УФ-излучение, инфракрасное излучение и опасность ожога сетчатки глаза. Эти показатели официально утверждены МЭК (Международной электротехнической комиссией) для оценки уровня опасности излучения светодиодов для тела человека. Телевизоры NanoCell превзошли требования по всем показателям.

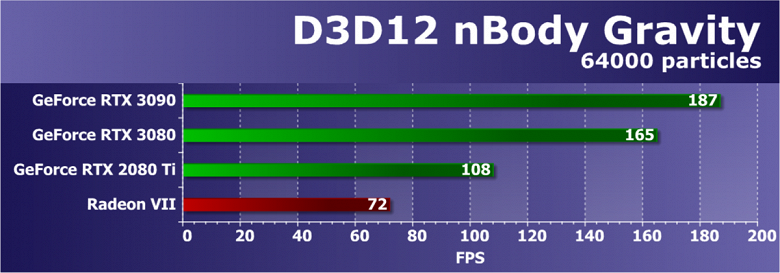

Мы провели тестирование видеокарты GeForce RTX 3090 со стандартными частотами в нашем наборе синтетических тестов. Он продолжает постоянно меняться, добавляются новые тесты, а некоторые устаревшие постепенно убираются. Мы бы хотели добавить еще больше примеров с вычислениями, но с этим есть определенные сложности. Постараемся расширить и улучшить набор синтетических тестов, и если у вас есть четкие и обоснованные предложения — напишите их в комментариях к статье или отправьте авторам.

Начиная с этого обзора мы полностью отказались от ранее активно использовавшихся нами тестов RightMark3D, так как они устарели слишком сильно, и на столь мощных GPU или не запускаются вообще, или упираются в различные ограничители, не загружая работой блоки графического процессора и не показывая его истинную производительность. А вот синтетические Feature-тесты из набора 3DMark Vantage мы все еще оставили в полном составе, так как заменить их попросту нечем, хотя и они уже изрядно устарели.

Из более-менее новых бенчмарков мы начали использовать несколько примеров, входящих в DirectX SDK и пакет SDK компании AMD (скомпилированные примеры применения D3D11 и D3D12), а также несколько разнообразных тестов для измерения производительности трассировки лучей, программной и аппаратной. В качестве полусинтетического теста у нас также используется и довольно популярный 3DMark Time Spy, а также некоторые другие — например, DLSS и RTX.

Синтетические тесты проводились на следующих видеокартах:

- GeForce RTX 3090 со стандартными параметрами (RTX 3090)

- GeForce RTX 3080 со стандартными параметрами (RTX 3080)

- GeForce RTX 2080 Ti со стандартными параметрами (RTX 2080 Ti)

- GeForce RTX 2080 Super со стандартными параметрами (RTX 2080 Super)

- GeForce RTX 2080 со стандартными параметрами (RTX 2080)

- Radeon VII со стандартными параметрами (Radeon VII)

- Radeon RX 5700 XT со стандартными параметрами (RX 5700 XT)

Для анализа производительности новой видеокарты GeForce RTX 3090 мы выбрали несколько видеокарт из прошлого поколения компании Nvidia. Для сравнения с относительно аналогичным по позиционированию решением взяли RTX 2080 Ti — как самое дорогое решение предыдущего семейства Turing, если не брать сверхдорогой Titan RTX. Также есть на диаграммах и результаты RTX 2080 (или Super-варианта), просто для подтверждения того, как изменилась производительность GPU новой архитектуры.

У компании AMD соперников для GeForce RTX 3090 в нашем сегодняшнем сравнении снова просто не существует. Ждем конца октября, когда новые Radeon будут объявлены, а скорее даже ноября, когда они появятся у нас на тестах. Ну а пока нам ничего не остается, кроме как снова сравнивать новинки Nvidia с парой видеокарт: результаты Radeon VII присутствуют в качестве самого быстрого решения, хоть уже и давно исчезнувшего из продажи, а также есть Radeon RX 5700 XT — наиболее производительный графический процессор архитектуры RDNA первого поколения.

Тестирование: профессиональные тесты

Тестирование: игровые тесты

Список инструментов тестирования

Во всех играх использовалось максимальное качество графики в настройках.

- Gears 5 (Xbox Game Studios/The Coalition)

- Wolfenstein: Youngblood (Bethesda Softworks/MachineGames/Arkane Studios)

- Death Stranding (505 Games/Kojima Productions)

- Red Dead Redemption 2 (Rockstar)

- Star Wars Jedi: Fallen Order (Electronic Arts/Respawn Entertainment)

- Control (505 Games/Remedy Entertainment)

- Deliver Us The Moon (Wired Productions/KeokeN Interactive)

- Resident Evil 3 (Capcom/Capcom)

- Shadow of the Tomb Raider (Eidos Montreal/Square Enix), HDR включен

- Metro Exodus (4A Games/Deep Silver/Epic Games)

Стандартные результаты тестов без использования аппаратной трассировки лучей в разрешениях 1920×1200, 2560×1440 и 3840×2160

Как мы ранее писали, в новом поколении GeForce RTX 30 улучшены технологии RTX (расчет освещения с помощью трассировки лучей) и DLSS (интеллектуальная реализация антиалиасинга, обсчитываемая тензорными ядрами). Но поскольку конкурирующие решения AMD данные технологии на сегодня не поддерживают, мы пока вынуждены для массового тестирования отключать как трассировку, так и DLSS для получения адекватного сравнения всех карт. Поэтому теперь мы будем проводить тесты не только с использованием обычных методов растеризации, но и с включением RTX, а в ряде игр — и DLSS. Разумеется, во втором случае видеокарты Nvidia придется сравнивать только с другими видеокартами Nvidia. Для этого дополнительного тестирования мы взяли 4 игры, где технологии RTX и DLSS уже обкатаны.

Результаты тестов с включенной аппаратной трассировкой лучей и DLSS в разрешениях 1920×1200, 2560×1440 и 3840×2160

Хорошо видно, что, во-первых, серия карт GeForce RTX 30 обрабатывает RTX и DLSS 2.0 более эффективно, чем предыдущая: прироста производительности у GeForce RTX 30 относительно GeForce RTX 20 выше, нежели в тестах без RTX/DLSS. Во-вторых, работа новой версии DLSS вызывает восторг, поскольку, в отличие от традиционных методов АА, здесь мы видим либо незначительное падение производительности, либо и вовсе отсутствие такого падения. При этом, как мы уже писали в материалах по исследованию новых технологий Nvidia, на качестве картинки применение DLSS почти не сказывается.

А теперь совершенно новое: добавляем тесты в разрешении 8К!

Выше мы уже говорили, что видеокарта GeForce RTX 3090 — не совсем игровое решение, поэтому у нее такой огромный объем памяти, и поэтому она может себе позволить иметь столь высокую стоимость. Однако если ее предшественник Titan RTX все же был чисто профессиональным решением, то GeForce RTX 3090 может использоваться в обеих ипостасях. И ее мощь уже позволяет засматриваться на разрешение, максимально возможное на сегодня для стандартных способов вывода — 8К. Пока с таким разрешением можно найти только телевизоры, причем весьма дорогие (однако и сама GeForce RTX 3090 стоит почти как 8К-телевизор), а 8К-мониторов, наверное, не будет еще долго. Впрочем, практически все 8К-телевизоры могут выдавать игровую картинку не хуже мониторов, в том числе с правильным и полноценным HDR.

Совсем недавно вышли обновления драйверов, добавившие поддержку DLSS в 8К, так что мы провели тестирование в трех играх с участием RTX/DLSS (8К-телевизор был в нашем распоряжении не так долго, времени на большее число тестов просто не хватило).

Результаты тестов с включенной аппаратной трассировкой лучей и DLSS в разрешении 7680×4320

Можно смело сказать, что на GeForce RTX 3090 в протестированные игры можно играть в 8К при активном DLSS. Будем ждать выхода новых игр, где DLSS позволит получить комфорт при игре в 8К на максимальных настройках.

Рейтинг iXBT.com

Рейтинг ускорителей iXBT.com демонстрирует нам функциональность видеокарт друг относительно друга и нормирован по самому слабому ускорителю — Radeon RX 550 (то есть сочетание скорости и функций Radeon RX 550 приняты за 100%). Рейтинги ведутся по 28 ежемесячно исследуемым нами акселераторам в рамках проекта Лучшая видеокарта месяца. В данном случае из общего списка выбрана группа карт для анализа, в которую входят GeForce RTX 3090 и его конкуренты.

Для расчета рейтинга полезности использованы розничные цены на конец сентября 2020 года. Рейтинг приведен суммарно для всех трех разрешений.

| № | Модель ускорителя | Рейтинг iXBT.com | Рейтинг полезности | Цена, руб. |

|---|---|---|---|---|

| 01 | RTX 3090 24 ГБ, 1395—1995/19500 | 2330 | 155 | 150 000 |

| 02 | RTX 3080 10 ГБ, 1440—1995/19000 | 2080 | 306 | 68 000 |

| 03 | RTX 2080 Ti 11 ГБ, 1350—1950/14000 | 1740 | 223 | 78 000 |

| 04 | RTX 2080 Super 8 ГБ, 1650—1965/15500 | 1520 | 284 | 53 500 |

| 07 | Radeon VII 16 ГБ, 1400—1750/2000 | 1170 | 244 | 48 000 |

Полагаем, что комментарии излишни, и снова приветствуем нового лидера 3D-графики игрового класса! Но все же отметим, что GeForce RTX 3090 позиционируется не только для игр, поэтому чисто игровой флагман на сегодня — GeForce RTX 3080.

Рейтинг полезности

Рейтинг полезности тех же карт получается, если показатели предыдущего рейтинга разделить на цены соответствующих ускорителей. Учитывая возможности карты и ее явную нацеленность на использование в высоких разрешениях, приводим рейтинг только для разрешения 4К (поэтому цифры в рейтинге отличаются).

| № | Модель ускорителя | Рейтинг полезности | Рейтинг iXBT.com | Цена, руб. |

|---|---|---|---|---|

| 04 | RTX 3080 10 ГБ, 1440—1995/19000 | 591 | 4021 | 68 000 |

| 07 | RTX 2080 Super 8 ГБ, 1650—1965/15500 | 482 | 2578 | 53 500 |

| 09 | Radeon VII 16 ГБ, 1400—1750/2000 | 413 | 1982 | 48 000 |

| 10 | RTX 2080 Ti 11 ГБ, 1350—1950/14000 | 390 | 3040 | 78 000 |

| 11 | RTX 3090 24 ГБ, 1395—1995/19500 | 314 | 4713 | 150 000 |

В случае GeForce RTX 3080 мы вполне искренне восторгались результатами, так как этот ускоритель свою рекомендованную цену оправдывал на все сто. Здесь же ситуация привычная для самых топовых ускорителей: очень высокая производительность, но перевешивающая ее невероятно высокая цена. Впрочем, рейтинг полезности не учитывает позиционирование и пригодность ускорителей для профессионального применения, не говоря уже об особенностях конкретных видеокарт (габариты, охлаждение, шум, набор видеовыходов, энергопотребление и пр.).

Выводы

Ранее в нашем материале мы подвели итог, что новый видеоускоритель Nvidia GeForce RTX 3080 не просто отлично подходит для 4К — он уже позволяет комфортно играть в этом разрешении при максимальных настройках графики со включенной трассировкой лучей. А при использовании «умных ядер» для реализации DLSS падение производительности от включения RTX может быть полностью (и даже с излишком) компенсировано по сравнению с тем, что мы имеем без RTX+DLSS.

Разумеется, Nvidia GeForce RTX 3090 поднимает и эту планку, опережая GeForce RTX 3080 в играх в среднем на 11%-14%. Как и в случае GeForce RTX 3080, мы видим наибольший прирост производительности относительно предыдущего поколения при использовании RTX и DLSS (вполне возможно, что вскоре на базе тензорных ядер появятся и иные реализации).

Реализация трассировки лучей в играх стала более совершенной (годы отладки не прошли даром!), и падение производительности уже не такое драматичное, каким оно было при запуске этой технологии 2 года назад, вызвавшем разочарование у многих. Теперь же, с учетом того, что трассировка лучей будет поддерживаться и новыми игровыми консолями, мы видим, что индустрия приняла данную технологию как стандарт, и будет появляться все больше игр с RTX. К тому же, мы ожидаем поддержку данной технологии даже в решениях конкурентов (разумеется, в несколько другом аппаратном исполнении).

Изюминка нового ускорителя — реальная поддержка разрешения 8К, поскольку GeForce RTX 3090 обладает достаточной производительностью, чтобы некоторые игры с использованием DLSS обеспечивали игроку приемлемый комфорт на максимальных настройках графики в 8К. А объем памяти у новинки позволит свободно хранить необходимые текстуры и данные даже для столь высокого разрешения. От GeForce RTX 3080, как и от GeForce RTX 2080 Ti, такого ждать не приходится, их производительность в 8K будет на грани минимальной играбельности — в том числе из-за ограничения локальной видеопамяти объемом 10-11 ГБ. В видеоролике выше можно в конце увидеть всего 25-28 fps в 8К — это был запуск Metro Exodus без DLSS, с которым производительность вырастает более чем в 2 раза (как мы показали выше).

И все же GeForce RTX 3090 нацелен не на игровой сегмент, а на использование в профессиональной сфере — например, для 3D-моделирования. И мы убедились, что объем памяти в 24 ГБ позволяет этому ускорителю легко работать с высококачественными, очень сложными моделями, тогда как на GeForce RTX 3080 реализация тех же сценариев может приводить к падению программы или вызывать ошибку нехватки памяти. Так что GeForce RTX 3090 — это одновременно и самое быстрое на сегодня игровое решение, и профессиональное. Понятно, что стоимость в 1500 долларов — это очень много. А с учетом налогов и новизны продукта первые такие карты могут стоить в России и все 150 тысяч рублей, а то и выше. Но повторим: это нишевый ускоритель.

Что касается конкретной видеокарты Nvidia GeForce RTX 3090 Founders Edition (24 ГБ), то она великолепна с точки зрения потребительских характеристик. Шум есть, но не слишком высокий, СО очень эффективная. Видеокарта занимает три слота в системном блоке, но не экстремально длинная (320 мм), да никто и не будет ставить такую карту в компактный системный блок.

Надо отметить наличие у видеокарты нестандартного пока 12-контактного разъема питания, однако для него имеется переходник в комплекте поставки, а производители БП вскоре предоставят соответствующие решения. Система охлаждения, помимо того, что не слишком шумная (а без нагрузки вообще бесшумная), еще и частично удаляет нагретый воздух за пределы системного блока — ранее этим могли похвастать лишь видеокарты с так называемыми радиальными вентиляторами, которые были, как правило, очень шумными. Добавим еще пару слов о подставках (кронштейнах) для установки карты, которыми стали снабжать свои GeForce RTX 3080/3090 некоторые производители. В данном случае подставка, на наш взгляд, не нужна: у видеокарты очень широкая крепежная планка под три винта на заднюю панель корпуса, а радиатор кулера образует большую металлическую раму, так что карта не будет прогибаться под своей тяжестью и не будет испытывать слот PCIe на прочность. Кстати, карты GeForce RTX 30 поддерживают PCIe 4.0, но об этом мы как-нибудь поговорим в одном из обзоров серийных карт.

В заключение еще раз констатируем: GeForce RTX 3090, как и GeForce RTX 3080, отлично подходит для игры в разрешении 4К как с RTX, так и без трассировки лучей (и, разумеется, с максимальными настройками качества графики). А GeForce RTX 3090 может вытянуть игру еще и в разрешении 8К.

В номинации «Оригинальный дизайн» карта Nvidia GeForce RTX 3090 Founders Edition (24 ГБ) получила награду:

Благодарим компанию Nvidia Russia

и лично Ирину Шеховцову

за предоставленную на тестирование видеокарту

Для тестового стенда:

блок питания Seasonic Prime 1300 W Platinum предоставлен компанией Seasonic