Самые интересные анонсы и события

Содержание

- Введение

- Планы по выпуску графических и мобильных процессоров

- Платформа для ARM- и CUDA-разработчиков Kayla

- Решение для визуальных вычислений GRID VCA

- Планы и анонсы по суперкомпьютерам и и Big Data

- GPU-ускоренная трассировка лучей в Iray 2013

- Решения для автомобильных информационно-развлекательных систем

- Новые демонстрационные программы

Введение

Компания Nvidia добивается неплохих результатов и успехов на разных рынках: кроме традиционного для них рынка игровых графических процессоров, а также профессиональной графики, они очень хорошо работают на рынках процессоров для суперкомпьютерных вычислений, мобильных устройств и автомобильных развлекательно-информационных систем. Неудивительно, что интерес к вычислениям на графических процессорах с 2008 года серьезно возрос, как и количество практических применений.

Несколько лет назад Nvidia доросла до того, чтобы организовать свое собственное крупное мероприятие, посвященное различным аспектам использования графических процессоров в разных сферах деятельности человека. Прошедшая в конце марта этого года очередная ежегодная конференция компании Nvidia называется GPU Technology Conference 2013. Это мероприятие (точнее, его американское воплощение; есть еще азиатское) традиционно проходит в городе Сан-Хосе, штат Калифорния, и мы уже неоднократно писали о нем в прошлые годы. Это уже четвертая подобная конференция Nvidia, прошедшая в США.

Вот уже который раз мероприятие проводится в привычном выставочном центре San Jose McEnery Convention Center. В этот раз первая фотография с выставки получилась не слишком приглядной — выставочный центр сейчас серьезно расширяется, а в другой его части проходит реконструкция, следы которой видны на приведенной фотографии.

В качестве небольшого лирического отступления признаемся, что российским журналистам и представителям участвующих в конференции компаний, прибывшим в Сан Хосе на GTC 2013 в середине весны этого года, было очень приятно побывать в настоящей весне, а не снежной полузиме, которая до сих пор держится во многих городах России. В Калифорнии в это время везде цветут деревья и другие растения, что не могло не радовать и не настраивать на позитивный лад.

Хотя первый день работы конференции обычно не отличается большим количеством мероприятий и анонсов, во время него проходят некоторые интересные технические сессии «для разгона» — введения посетителей в последующий ритм. Автор отчета посетил несколько таких сессий, посвященных различным применениям GPU в индустрии. Также было интересно начать (именно начать!) знакомиться с огромным количеством стендов и плакатов, размещенных на территории выставочного стенда.

Но не только техническими сессиями отличился первый день GTC 2013. Также компания Nvidia объявила о том, что программисты, использующие язык Python, смогут применять GPU-ускорение, основанное на CUDA, в своих приложениях с вычислениями и анализом больших объемов данных. Язык Python является одним из самых популярных языков программирования и позволяет писать высокоуровневый программный код. Библиотеки и возможности Python хорошо подходят для многих научных и инженерных задач, и возможность их ускорения на GPU приведет к появлению новых приложений.

CUDA поддерживается в NumbaPro — компиляторе Python из нового продукта Anaconda Accelerate компании Continuum Analytics. Поддержка GPU-ускорения в Python стала результатом внедрения кода компилятора CUDA в ядро популярной компиляторной инфраструктуры с открытым кодом LLVM. Эта инфраструктура позволяет сравнительно просто добавлять поддержку GPU-ускорения в языки общего и специального назначения.

Планы по выпуску графических и мобильных процессоров

В рамках конференции традиционно проходят ключевые выступления главы компании Nvidia — Дженсена Хуанга, а также партнеров компании. Эти выступления всегда интересны, а на GTC они обычно еще и содержат множество анонсов, первых данных о будущих продуктах компании и намеков на выбранный Nvidia путь. 19 марта, во второй день работы конференции, глава Nvidia приоткрыл завесу сразу над несколькими будущими продуктами компании.

На одном из первых же показанных на выступлении интересных слайдов были опубликованы планы по выпуску графических процессоров — основного направления компании. Вместе с этим, были показаны и предыдущие продукты Nvidia, предназначенные, в том числе для неграфических вычислений. Так, еще в 2008 году компанией был анонсирован первый продукт с поддержкой CUDA — видеочип с кодовым именем Tesla, также известный как G80 или Geforce GTX 8800. Через еще два года вышел Fermi, в котором была улучшена поддержка FP64, а в 2012 появилось нынешнее поколение графических процессоров компании — первый из чипов архитектуры Kepler, которая отличается динамическим параллелизмом.

А вот дальше на диаграмме показано самое интересное. Следующие два GPU компании планируются к выпуску в будущем, причем лишь про ближайший известно, что он появится ориентировочно в 2014 году. Процессор Maxwell будет отличаться поддержкой унифицированной виртуальной памяти, доступ к которой будет и у GPU, и у CPU, что упростит программирование сложных задач в будущем. А после Maxwell выйдет еще один чип, анонсированный сегодня и получивший название Volta — в честь Алессандро Вольта, итальянского физика и химика, одного из основоположников учения об электричестве.

Новый чип будет еще более энергоэффективным, чем все предыдущие, но не в этом его самая интересная особенность. В Volta ожидается применение новой технологии «многослойной» памяти под названием stacked DRAM — при которой применяется трехмерная компоновка интегральных микросхем, когда GPU и память помещены друг на друга в несколько слоев, соединенных между собой.

Таким образом предполагается помочь в решении одной из важнейших проблем производительности GPU — повысить скорость доступа к данным, которая зачастую ограничивает общую производительность. В графических процессорах поколения Volta планируется достичь пропускной способности памяти порядка 1 терабайта в секунду. Дженсен привел такой очень наглядный пример: данные с заполненного диска Blu-ray с такой скоростью можно передать за 1/50 секунды.

Но это были не единственные планы, раскрытые на GTC 2013. Рассказал Дженсен и о будущих мобильных чипах семейства Tegra. Общеизвестно, что Nvidia уже давно (и совершенно оправданно, к слову) сделала ставку на мобильные решения, которые вытесняют своего старшего брата ПК во многих применениях. Nvidia развивает направление чипов, которые применяются в автомобилях, телефонах, планшетах, часах и т. п. Причем Дженсен признает, что первое поколение Tegra, по сути, провалилось — оно не нашло широкого применения в мобильных решениях, став лишь полигоном для будущих процессоров компании.

Зато все остальные решения привносили на рынок что-то новое. Tegra 2 стала первым двухъядерным мобильным чипом, Tegra 3 — первым четырехъядерным, имеющим вспомогательное пятое ядро с низким потреблением энергии. В семействе чипов Tegra 4 появился интегрированный программный модем и применена технология вычислительной фотографии, которая использует сложные алгоритмы, нагружающие CPU и GPU, и позволяет создать интересные эффекты, вроде постоянно включенного HDR для фотоснимков и видеозаписей.

А что планируется дальше? Следующий мобильный чип семейства Tegra называется Logan, и он будет отличаться очень производительным и функциональным GPU с поддержкой CUDA. Наконец-то в Logan будет добавлено видеоядро, основанное на архитектуре Kepler, обладающее полной поддержкой последней версии CUDA 5, а также OpenGL 4.3.

Logan начнет производиться в начале следующего года, но уже сейчас Nvidia называет и его преемника — решение с кодовым именем Parker, в котором появится еще несколько нововведений. Этот чип будет первым решением на основе проекта Denver — собственного 64-битного ARM-ядра компании Nvidia, объединенного с видеоядром архитектуры Maxwell. Также это решение должно отличиться использованием FinFET-транзисторов, что позволит значительно увеличить производительность будущих чипов семейства Tegra.

Платформа для ARM- и CUDA-разработчиков Kayla

Журналисты давно расспрашивали Nvidia, когда будет создана мобильная однокристальная система Tegra с графическим ядром, способным в том числе и на неграфические вычисления, но тот же Дженсен всегда отмалчивался, отвечая, что мобильный чип с мощной графикой и поддержкой неграфических вычислений на GPU когда-нибудь обязательно появится. И вот, в Logan они его наконец-то пообещали.

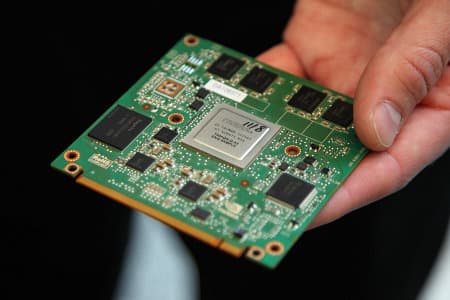

Но разработчикам приложений хочется получить такие возможности уже сейчас, чтобы быть готовым к будущему и предоставить соответствующее ПО пользователям как можно раньше, и они просят Nvidia дать им подобные решения прямо сегодня. Для них Nvidia придумала решение под названием Kayla — оно основано на ARM-совместимом чипе уровня Tegra 3 и с графическим процессором GK107 (или GK208?) на базе архитектуры Kepler, обладающим низким энергопотреблением.

Будущий чип Logan с подобными возможностями будет иметь размер монетки, а Kayla — это плата размером с планшет. Существует две версии Kayla, одна показана на фото выше, она имеет встроенный чип GK107, а вторая версия отличается слотом PCI Express, в который можно будет поставить другую видеокарту компании.

Понятно, что эти решения способны на все то, что будут уметь будущие мобильные чипы, вроде трассировки лучей в реальном времени, обработки физики при помощи PhysX и всего остального, что умеет делать CUDA5-совместимое решение. Из графических API будет поддерживаться OpenGL 4.3 и DirectX 11, так как тесселяция и вычислительные шейдеры также поддерживаются.

Эта плата обладает возможностями и производительностью, примерно схожими с теми, что имеют нынешние ноутбуки. Платы Kayla нужны, чтобы разработчики получили представление о том, что их ждет в ближайшем будущем с мобильными SoC уровня Logan и более новыми. Сильно облегчает работу то, что портирование кода на Kayla занимает лишь несколько дней. В качестве такого примера на GTC 2013 был приведен рендерер Optix, использующий ускорение трассировки лучей на GPU, а также и другие приложения:

Естественно, что решения вроде Kayla не нужны и не интересны массам. Но они обязательно понравятся разработчикам, так как позволяют получить возможности будущих мобильных чипов прямо сейчас, не дожидаясь того же Logan. А нам остается надеяться, что они воспользуются таким шикарным предложением — Nvidia всегда отличалась внимательным подходом при общении с разработчиками.

Решение для визуальных вычислений GRID VCA

По ходу мероприятия GTC компания представила Visual Computing Appliance (VCA) — первое в индустрии решение для визуальных вычислений, обеспечивающее высокую графическую производительность для удаленных клиентов, работающих в Windows, Linux и MacOS (в будущем планируется добавление клиентов для Android и iOS). GRID VCA — это законченное решение, обеспечивающее GPU-ускорение для виртуальных машин, предназначенное для компаний малого и среднего бизнеса, обладающих ограниченными возможностями собственной IT-инфраструктуры.

GRID VCA позволяет удаленно запускать такие требовательные к ресурсам ПК программы, как приложения компаний Adobe, Autodesk и Dassault Systemes. Ускорение графики на удаленном GPU обеспечивает пользователям клиентских ПК практически такие же возможности по работе с графикой, что и выделенные мощные графические станции. Используя новое решение Nvidia, пользователи могут создать виртуальные машины (workspace — рабочее пространство), которые создаются под конкретные задачи, их можно добавлять, удалять или перераспределять. На каждый клиент нужно будет просто установить специальное ПО — GRID client.

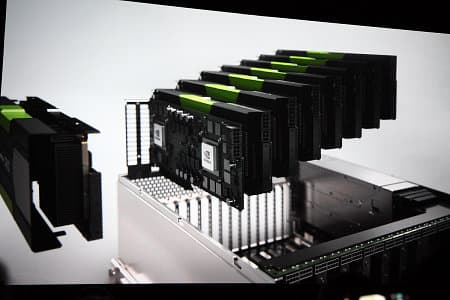

С серверной стороны используется простая в установке и использовании система форм-фактора 4U, содержащая 8 или 16 графических процессоров Nvidia и соответствующее программное обеспечение GRID VGX. Система обеспечивает графическую производительность на уровне одиночных решений Nvidia Quadro для 16 пользователей. То есть на клиентской стороне достаточно простеньких ПК даже со встроенной графикой, но работать они будут с тяжелыми приложениями, такими как Autodesk 3ds Max или Maya, например.

Такое решение будет особенно полезно для небольших студий компьютерного дизайна, киностудий и других подобных компаний, которые смогут сравнительно просто использовать графически интенсивные приложения, получая высокую производительность даже при удаленной работе. GRID VCA уже получила определенную поддержку в этой индустрии. Удаленное ускорение на GPU позволило обеспечить работу без необходимости конфигурирования рабочих станций и избежать лишнего переноса данных.

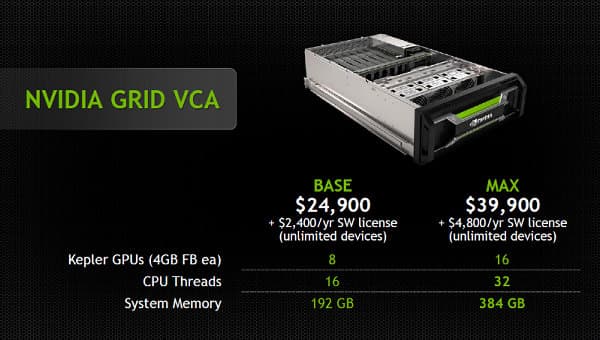

Nvidia GRID VCA будут доступны в США в мае текущего года, и данное решение будет представлено в двух модификациях: базовой и максимальной. В базовую входит 8 графических процессоров (по 4 ГБ видеопамяти на каждый) и 16 потоков CPU, а в максимальную вдвое больше: 16 графических процессоров и 32 потока CPU. Физически это соответствует двум восьмиядерным процессорам Intel Xeon, а также восьми платам с двумя графическими процессорами архитектуры Kepler на каждом. Оперативной памяти установлено 192 и 384 ГБ соответственно (по 24 ГБ на каждую виртуальную систему).

Так как GRID VCA ориентирована, прежде всего, на предприятия среднего и малого бизнеса (корпоративный рынок), то и цены у систем соответствующие. Базовая версия с 8 GPU будет продаваться по цене в $24 900 (плюс ежегодная неограниченная лицензия на ПО за $2400, а максимальная — за $39 900 (плюс $4800 за лицензии на ПО в год). Подробнее со всеми деталями о GRID VCA можно ознакомиться на странице компании.

Остается напомнить, что платформу Nvidia GRID поддержали многие участники облачных игровых сервисов, таких как Agawi (США), Cloud Union (Китай), Cyber Cloud Technologies (Китай), G-cluster Global (Япония), Playcast Media Systems (Израиль) и Ubitus (Тайвань). Эти международные компании, работающие в сфере облачных игр, планируют использовать платформу Nvidia GRID при предоставлении услуг новых игровых сервисов.

На ключевом выступлении Дженсена Хуанга была вживую показана работа GRID VCA. На Apple MacBook Pro были запущены три разных «рабочих пространства», каждое со своим ПО, в т. ч. не существующим в версиях для Apple — это еще одно применение виртуализации графического ускорения.

Также на этом мероприятии в поддержку GRID VCA высказались некоторые представители индустрии, в т. ч. Gian Paolo Bassi, вице-президент компании SolidWorks в сфере научно-исследовательских работ. Он рассказал, что ПО его компании используется для проектирования разнообразной продукции, начиная от медицинских приборов и заканчивая космическими кораблями. Всего их программы использует 180 тысяч компаний в 80 странах.

В числе выступавших был James Fox, президент компании Dawnrunner, которая является одним из первых пользователей GRID — они используют его для запуска программ Adobe и Autodesk. Но самым зрелищным выступлением выделились «киношники», конечно же. Компьютерная графика давно используется в голливудских фильмах. К примеру, в кинофильме «Жизнь Пи» в кадре почти постоянно находится тигр, и он практически во всех сценах смоделирован при помощи компьютерной графики.

Но на сцене были другие представители индустрии: Jules Urbach — основатель и генеральный директор компании Otoy, и Josh Trank — режиссер обещанного на 2015 год перезапуска фильма «Фантастическая четверка». Они вкратце рассказали о том, как используют компьютерную 3D-графику для визуальных эффектов в своих фильмах. Особенное внимание уделялось предварительной визуализации, в которой теперь им помогает использование GPU для рендеринга качественной картинки с трассировкой лучей.

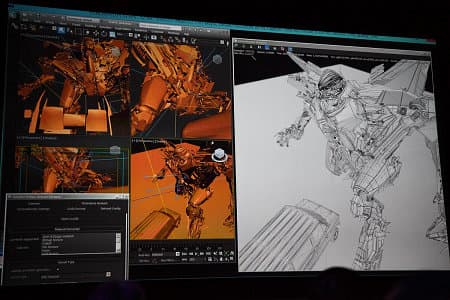

Директор Otoy показал работу Octane Render на примере сцены из «Трансформеров», которую помогала делать их компания, используя всего лишь рабочий ноутбук. При этом рендерер использовал для просчета сцены 112 графических процессоров, расположенных на удаленном сервере аж в Лос-Анджелесе. Сначала была показана сцена с рендерингом в каркасном режиме, как обычно работают с одним GPU на рабочей станции…

…а затем та же сцена была очень качественно отрендерена более чем сотней графических процессоров. Менее чем за секунду — в отличие от нескольких часов, которые занимал рендеринг в предыдущие годы!

Причем при использовании виртуализации графических вычислений можно работать с подобным качеством предпросмотра за своим ноутбуком чуть ли не в любой стране мира, получая удаленную вычислительную мощь сотен, а то и тысяч GPU. Неудивительно, что киноиндустрия принимает Nvidia GRID и GRID VCA с таким воодушевлением, эти решения отлично подходят для них.

Планы и анонсы по суперкомпьютерам и и Big Data

Вполне логично, что на GTC 2013 не обошлось без многочисленных упоминаний о суперкомпьютерах, основанных на ускорителях вычислений в виде мощных графических процессоров производства компании Nvidia. Упоминание решений уровня Titan было неоднократным, ведь графические процессоры сейчас помогают решать множество сложных задач по анализу и обработке больших объемов данных.

К примеру, такие компании, как Shazam, Salesforce.com и Cortexica уже применяют графические процессоры Nvidia для того, чтобы решать все более массивные задачи анализа и поиска в потребительских и коммерческих приложениях. Указанные выше компании применяют современные GPU при обработке больших массивов данных и в сложных алгоритмах, требующих высокопроизводительных вычислений, они используют графические ускорители Nvidia Tesla для поиска и анализа аудиоданных, текстовых данных и при распознавании изображений. Все чаще именно GPU производства Nvidia занимают место в суперкомпьютерах в качестве ускорителей:

По данным компании, около 20% мощности всего списка быстрейших суперкомпьютеров Top500, включая самый мощный из них — Titan, расположенный в Окриджской национальной лаборатории, обеспечивают именно GPU. Всего в суперкомпьютере Titan работает 40 миллионов CUDA-ядер, и все вместе они обеспечивают производительность в 10 petaflops.

На GTC 2013 был объявлено, что еще один мощнейший суперкомпьютер будет использовать графические процессоры Nvidia. Швейцарский суперкомпьютерный центр (CSCS) собирается построить один из самых быстрых в Европе суперкомпьютеров — Cray XC30, предназначенный для прогнозирования погоды и названный по имени горы в Альпах — Piz Dant. В новом европейском суперкомпьютере будут использоваться ускорители вычислений Nvidia Tesla K20X, и это обеспечит ему одно из первых мест среди европейских суперкомпьютеров в начале 2014 года.

Прогнозирование погоды и моделирование климата очень сложно и требует огромных вычислительных возможностей. Центр CSCS работает вместе с MeteoSwiss, предоставляющим услуги прогноза погоды с высокой точностью. Швейцарский центр будет использовать мощность в 1 petaflop для ускорения таких вычислений, а также для астрофизики и других научных применений. Прогнозирование погоды — идеальная задача для ускорения на GPU, и их применение позволит выполнять соответствующие расчеты быстрее систем на базе исключительно CPU.

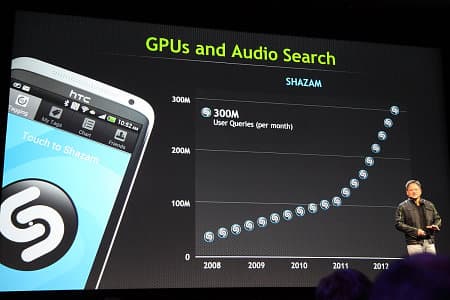

Всё большее количество мобильных и коммерческих приложений сталкиваются с проблемами серьезного роста потребностей в вычислительных мощностях, поэтому разработчики и поставщики услуг используют мощь графических ускорителей для расширения инфраструктуры в соответствии с потребностями рынка. Например, практически все знают мобильное приложение Shazam — одно из самых популярных приложений в Apple Store и Google Play. Но мало кто в курсе того, что эта компания использует графические процессоры Nvidia для быстрого поиска и распознавания музыкальных композиций по базе данных, содержащей несколько десятков миллионов аудиозаписей. Миллионы пользователей записывают на телефоны и планшеты отрывки звучащих композиций, чтобы узнать их название.

Shazam растет очень быстро, пользователи ищут более 10 миллионов песен в день, и к сервису постоянно подключаются все новые и новые пользователи. Чтобы успеть за ростом потребностей, в Shazam решили ускорить процесс поиска и сравнения, используя графические процессоры Tesla. GPU позволяют им обрабатывать огромные объемы данных при сравнительно низких затратах и предоставляют возможность масштабируемого роста — об этом рассказал Jason Titus, технический директор Shazam Entertainment.

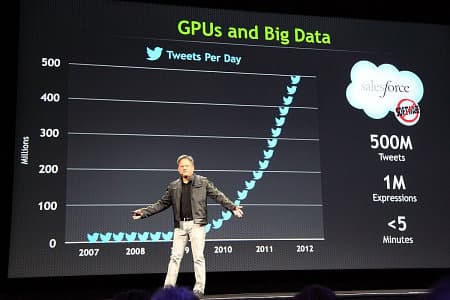

Почти то же самое относится и к анализу сообщений Twitter в реальном времени, которое требует огромных вычислительных возможностей. Компания Salesforce.com использует графические процессоры Nvidia, чтобы помочь крупным брендам с мониторингом и анализом более 500 миллионов ежедневных твитов в поисках упоминаний соответствующих брендов, продуктов и услуг.

Именно современные графические процессоры Nvidia позволяют Salesforce.com получать данные раньше, чем это делают аналогичные системы, использующие анализ исключительно на CPU. Кроме того, графические процессоры позволяют компании быстро и просто масштабировать объем предоставляемых услуг.

Еще одним интересным применением GPU в высокопроизводительных вычислениях является мобильное приложение Cortexica. Оно позволяет пользователям находить и покупать понравившиеся им товары по фотографиям. К примеру, пользователь (женского пола, разумеется!) увидела в журнале красивое платье на любимой актрисе и захотела себе такое же. Она может сфотографировать его при помощи своего телефона и дать приложению поискать в базе одежды похожие товары, выставленные в интернет-магазинах.

Конечно, распознавание и подбор похожей одежды не всегда идеален, но может серьезно помочь в таких задачах. И при помощи графических процессоров компании Nvidia сервис Cortexica применяет довольно сложные алгоритмы по распознаванию изображений в реальном времени среди миллионов продуктов, используя не слишком сложную серверную инфраструктуру. Генеральный директор компании Cortexica заявил, что графические ускорители Nvidia справляются с их сложными алгоритмами в десятки раз быстрее, по сравнению с CPU. Немудрено, что GPU-ускорители появляются во все большем количестве мощных суперкомпьютеров.

GPU-ускоренная трассировка лучей в Iray 2013

Я уже упоминал выше о том, что первый день работы конференции не отличался большим количеством мероприятий и анонсов. Во время этого «вступительного» дня проходят интересные технические сессии, посвященные разным применениям GPU в индустрии. Первой посещенной автором технической сессией был обстоятельный рассказ о применении рендеринга методом трассировки лучей (рейтрейсинга) в различных приложениях и задачах — об этом рассказывал представитель компании Nvidia — Phillip Miller. Слушателей набралось приличное количество, и сессия была действительно интересной.

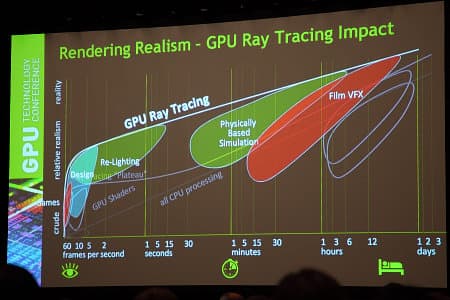

К примеру, была показана интересная диаграмма использования GPU при трассировке лучей в различных применениях, на которой демонстрировалось относительное время рендеринга в каждой задаче и его качество. Значительная доля применений GPU приходится на приложения дизайна, предрасчета освещения в приложениях реального времени (игры) и симуляцию физических эффектов.

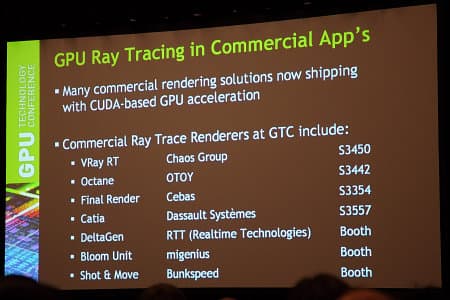

Ускоренный на CUDA рейтрейсинг применяется во множестве коммерческих приложений, включая такое ПО, как VRay RT, Final Render, Catia, Octane и другие.

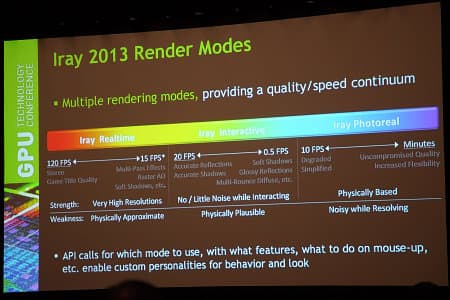

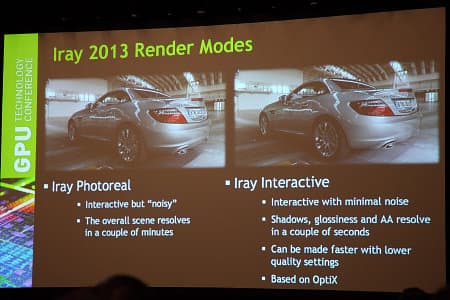

Интересным был рассказ о различных режимах рендеринга в GPU-ускоренном рендере Iray 2013. Они отличаются друг от друга качеством рендеринга (от примерного соответствия физическим законам до физически корректного фотореализма) и производительностью. Если Iray Realtime может обеспечить от 15 до 120 FPS с приемлемым качеством картинки, то Iray Photoreal хоть и потратит несколько минут, но обеспечит физически корректный рендеринг. Ну а Iray Interactive является чем-то средним между этими методами.

Два более качественных метода рендеринга в Iray 2013 были показаны на примере с рендерингом модели автомобиля, отличающимся от старой демо-программы Nvidia Design Garage лучшим качеством рендеринга, в частности — усложненным просчетом освещения. При взаимодействии пользователя со сценой (можно крутить камеру, приближать и отдалять) работает упрощенный рендеринг с минимумом шума и неплохим качеством, а в режиме «простоя» включается фотореалистичный режим, который за несколько минут отрисовывает качественное изображение с физически правильными тенями и освещением.

От себя могу сказать, что фотореалистичный режим и интерактивный уже совсем близки друг к другу по качеству. Можно с уверенностью утверждать, что 3D-разработчики будут очень довольны появлением такого рендерера, который представляет весьма интересный баланс между качеством и скоростью рендеринга.

Решения для автомобильных информационно-развлекательных систем

То, что значительная часть конференции посвящена автомобилям и применению в них современных вычислительных задач на базе решений Nvidia, стало понятно сразу же — по автомобилям, выставленным прямо в холле выставочного центра. Сначала там появился черный Lamborghini…

…а затем BMW и McLaren.

Во всех них имеются информационно-развлекательные системы, ну а самым интересным автоэкспонатом стал автомобиль Tesla Model S, который отличается мощнейшей информационно-развлекательной системой с 17-дюймовым экраном (!), основанной на базе соответствующего чипа Nvidia Tegra.

Вообще, эти электромобили эксплуатируются практически пока только в Калифорнии — по вполне понятным причинам: этот штат США вообще является оплотом экологии. Причем Tesla тут не совсем редкая, на обратной дороге в аэропорт я видел Model S на шоссе. Она стремительно обогнала наш лимузин и умчалась вперед — с динамикой и разгоном у нее тоже все в порядке.

Но давайте начнем с последнего ключевого выступления, которое проводил Ralph V. Gille — вице-президент Chrysler по дизайну и президент подразделения компании SRT (Street and Racing Technology), известной спортивными автомобилями. Он начал работу в компании на этих позициях со времен Chrysler 300 — достаточно известного седана, появившегося в 2003 году.

Выступление Ральфа было зрелищным и интересным — особенно для интересующихся автомобильным дизайном. Он показывал на слайдах и рассказывал, как сильно изменилась автоиндустрия с применением в ней компьютеров и соответствующих технологий. Вполне понятно, что молодые инженеры вовсе не работают с настоящими чертежами, а делают все в виртуальном поле — на компьютерах.

Профессиональные решения Nvidia Quadro активно применяются многими автопроизводителями при моделировании автомобилей. Графические процессоры обеспечивают ускорение работы в различных приложениях (Catia, RTT, SolidWorks и других) по решению инженерных задач. Более эффективная работа с цифровыми моделями автомобилей позволяет производителям быстрее проектировать и выводить новые модели на рынок, да еще и экономить средства, которые были бы потрачены на производство полноразмерных макетов этих автомобилей (стоимость только одного макета в масштабе 1:1 составляет десятки тысяч долларов).

Компания Chrysler использует компьютеры для симуляции в автомобилях всего, что только можно, начиная с определения технических характеристик и заканчивая компьютерными имитациями краш-тестов еще до того, как первые прототипы построены. Неудивительно, что процесс проектирования автомобилей постоянно ускоряется. Так, если на дизайн модели Dodge Challenger, представленной в 2008 году, ушло 22 месяца, то свежий Dodge Dart разрабатывался уже лишь 18 месяцев. Немалую роль в этом играют решения компании Nvidia в том числе.

Хорошо, четырехколесные движущиеся повозки проектируются при помощи компьютерных систем, а что с мотоциклами? Да то же самое: компания Harley-Davidson использует GPU-ускоренное ПО при 3D-моделировании для сокращения времени разработки на месяцы. Matthew Gueller (главный дизайнер Harley-Davidson), выступавший на GTC от имени компании, рассказал, как его команда из восьми человек смогла значительно сократить время разработки и доводки дизайна новых мотоциклов при помощи 3D-моделирования и 3D-принтеров, которые становятся все более продвинутыми и доступными.

Harley использует весь набор ПО Autodesk, включая 3ds max, Maya, Mudbox и Alias — все они работают на рабочих станциях, оснащенных решениями линеек Nvidia Quadro и Tesla. Эти GPU-ускоренные программы помогают сократить время разработки новых деталей до нескольких часов. Matthew привел наглядный пример: раньше на разработку нового мотоцикла команда из четырех человек тратила несколько месяцев, а с новыми инструментами два человека делают полный цикл такой же работы за две недели!

Но не только в дизайне помогают компьютерные технологии; сами современные автомобили уже невозможно представить без встроенных электронных систем, которые служат и для развлекательных, и для серьезных целей. Наиболее совершенные подобные системы сочетают функции автомобильного бортового компьютера, решают навигационные и развлекательные задачи. Автомобильные концерны сотрудничают с разработчиками компактных и производительных процессоров, которые можно применить в их моделях. Nvidia выступает на этом рынке уже довольно давно, и Nvidia Tegra в автомобильных компьютерах используется не только в электромобилях Tesla Motors, которые мы уже упоминали выше, но и в продукции концерна Volkswagen, знаменитого автомобилями под торговыми марками Volkswagen, Audi, Skoda и другими.

Чтобы развить свой успех на рынке автомобильных систем, Nvidia предлагает современную модульную платформу для разработки Nvidia Jetson, которая позволит создавать и тестировать различные автомобильные приложения, такие как информационно-развлекательные системы и современные системы помощи водителю. Примеры таких систем на GTC показывал Victor Ng-Thow-Hing — представитель компании Honda.

Исследовательское подразделение этой компании давно занимается разработкой систем дополненной реальности, которые рисуют вспомогательные изображения прямо на лобовом стекле автомобиля. Системы дополненной реальности полезны в навигации и способны помочь в определении опасных маневров и снизить аварийность.

На данном примере показано, как система оценивает положение и скорость встречных автомобилей и дает информацию водителю о том, безопасен ли левый поворот на перекрестке в данный момент. Система рисует на лобовом стекле стрелку планируемого поворота и окрашивает ее в зависимости от дорожной ситуации: зеленым — если маневр безопасен, и красным — при опасности столкновения со встречным автомобилем.

Понятно, что такие задачи весьма требовательны к вычислительной мощности, и тут решения Nvidia как раз и могут помочь. Тем более, что платформа Jetson имеет стандартный установочный размер DIN для центральной консоли автомобилей, она просто вставляется в панель автомобиля для упрощения работы при создании прототипов.

Возможна поддержка нескольких аппаратных конфигураций, включая процессор Nvidia Tegra с дискретным GPU архитектуры Kepler (чип GK208 — похоже, он станет одним из первых обновленных чипов архитектуры Kepler). Комбинация ARM- и CUDA-процессора поможет автопроизводителям при разработке таких сложных приложений, как предупреждение столкновений и системы обнаружения пешеходов — с помощью Jetson можно отладить ее заранее, ускорив выход конечного решения на рынок.

Кроме этого, платформа имеет разъемы для светового табло и сенсорного экрана с дисплеем цифровой приборной панели высокого разрешения, поддерживаются Wi-Fi, Bluetooth и GPS, а также USB и HDMI/DVI. Модульный принцип конструкции предлагает вам все необходимое для моделирования возможностей будущих модулей визуальных вычислений на базе следующих чипов Tegra уже сейчас. Jetson явно является прототипом (что-то вроде devkit) для следующих чипов семейства Tegra, которые будут иметь вычислительные возможности с поддержкой CUDA.

Самое главное — долго ждать не придется. Разработчики получат первые платформы Jetson уже в этом месяце, даже раньше, чем появятся первые решения на Tegra 4. А ранние прототипы этой платформы уже есть у некоторых автопроизводителей и самых важных партнеров компании Nvidia.

Новые демонстрационные программы

На GTC показывали не только такие серьезные вещи, как GRID VCA или планы Nvidia на ближайшие годы. В рамках своего выступления Дженсен Хуанг почти всегда показывает новые демонстрационные программы, раскрывающие возможности графических процессоров Nvidia. Естественно, речь зашла о новых возможностях самого мощного графического решения компании Geforce GTX Titan, на которых основан и быстрейший в мире суперкомпьютер Titan Окриджской национальной лаборатории.

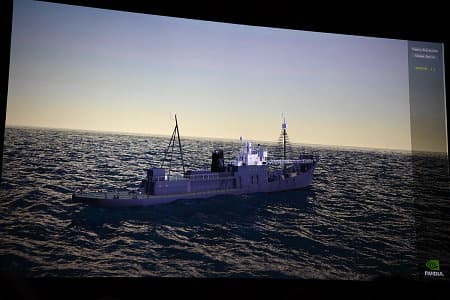

Нет, тигра (на снимке) в реальном времени рендерить еще не научились, он из фильма Жизнь Пи, в создании визуальных эффектов к которому участвовали графические процессоры компании Nvidia. Но в реальном времени Titan умеет запускать симуляцию водной поверхности океана с волнами разного размера по шкале Бофорта (Real-Time Beaufort-Scale Ocean Simulation). Демонстрационная программа имитирует волны визуально правдоподобно и физически реалистично.

Сначала Дженсен рассказал и показал, как симуляции поверхности океана в реальном времени выглядели до сих пор — волны реалистичные, но они все примерно одинаковые и повторяющиеся, а также нет имитации брызг и пены, и поверхность не взаимодействует с имитируемым ветром.

После этого публике было показано усиление ветра и шторма в современной демо-программе компании Nvidia. При усилении ветра волны взаимодействуют с ним и видоизменяются, становясь все сильнее. Появляется пена на поверхности воды и брызги от волн, а также симулируется и выглядит правдоподобно дым от силовой установки корабля. Данная имитация учитывает такие параметры, как размер корабля, его скорость, сила волн, а также скорость и направление ветра.

Интересно в демке океана еще и то, что в ее разработке принимал непосредственное участие сотрудник московского офиса компании Nvidia. Если вы помните предыдущую демку Nvidia Realistic Water Terrain, также известную как Island, там поверхность воды уже была неплохо имитирована, но тут степень реализма вышла на совершенно другой уровень.

Но ведь симуляция человеческого лица и его эмоций еще сложнее. Выражение лица человека постоянно меняется, с его помощью мы общаемся с людьми, и количество лицевых мышц составляет пару десятков. Имитация наших эмоций уже может быть довольно реалистичной. Но тут есть еще одна проблема. Дженсен на выступлении упомянул интересный факт: на каком-то этапе симуляция человеческого лица становится близкой к реалистичной настолько, что объект, выглядящий почти как человек, но все-таки не как человек, вызывает неприязнь у людей. Этот эффект называется эффектом «зловещей долины» (uncanny valley).

Когда в анимации показываются лица, лишь отдаленно похожие на человеческие (множество мультипликационных фильмов), то это вызывает положительные эмоции, но в случае с персонажем Анжелины Джоли в анимационном фильме Beowulf, где она играет роль матери Гренделя, ее анимированный человеческий облик вызывает неприязнь. Чем больше персонаж похож на человека, тем симпатичнее он для людей, но лишь до определенного предела — самые человекоподобные лица оказываются неприятны людям из-за мелких несоответствий реальности, которые мы улавливаем, а анимация усиливает это восприятие.

Nvidia в своих демках всячески старается создать человекоподобные реалистичные лица. К примеру, известный персонаж Dawn — фея из предыдущих демонстраций компании. Тон кожи и волосы феи довольно реалистичны, она выглядит похожей на настоящую девушку. Но в движении Dawn все-таки выглядит слегка странно и даже несмотря на общую миловидность, анимированная фея выглядит слегка коряво. Дженсен не очень доволен этим фактом:

Видимо, именно поэтому Nvidia вместе с Южно-Калифорнийским университетом (University of Southern California) разработала более реалистичную анимацию человеческого лица. Для этого с актера захватываются и записываются несколько десятков разных выражений лица при помощи специальной сцены со множеством источников света и камер. Все захваченные изображения специальным образом конвертируются при помощи технологии Face Works из 32 гигабайт данных — в несколько сотен мегабайт информации в виде 3D-моделей. Технология позволяет захватывать данные о лице человека с большой точностью без использования специальных маркеров и камер.

Графические процессоры Nvidia затем синтезируют и отрисовывают анимированные модели с использованием тесселяции и результат получается очень реалистичный. Используются очень сложные шейдеры для имитации кожи, содержащие более 8000 инструкций на пиксель, которые делают поверхности и освещение столь правдоподобными. На каждый пиксель производится по 161 отфильтрованных текстурных выборки, а при рендеринге в разрешении 1920×1080 за каждый кадр обрабатывается 82 миллиарда операций с плавающей запятой (FLOPs) — это почти 5 триллионов операций в секунду при 60 FPS.

Неудивительно, что Ira (так назвали цифрового персонажа демки) выглядит гиперреалистично. Вдобавок ко всему вышесказанному можно отметить качественные мягкие тени и достоверную имитацию глаз. В движении Ira выглядит еще реалистичнее, ведь анимации различных выражений лица можно смешивать друг с другом и плавно переходить от одной к другой эмоции. А еще Ira умеет говорить. Дженсен «попросил» его сказать, что он ел на завтрак и о его впечатлениях о Project Shield. На последний вопрос Ira ответил так: «Возьмите мои деньги!» И похоже, что этого хочет не только он.

Если у вас остались какие-то вопросы по изложенным в материале темам, или вы хотите ознакомиться с другими материалами, освещенными на технологической конференции Nvidia, то все записи основных выступлений и прочих сессий доступны для всех интересующихся на сайте GTC.

В заключение предлагаем вам видеообзор, посвященный итогам конференции: